SEO-Insights, die du aus Server-Logdateien

ziehen kannst

ziehen kannst

Damit du das Problem besser entwirren kannst, muss ich zuerst die Frage klären: Wie funktioniert eigentlich eine Suchmaschine?

Dieser komplizierte Prozess umfasst drei große Stufen:

Was sind Server-Logdateien?

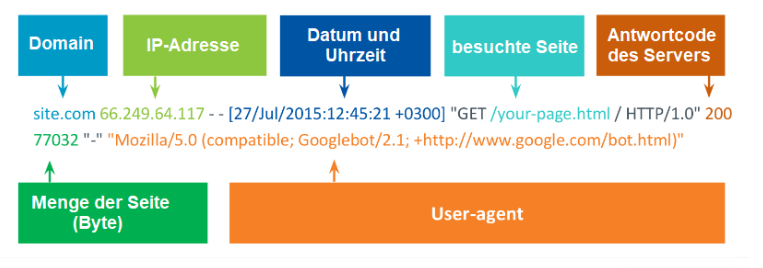

- Domain.

- IP-Adresse, von der aus der Zugriff erfolgte.

- Zeit des Seitenaufrufes.

- Zielseite, die der Crawler besuchte.

- Statuscode der Antwort, die sowohl Suchroboter als auch Personen erhalten.

- Größe der Seite (Byte).

- User Agent: Name des Benutzers, der sich an den Server wandte. So erfährst du, welcher Browser oder Roboter die Seite aufrief.

Wo findest du Server-Logdateien?

Die Logdateien, die auf deinem Server verfügbar sind, findest du unter den folgenden Adressen:

Nginx /var/log/nginx/access.log

IIS %SystemDrive%\inetpub\logs\LogFiles

So befinden sich zum Beispiel die Nginx-Logdateien unter der Adresse /var/log/nginx/ oder /usr/local/nginx/logs. Die Einstellungen prüfst du im Verzeichnis /etc/nginx/.

Wenn du die Logdateien finden willst, suche nach "access_log" im ganzen Verzeichnis. Die Apache-Server-Logdateien sind unter /etc/apache2/ verfügbar. Für die Logfiles sind die Einstellungen ErrorLog und CustomLog verantwortlich.

Möchtest du persönliche Serpstat-Demonstration, die Testversion oder erfolgreiche Use-Cases bekommen? Sende eine Demo-Anfrage und unser Support-Team kontaktiert dich ;)

Probiere es selbst aus:

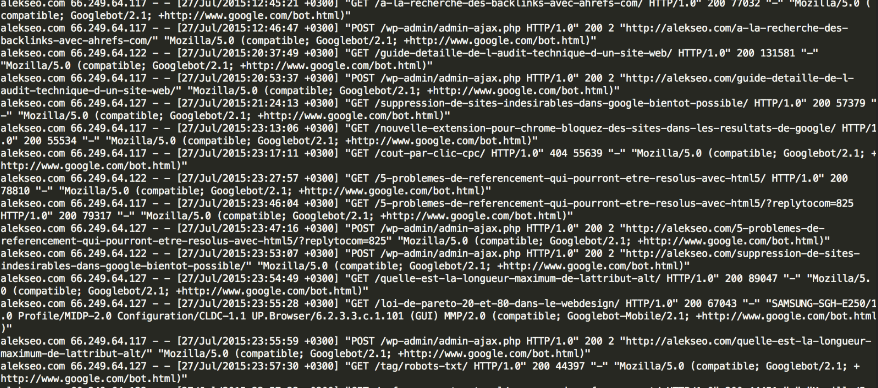

Was erfährst du mit Hilfe vom Googlebot?

Was erfährst du mit Hilfe vom Googlebot?

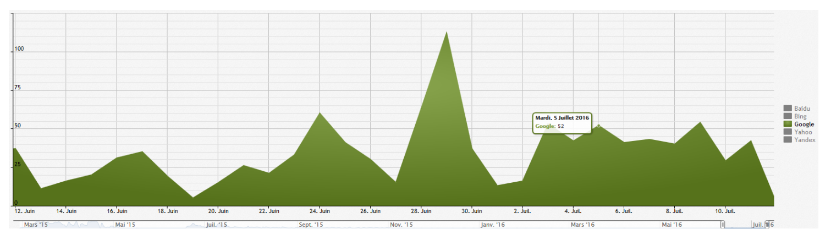

Die Logdateien analysierend bist du in der Lage, den Google-Panda-Filter zu verfolgen, wenn der Crawling-Umfang stark gesunken ist.

Die Analyse der Server-Logdateien ist eine der zuverlässigsten Datenquellen zur Frage, wie die Suchmaschine die Website aufnimmt.

Googlebot und inaktive Links

- Hast du eine Website zur Analyse?

- Verwende die Google Search Console, um den Roboter zum Crawling der Seite zwangsweise aufzufordern;

- Prüfe die Logdateien, um festzustellen, ob die Seiten die Informationen richtig darstellen.

Ich werde erklären, was da herauskommt.

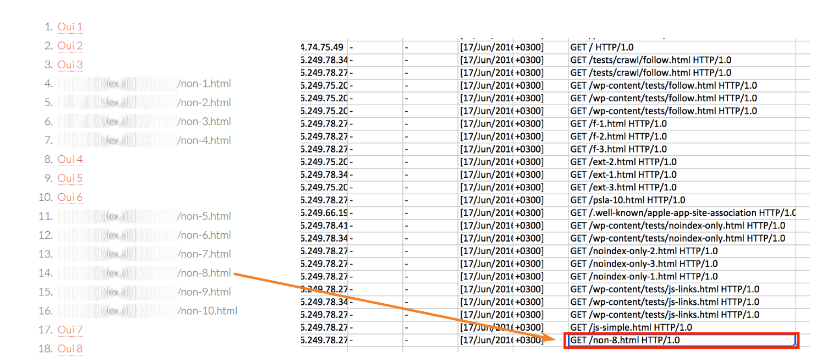

Die Datei wurde zur Search Console hinzugefügt und der Roboter rief alle Links auf, die anklickbar waren. Trotzdem entstanden in ein paar Tagen in den Server-Logdateien die folgenden Adressen:

Googlebot und robots.txt

Beachte bei der Arbeit mit der Datei auch die wichtigen Aspekte:

Titel und Beschreibung, die im Snippet angezeigt werden, entsprechen dabei keinen wirklichen Tags. Stattdessen steht eine Anmerkung, dass die Beschreibung wegen der Einschränkungen von der robots.txt-Datei nicht verfügbar ist.

Der Googlebot sieht die gesperrten Seiten, obwohl er sie nicht aufrufen kann. Deswegen benutzt er externe Signale — Anchor von Backlinks, die zu deiner Seite führen. Das heißt, er zeigt dem Benutzer, dass diese Datei existiert, auch wenn sie nicht verfügbar ist.

Der Roboter stellt den Seitenkopf dar, den er von den Ankertexten abrechnete. Die gespeicherte Kopie der Website existiert auch nicht.

Beispiel. Wenn ich den Bericht über die Besucherzahl, ungefähr 100.000 pro Tag, untersuche (die Immobilien-Website), bemerke ich auch, wie oft die robots.txt-Datei besucht wurde. Sie bekommt circa 50 - 100 Besuche pro Tag.

SEO-Anfänger erhalten oft folgende Aufgabe: Müllseiten auf der Website zu finden und sie zu löschen.

Wie erfüllt er diese Aufgabe?

Er verwendet alle Tools, die ihm zur Verfügung stehen. Zuerst sperrt er die Seiten in der robots.txt-Datei, und dann gibt er den Tag <meta name="robots" content="noindex"> ein. Die Folgen sind natürlich erstaunlich. Trotz der Erwartung bleiben die Seiten im Index ganz gleich.

Das ist passiert, weil diese Aktionen in Konflikt kommen: Einerseits schließt er die Seiten aus dem Index aus, andererseits verweigert er den Zugriff auf die Seiten. In der Tat sieht der Googlebot keinen Inhalt von diesen Seiten.

Deswegen benutze besser den Tag meta name="robots", um die Müllseiten loszuwerden. Der Robot scannt alle Dateien und bestimmt, was er löschen muss. Dann gebe diese Seiten in die Datei robots.txt ein.

Aufgabe: Unnötige Seiten aus dem Index löschen.

Gängiger Fehler: robots.txt + meta name="robots" "noindex".

Richtige Lösung: meta name="robots" content="noindex". Stelle zuerst fest, ob die Seiten nicht im Index dargestellt werden und dann korrigiere die robots.txt-Datei.

Googlebot und URLs mit Hashtags

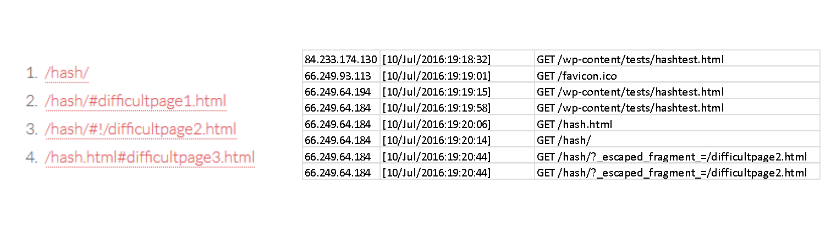

Experiment. Ich habe die Seite mit folgenden Linktypen erstellt:

- Der Link mit dem Hash, der zu einem Abschnitt der Seite führt.

- Der Link mit dem Hash und dem Ausrufezeichen.

Der Googlebot erkennt keine Links mit # in URLs und versteht nur die mit Hashbangs #!. Die Server-Logdateien spiegeln diese Tatsache. Google transformiert die Seite und statt #! ergänzt es ?_escaped_fragment_=/

Unter dieser Adresse kann es den Seiteninhalt erreichen. Obwohl die Ergänzung ?escaped_fragment_ noch beim Crawling funktioniert, wird sie aber nicht von Google empfohlen.

Was ist ein Crawl-Budget und wie wird es ausgeschöpft?

Daraus folgt, dass Google wenigstens einmal alle drei Monate jede von diesen Seiten besuchen sollte. Um diesen Plan in die Tat umzusetzen, muss es jede Sekunde 77 Millionen Seiten crawlen. Da dies eine sehr anspruchsvolle Herausforderung ist, wurde das Crawl-Budget eingesetzt.

Das Crawl-Budget ist eine Prozessorzeit, die die Suchmaschine für das Crawling der bestimmten Seite braucht. Der Hauptfaktor, der das beeinflussen kann, ist die Effizienz der Seite.

Jeder SEO-Spezialist ist in der Lage, die Gesamtquote der Website richtig aufzuteilen.

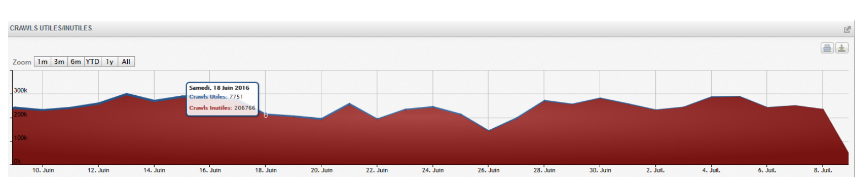

Beispiel. Statistiken von einer großen Immobilien-Website. Die rot markierte Fläche in der Grafik entspricht dem nutzlosen Crawling, das mit den Zugriffen auf die Website nicht begleitet wird. Der blaue Strich zeigt, wann der Roboter die Seiten besuchte.

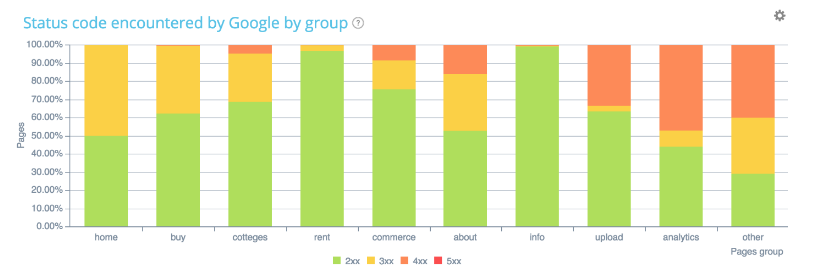

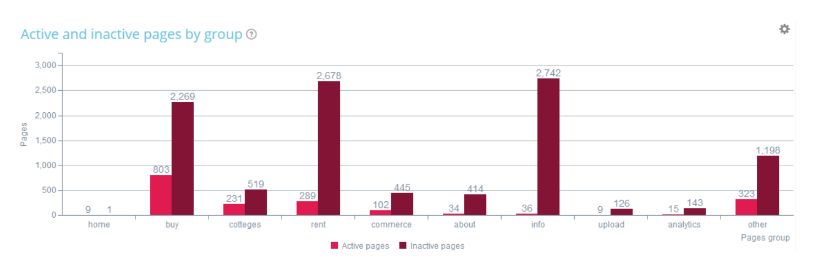

Noch ein Beispiel. Immer wieder die Immobilien-Website. Ich nehme an, dass beim heutigen Marketing der Abschnitt „Analytik" auf der Prioritätenliste steht. Trotzdem crawlt der Roboter nur 41 % der Seiten, die diesen Abschnitt enthalten.

- Stimmen deine Priorität-Seiten und die Präferenzen des Google-Robots überein?

- Stimmen deine Priorität-Seiten und die Präferenzen des Google-Robots überein?

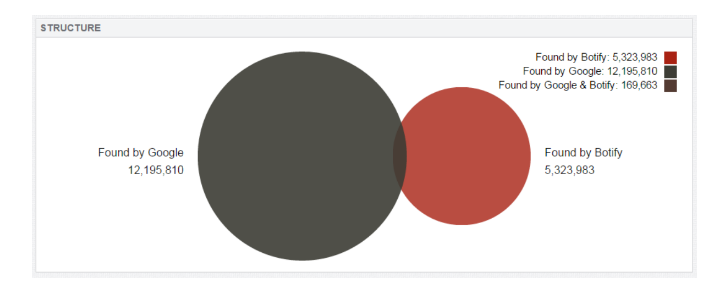

Noch ein Beispiel. Ein umsatzstarker Online-Shop (ungefähr 10 Millionen Zugriffe pro Monat) hat fünf Millionen Seiten, die beim Scannen selbstständig gefunden werden. Allerdings gibt es noch zwölf Millionen Seiten, die dem Roboter bekannt sind. Sie werden verwaiste Seiten genannt und unterliegen einer sorgfältigen Analyse.

2. Verwaiste Seiten

- Seiten, die nur externe eingehende und keine interne Links enthalten.

- Seiten mit Fehlern, die sich in Google-Dateien befinden, obwohl sie korrigiert wurden.

- Nicht mehr aktuelle Seite mit dem Code 200 OK.

- Umgezogene oder verschobene Seiten.

- Seiten mit den Fehlern in rel=«canonical» und sitemap.xml.

3. Aktive Seiten

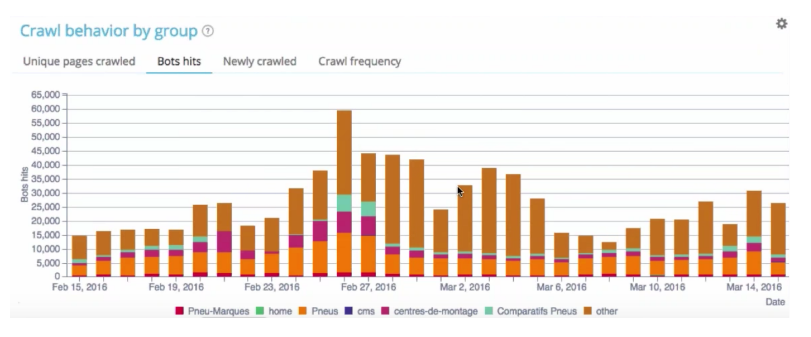

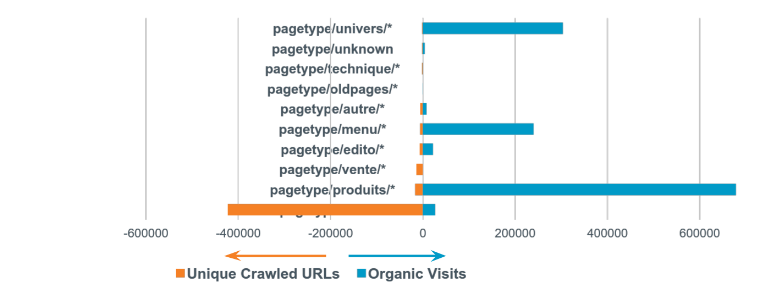

An dem Beispiel vom Spiele-Online-Shop (1 Million Besuche über die organische Suche) demonstriere ich das. Links werden die Googlebot-Besuche der Kategorien und rechts alle Zugriffe auf der Website dargestellt.

Die Ergebnisse zeigen, dass das Crawl-Budget und Roboter-Ressourcen nutzlos verschwendet werden. Dies ist ein sehr großes Problem.

Wie bewertest du die Seiten-Effizienz und womit solltest du die Optimierung beginnen?

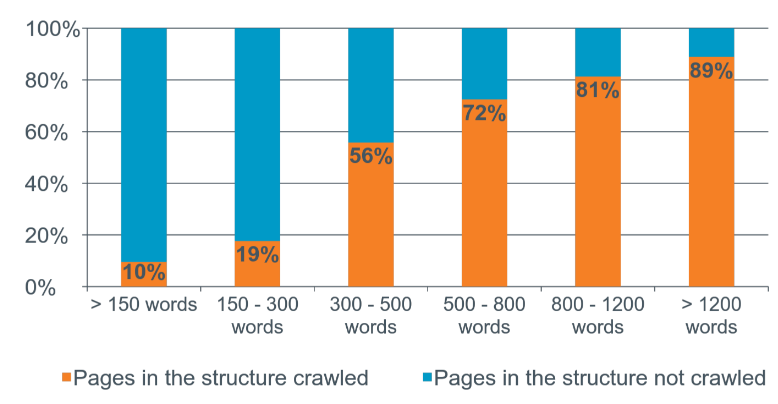

Wie lang muss dein Content auf der Seite sein?

Beispiel. Die Website, die sich auf den Autoverkauf spezialisiert.

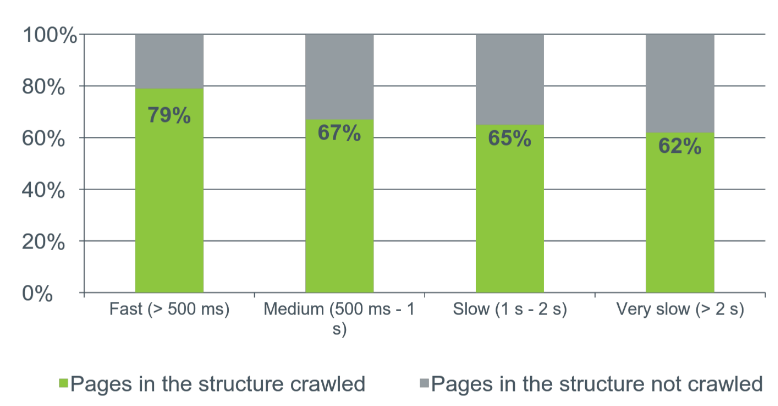

Crawling und Ladezeit

Das Experiment kann an dieser Grafik beispielhaft erläutert werden:

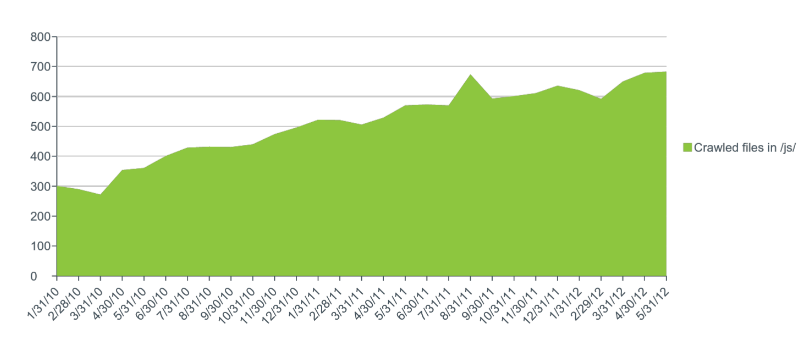

Globale Trends des Googlebot-Verhaltens

Beispiel. Die Grafik zeigt, dass die Zugriffszahlen auf JavaScript-Files steigen. Dies ist mit dem Umstand verbunden, dass der Googlebot sich an die Optimierung für die Mobilgeräte orientiert.

Verfolge Leistungen von ergriffenen Maßnahmen

Fixiere die folgenden Aspekte:

- Steigerungen und Rückgänge;

- Folge der Veränderungen;

- Leistung des Seitenumzugs;

- Ergebnisse des Verlinkens usw.

Zum Schluss

Audit

- Analysiere die Logdateien 30 - 60 Tage: Menge der gesendeten Daten, Themen, Probleme.

- Versuche, die Wechselwirkungsanalyse anzuwenden: Crawling + Logdateien + Google Analytics.

- Untersuche aktive und nutzlose Seiten sowie alle Seitenbereiche, die Google indexiert.

Monitoring

- Lade zum Monitoring deine täglichen Logdateien in verschiedene Datenverarbeitungssysteme hoch. So kannst du Benachrichtigungen über Fehler, Steigerung und Rückgang des Crawlings, Angriffe sowie Scannen der neuen Seiten bekommen.

- Dieses Verfahren ist bei Neugestaltung und Website-Umzug erforderlich. So bemerkst du gleich, wie die Veränderungen die Seite beeinflussten.

- Es gibt eine Reihe von kostenlosen und kostenpflichtigen Tools, die für die Logdateien-Analyse entwickelt wurden.

Fazit

- Bewerte Linkbuilding-Kampagnen auf der Grundlage von erhöhtem Crawling-Budget und Häufigkeit.

- Finde die Merkmale der Anti-Spam-Filter von Google heraus.

blog_main_page_trial_form_header

article_trial_block_first_line

article_trial_block_second_line

discover_more_seo_tools

seo_seo_block_title_1

seo_seo_block_text_1

seo_seo_block_title_2

seo_seo_block_text_2

seo_seo_block_title_3

seo_seo_block_text_3

seo_seo_block_title_4

seo_seo_block_text_4

Empfehlungen

Cases, Lifechaks, Studien und nützliche Artikel

Hast du keine Zeit, um auf dem Laufenden zu bleiben? Kein Problem! Unsere Lieblingsredakteurin Stacy sammelt für dich die besten Artikel, die dir unbedingt bei der Arbeit helfen. Trete unserer Community bei :)

Wenn du auf die Schaltfläche zum Absenden klickst, stimmst du den Nutzungsbedingungen und der Datenschutz-Policy von Serpstat zu.