Robots.txt-Datei: Anleitung für SEO

Was sind Robots?

Robots werden vor Allem dazu genutzt, um Webseiten für die Suchmaschinen zu indizieren. Die beiden bekanntesten Vertreter in dieser Branche sind Google und Bing. Es gibt aber auch andere Anbieter, die sich auf bestimmte Marktsegmente, wie z. B. den medizinischen Sektor, spezialisiert haben.

Robots Exclusion Standard

Einhaltung ist freiwillig

Verhalten der Robots

Rolle der Robots für SEO

Unterschied zum Robots-Meta-Tag

<meta name="robots" content="(index | noindex), (follow | nofollow)">

Im Unterschied zur Robots.txt-Datei gilt das Meta-Tag aber nur für die aktuelle Unterseite und ist von den Funktionen her stark eingeschränkt. Außerdem lassen sich nur HTML-Dokumente vor der Indizierung schützen — Verzeichnisse und Dateien bleiben außen vor.

Erstellung einer Robots.txt-Datei

Die Robots.txt-Datei muss:

Syntax der robots.txt

Beispiel einer Robots.txt-Datei:

# 1. Block

User-agent: Googlebot-Image # Name

User-agent: Googlebot-Video # Name

Disallow: /media/ # Regel

Disallow: /*.mp4$ # Regel

# 2. Block

User-agent: *

Disallow: /temp/

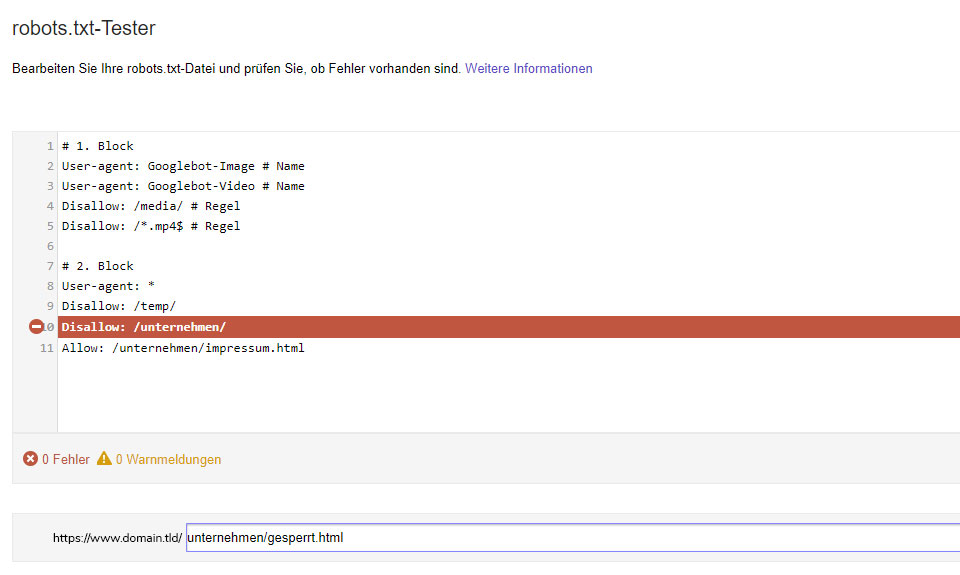

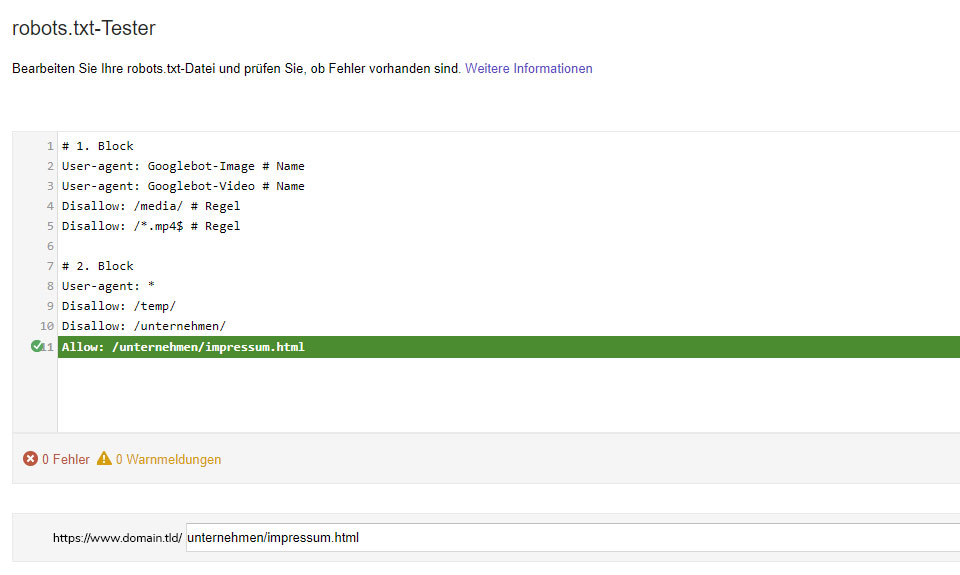

Disallow: /unternehmen/

Allow: /unternehmen/impressum.htmlUser-agent

User-agent: Googlebot-Image

User-agent: Googlebot-Video User-agent: * - Googlebot. Der wichtigste Crawler von Google zum Indizieren von Websites in der mobilen Version und Desktop-Ansicht.

- Googlebot-Image. Dieser Googlebot indiziert die Bilder auf einer Website.

- Googlebot-Video. Ein auf Videos spezialisierter Crawler.

- Googlebot-News. Webcrawler speziell für das Google Nachrichten Angebot.

- Mediapartners-Google. Ein Crawler speziell für AdSense, der sich mit dem Googlebot einen gemeinsamen Cache teilt und doppelte Seitenaufrufe zu vermeiden.

- AdsBot-Google. Überprüfung der Anzeigequalität von Google Ads auf Desktop Geräten.

- AdsBot-Google-Mobile. Ein Crawler zur Prüfung der Anzeigenqualität von Google Ads auf mobilen Endgeräten.

- APIs-Google. Über diesen User-agent werden die Push-Benachrichtigungen den Google-APIs übermittelt.

- Bingbot. Der Standard Crawler von Bing zur Indizierung von Websites in mobiler und Desktopansicht.

- MSNBot. Ein Crawler, der dem Bingbot voraus geschickt wird, um erste Daten zu erheben.

- MSNBot-Media. Dieser Bot ist auf Bilder und Videos spezialisiert.

- AdIdxBot. Ein Webcrawler zur Qualitätskontrolle der Anzeigen mit Bing Ads auf mobilen und Desktop Geräten.

- BingPreview. Zum Rendern von Vorschauseiten in mobiler und Desktop Ansicht.

Allow und Disallow

User-agent: *

Disallow: /User-agent: *

Disallow: /temp/User-agent: *

Disallow: /temp/

Allow: /temp/images/

Allow: /temp/videos/User-agent: *

Disallow: /test*/ User-agent: *

Disallow: /*test*/ User-agent: *

Disallow: /*.pdf$ Zusätzliche Optionen

- Sitemap. Der Link zur Sitemap sollte natürlich direkt in der Google Search Console und den Webmastertools von Bing hinterlegt sein. Für alle anderen Crawler ist der zusätzliche Eintrag einer Sitemap in der Robots.txt-Datei aber hilfreich.

Sitemap: https://www.domain.tlp/linkzursitemap.xml

- Crawl-Delay. Um den Traffic durch Suchmaschinen etwas zu verteilen und den Server zu entlasten, kann die Zeitspanne zwischen den Anfragen manuell festgelegt werden. In der Praxis hat diese Regel allerdings kaum Bedeutung, denn sie wird von Google und Bing ignoriert.

Crawl-delay: 60

Verarbeitung der Robots.txt-Datei

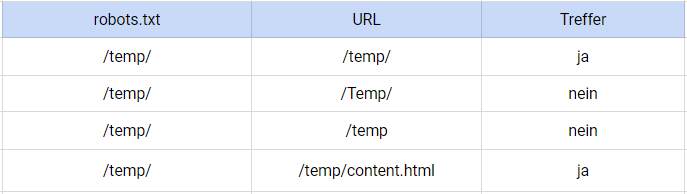

Ergebnisse eines Vergleiches:

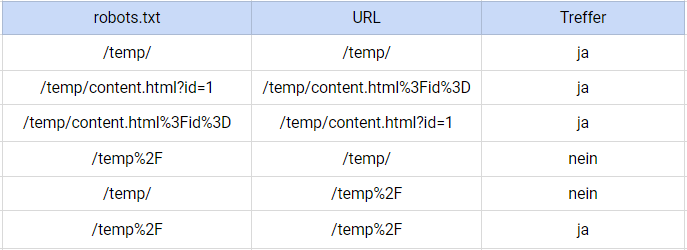

Ergebnisse eines Vergleiches mit URL-Kodierung:

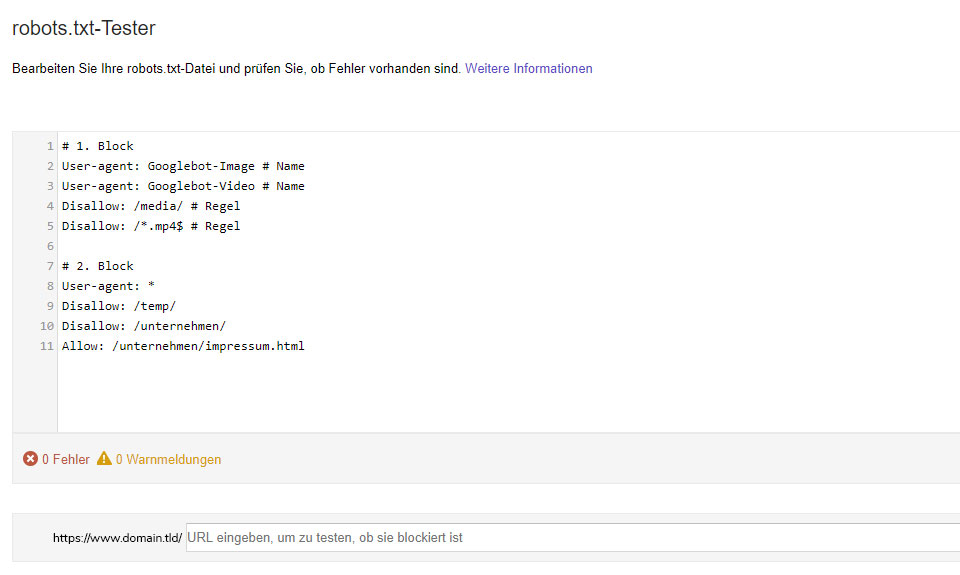

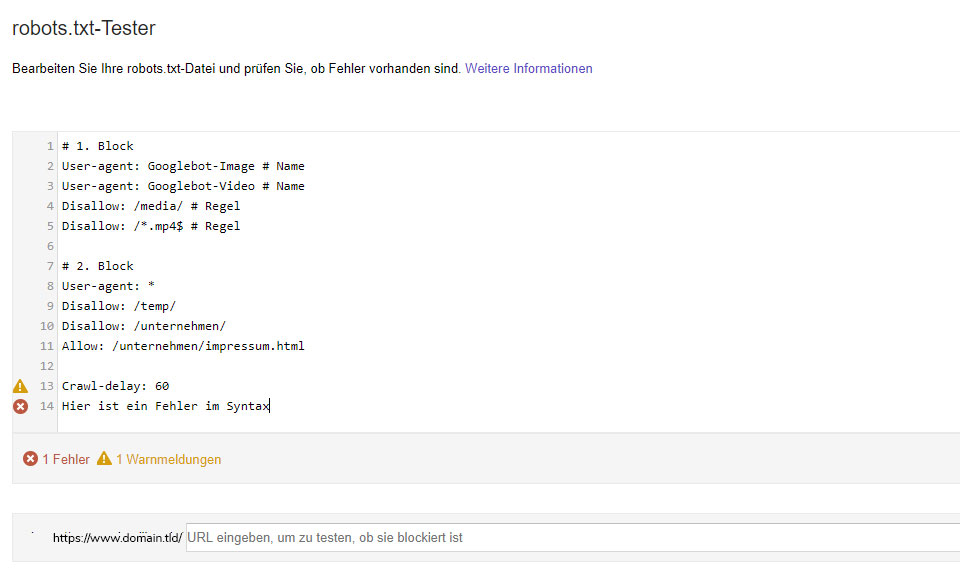

Case Study: Syntax check mit der Search Console

Zunächst testen wir das Beispiel der Robots.txt-Datei aus diesem Beitrag weiter oben. Wie zu erwarten werden hier keinerlei Probleme festgestellt:

Möchtest du persönliche Serpstat-Demonstration, die Testversion oder erfolgreiche Use-Cases bekommen? Sende eine Demo-Anfrage und unser Support-Team kontaktiert dich ;)

Nachwort des Autors

blog_main_page_trial_form_header

article_trial_block_first_line

article_trial_block_second_line

discover_more_seo_tools

seo_seo_block_title_1

seo_seo_block_text_1

seo_seo_block_title_2

seo_seo_block_text_2

seo_seo_block_title_3

seo_seo_block_text_3

seo_seo_block_title_4

seo_seo_block_text_4

Cases, Lifechaks, Studien und nützliche Artikel

Hast du keine Zeit, um auf dem Laufenden zu bleiben? Kein Problem! Unsere Lieblingsredakteurin Stacy sammelt für dich die besten Artikel, die dir unbedingt bei der Arbeit helfen. Trete unserer Community bei :)

Wenn du auf die Schaltfläche zum Absenden klickst, stimmst du den Nutzungsbedingungen und der Datenschutz-Policy von Serpstat zu.