Начните искать ключевые слова

Используйте Serpstat, чтобы находить лучшие ключи

Почему не индексируется сайт?

Google пока не нашел ваш сайт

- Как добавить сайт в Гугл вебмастер (Google Search Console)?

Сайт или страницы закрыты в robots.txt

Включены приватные настройки

Сайт закрыт от индексации в noindex в метатегах

Ошибки сканирования

Сайт заблокирован в .htaccess

Хостинг или сервер работает нестабильно

Проблемы с AJAX/JavaScript

У вас на сайте много дублированного контента

Очень медленная скорость загрузки сайта

Ваш домен ранее был забанен

У вас нет sitemap на сайте

FAQ

Выводы

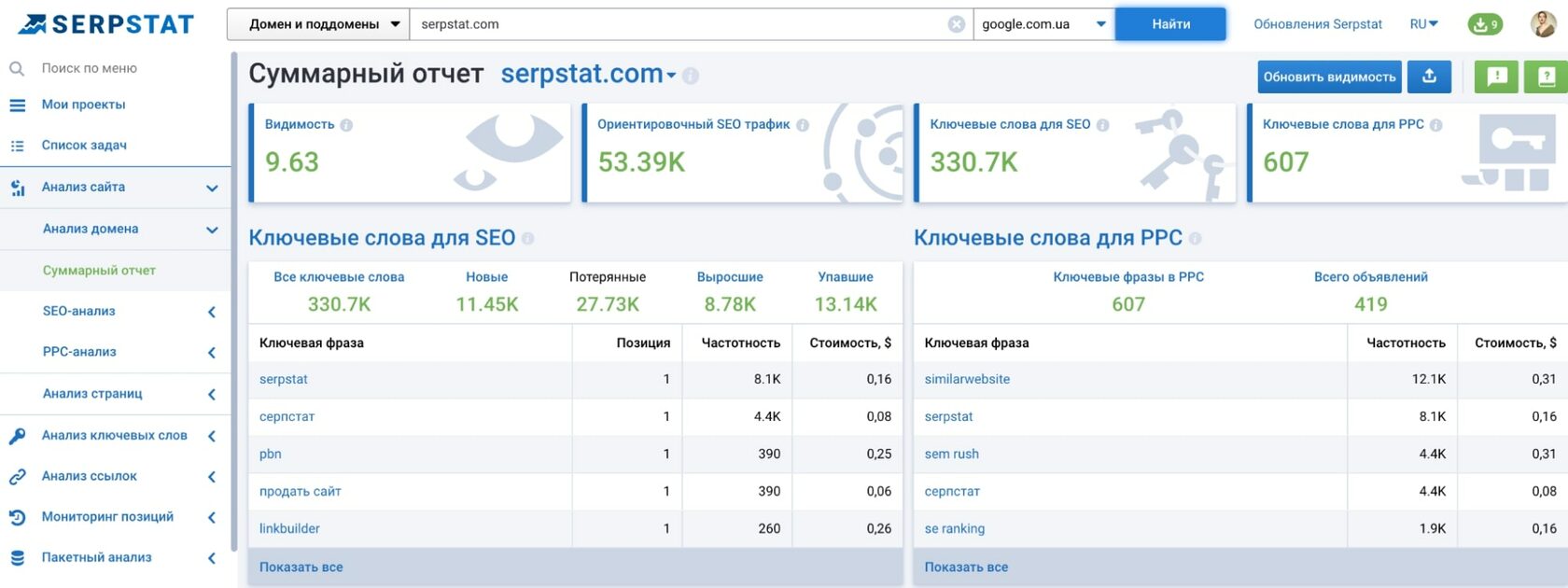

Как проверить индексацию сайта

Чтобы узнать, насколько ваш сайт «виден» поисковикам, достаточно ввести адрес домена в поисковую строку и нажать «Поиск». Данный показатель относительный и его нужно смотреть в сравнении с основными конкурентами.

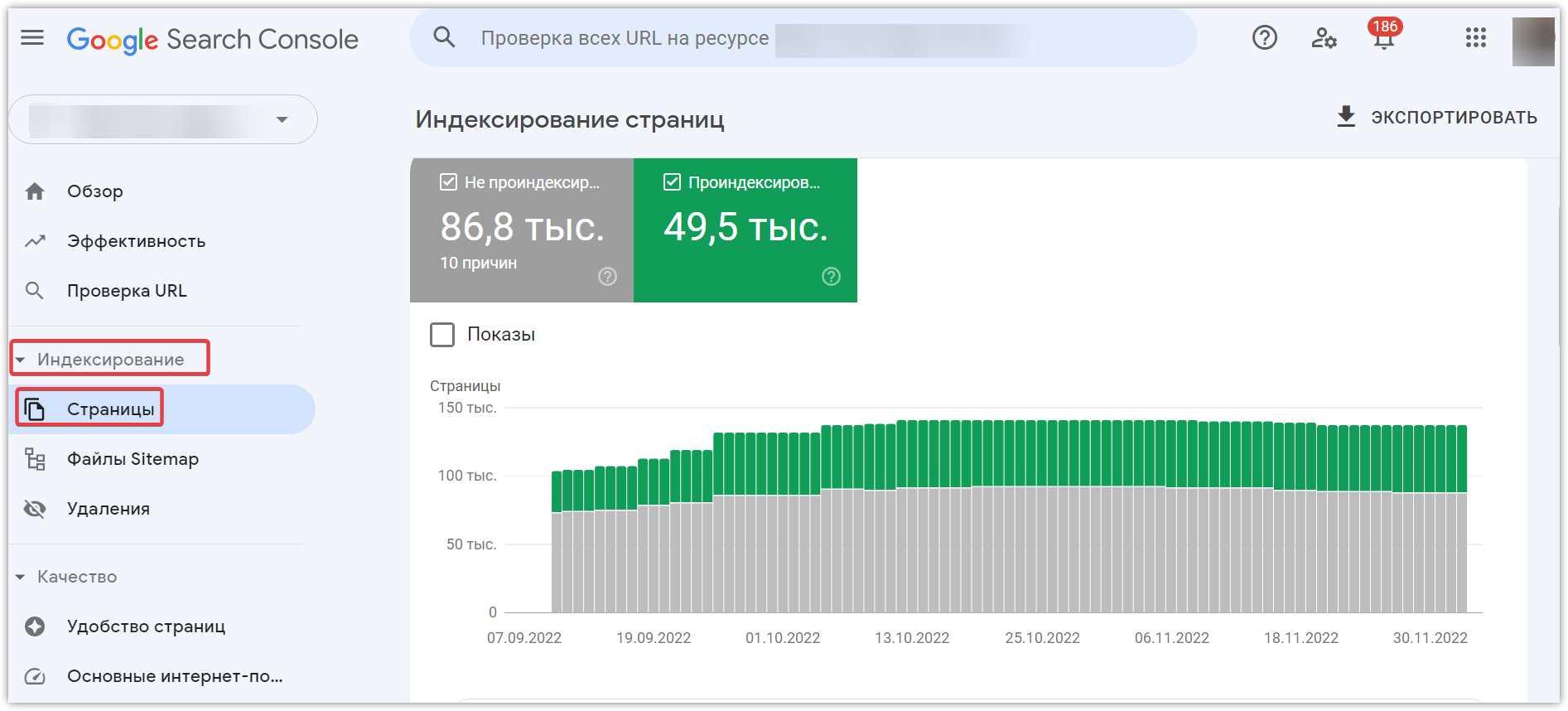

Самый простой способ узнать, индексируется ли ваш сайт, – воспользоваться панелью вебмастера. Для этого нужно иметь к ней доступ (почта в Google, регистрация-идентификация). Если доступ получен, то заходим в Панель, находим меню Search Console, достаем вкладку Индекс Google. В ней выбираем и смотрим Статус индексирования.

Google пока не нашел ваш сайт

Если сайту больше 6 месяцев (максимальное время зависания в Песочнице), то его «видимость» могут сдерживать фильтры поисковых систем. Потому что им не нравится, если контент на сайте не уникальный (стыренный у других авторов), а его содержание выходит за рамки морали, пропагандирует насилие или не имеет подтвержденной экспертизы. Пример: на сайте про лечебные средства отсутствуют имена и биографии авторов, которые их рекомендуют.

Если сайт не молодой, и с контентом все в порядке, то в теории нужно дать поисковым системам время на индексирование сайта в Гугле – минимум 2 недели.

Правда, процесс можно ускорить, чтобы поисковики быстрее увидели сайт, его нужно вручную добавить в поисковую систему (Add url), а также в Google Search Console.

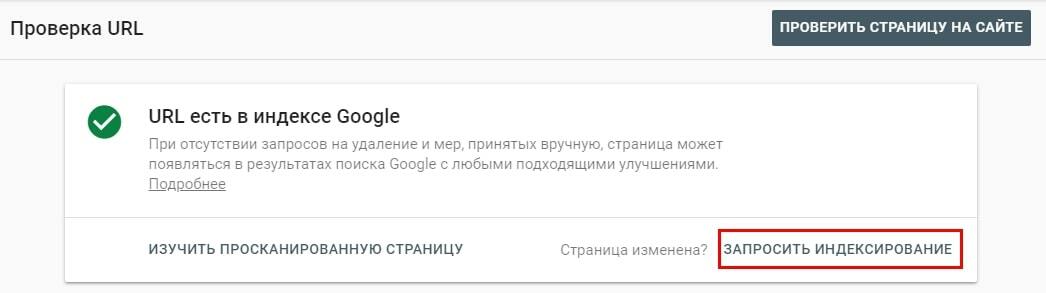

Как добавить сайт в Гугл вебмастер (Google Search Console)?

- Открываем Google Search Console – раз!

- Переходим в Инструмент проверки URL – два.

- Вставляем в строку поиска URL, который нужно сделать видимым в индексе Google – три.

- Ожидаем, пока Google проверяет адрес – четыре.

- Нажимаем кнопку «Запросить индексирование» – пять!

Сайт или страницы закрыты в robots.txt

- User-agent: Googlebot

- User-agent: AdsBot-Google

- User-agent: Googlebot-Image

Включены приватные настройки

Сайт закрыт от индексации в noindex в метатегах

Появление meta noindex nofollow означает, что интернет-боты не должны трогать (индексировать) эту страницу. Причина запрета может быть в том, что страница имеет временное содержимое, быть версией для печати или содержать приватную информацию. Детальную инструкцию, какие страницы нужно закрыть от индексации, смотрите на нашем сайте.

Вот как meta noindex выглядит в HTML-документе, блокируя этим бота Google:

<meta name="googlebot" content="noindex"><meta name="msnbot" content="noindex">Наличие метатега robots в коде страницы в сочетании со словом noindex показывает поисковым роботам запрет на индексирование сайта в Гугл.

Выглядит robots txt noindex в HTML-документе вот так:

<meta name="robots" content="noindex">Ошибки сканирования

- Ошибки в настройках сервера (серверов).

- Сбои CMS (система управления контентом).

- Изменение структуры URL.

Сайт заблокирован в .htaccess

В коде запрет доступа по IP адресу к файлу file.php выглядит вот так:

<Files file.php>

Order Deny,Allow

Deny from all

Allow from Ваш IP адрес

</Files> Чтобы проверить, находим на сервере файл .htaccess. Высматриваем в коде, не были ли когда-то закрыт сайт или его часть. Редко кто думает в этом направлении, но этот вариант обязательно нужно проверить, когда ищешь причины, почему сайт закрыт от поисковика.

Хостинг или сервер работает нестабильно

Контроль за состоянием доступа к сайту ведем с помощью множества сервисов. Подбираем их в поисковиках по запросу uptime checker – получаем множество вариантов сервисов, которые позволяют отследить стабильность работы хостинга. А также читаем нашу статью, как выбрать надежный хостинг для сайта, если услуга доказано некачественная.

Проблемы с AJAX/JavaScript

У вас на сайте много дублированного контента

Дублированный контент может быть в страницах, а может и в метатегах. Чтобы исключить дублированный контент, нужно сначала отыскать все дубликаты страниц на сайте, а потом удалить их или закрыть от индексации. Читайте, нашу статью про то, как найти и удалить дубли страниц на сайте, чтобы зря не злить поисковых роботов.

Очень медленная скорость загрузки сайта

Поэтому скорость загрузки сайта прямо влияет на конверсию, снижает количество отказов, увеличивает глубину просмотра страниц, поэтому косвенно дает рост среднего чека и выручки. В общем, если сайт грузится долго, а страницы открываются удручающе медленно, то и индексироваться поисковиками он нормально тоже не будет.

Чтобы уменьшить размер страниц на сайте, нужно сократить объем графики, убрать лишние изображения, сократить объем загружаемых страницы путем сжатия gzip, кэшировать данные, сократить размер кода CSS и JavaScript.

Одновременно с этим можно озаботиться тем, как увеличить скорость загрузки сайта. Для этого проводятся исследования скорости загрузки страниц. Потом находятся слабые места и устраняются поштучно. Считается, что ускорение загрузки страниц сайта даже на 0,5 секунд дает отличные результаты в 80% случаев.

На всякий случай ловите 8 основных способов, как ускорить загрузку сайта, с примерами и картинками. А также абсолютно уникальный мануал про то, как ускорить загрузку верхней части страницы сайта – header.

Ваш домен ранее был забанен

Чтобы решить эту задачу нужно:

- Продолжать развивать проект.

- Написать в Google, на форум, чтобы выяснить причину блокировки, а потом ее устранять.

- Развивать проект на другом домене, чтобы сэкономить время и деньги.

У вас нет sitemap на сайте

Полезно! Если хотите, то ту же инструкцию, как создать XML карту сайта, можно посмотреть для видео.

Это отдельный, масштабный, как пирамида Хеопса и Великая Китайская стена взятые вместе, кусок работы по созданию карты сайта для новостей или другого динамического информационного контента. Для блока новостей делают собственную XML карту сайта, потом отправляют запрос в Новости Google и добавляют ее в news.google.com, чтобы поисковые роботы находили и индексировали такой контент еще быстрее.

Кроме того, собственная карта сайта – Image sitemap XML создается для изображений. Она нужна, чтобы обеспечить быстрое, правильное, естественное индексирование картинок. Ловите детальный мануал, как создать XML карту сайта для изображений.

FAQ

Почему сайт не индексируется в Гугле?

Первейшая причина – поисковая система Гугл просто «не видит» ваш сайт. Ей нужно помочь – вручную проиндексировать сайт. Кроме того, возможны ошибки сканирования поисковыми роботами, неприятие Гуглом языков AJAX/JavaScript, наличие на сайте дублированного контента или забаненный ранее домен.

Почему не индексируются страницы сайта?

Одна из самых распространенных причин — страницы сайта закрыты в robots.txt.

Как часто Гугл индексирует сайт?

Google проводит индексацию постоянно – поисковые роботы загружают страницы сайта, а потом выкладывают их в обновленный индекс.

Выводы

Финальный чек-лист, почему сайт не индексируется в Гугле?

- Google пока не нашел ваш сайт. Ждем, пока увидят, или вручную ускоряем процесс индексации.

- Сайт или страницы закрыты в robots.txt. Открываем.

- Включены приватные настройки в CMS. Открываем.

- Сайт закрыт от индексации в noindex в метатегах. Убираем noindex из метатегов.

- Ошибки сканирования. Ищем одну из трех известных ошибок сканирования: ошибки в настройках сервера, сбои CMS, изменение структуры URL. Устраняем.

- Сайт заблокирован в .htaccess — проверяем файл .htaccess., удаляем из него страницы и папки, которые нуждаются в индексации.

- Хостинг или сервер работает нестабильно — отслеживаем проблему, меняем хостинг.

- Проблемы с AJAX/JavaScript – вручную настраиваем все для поиска AJAX и JavaScript и уговариваем Гугл проиндексировать сайт (страницы).

- У вас на сайте много дублированного контента, находим и удаляем дубли.

- Очень медленная скорость загрузки сайта, облегчаем (сжимаем) контент.

- Ваш домен ранее был забанен – пишем запрос на апелляцию или развиваем ресурс на другом, чистом, домене.

- Сайт лишен sitemap – нужно сделать и добавить сайтмап в Search Console.

Используйте лучшие SEO инструменты

Проверка обратных ссылок

Быстрая проверка обратных ссылок вашего сайта и конкурентов

API для SEO

Получите быстро большие объемы данных используя SЕО API

Анализ конкурентов

Сделайте полный анализ сайтов конкурентов для SEO и PPC

Мониторинг позиций

Отслеживайте изменение ранжирования запросов используя мониторинг позиций ключей

Рекомендуемые статьи

Кейсы, лайфхаки, исследования и полезные статьи

Не успеваешь следить за новостями? Не беда! Наш любимый редактор подберет материалы, которые точно помогут в работе. Только полезные статьи, реальные кейсы и новости Serpstat раз в неделю. Присоединяйся к уютному комьюнити :)

Нажимая кнопку, ты соглашаешься с нашей политикой конфиденциальности.