Начните искать ключевые слова

Используйте Serpstat, чтобы находить лучшие ключи

Какие страницы нужно закрыть от индексации

Tech Head of SEO в TRINET.Group

Причины запретить индексацию страниц

Рассмотрим причины, по которым следует запретить индексацию сайта или отдельных страниц:

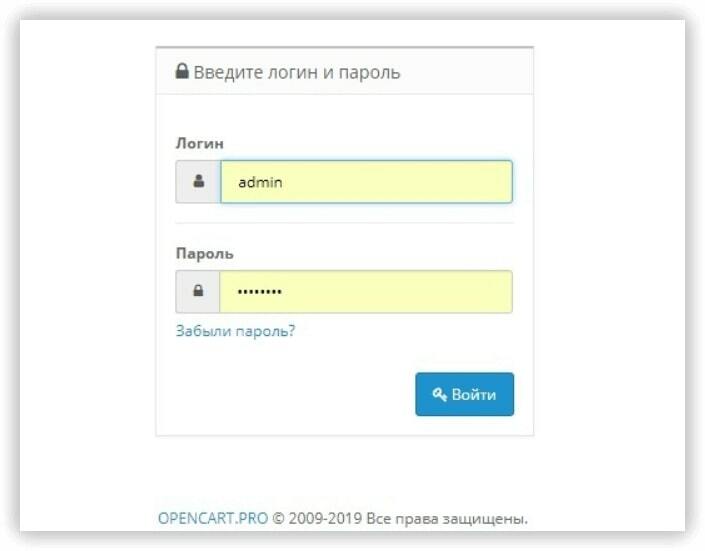

К такому контенту можно отнести технические и административные страницы сайта (корзина, страница оплаты, результатов поиска, авторизация и т.д.), данные с персональной информацией, наборы фильтров каталога товара в электронной коммерции (множественный выбор фильтров по цене, цвету, фактуре и другое).

Краулинговый бюджет — это определенное количество страниц сайта, которое периодически сканирует поисковая система. Для всех сайтов это значение количества страниц разное и не постоянное и в том числе зависит от типа сайта и частоты его обновления. В наших интересах тратить ресурсы краулеров на те страницы, которые представляют ценность и пользу как для клиента так и для нас (бизнеса). Чтобы краулер чаще посещал и обновлял контент в индексе нужных нам страниц, необходимо закрыть от сканирования те, которые вытягивают краулинговый бюджет и не приносят собственно пользы.

Какие закрыть страницы от индексации

Закрыть сайт от индексации в robots.txt можно следующим содержимым (первая директива - означает обращение ко всем краулерам, вторая директива - запрещает сканировать все URL сайта):

User-agent: *

Disallow: /

Эти две строчки запретят доступ к сайту всем роботам поисковых систем.

Если нужно при этом разрешить сканировать конкретные URL, нужно добавить директиву Allow: /namepage$ где /namepage URL страницы разрешенной к сканированию. Директива разрешения сканирования доминирует над запретом (для конкретного URL), а значек $ отменяет применение по умолчанию не выводимывого символа "*". То есть если не поставить $ - мы разрешим сканировать вложенные URL относительно родителя, такие как /namepage/indexpage.html и т.д.

Запрет индексации для сайта на сервере NGINX осуществляется с помощью добавления кода add_header X-Robots-Tag "noindex, nofollow"; в файл .conf.

По сути страница печати является копией её основной версии. Если эта страница открыта для индексации, поисковый робот может выбрать ее приоритетной и более релевантной. Для правильной оптимизации сайта с большим числом страниц следует установить запрет индексации страниц для печати.

Чтобы закрыть ссылку на документ, можно использовать вывод контента с помощью AJAX, закрыть страницы с помощью метатега <meta name="robots" content="noindex, follow"/>, либо в роботс закрыть от индексации все страницы печати.

Возможно, содержимое этих файлов не отвечает запросам целевой аудитории сайта. Или же документы появляются в поиске выше html-страниц сайта. В этом случае индексация документов нежелательна, и их лучше закрыть от сканирования в файле robots.txt.

Как закрыть страницы от индексации

Это позволяет полностью закрыть страницу, оставив роботам возможность переходить по размещенным на странице ссылкам. Если это не нужно, замените follow на nofollow:

<meta name="robots" content="noindex, nofollow"/>

При использовании данных методов страница будет закрыта для сканирования даже при наличии внешних ссылок на нее.

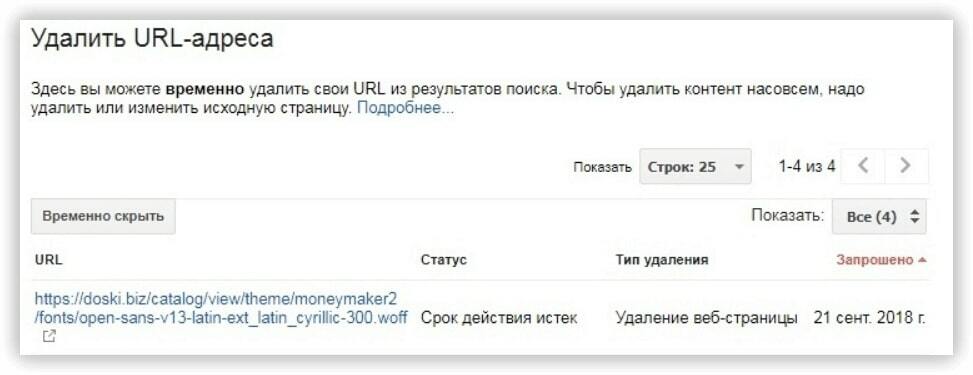

Как закрыть сайт от индексации Google

<meta name="googlebot" content="noindex, nofollow"/>

Через robots доступ к сайту ботам Google закрывается так:

User-agent: googlebot

Disallow: /

Еще можно запретить доступ к каким-либо статьям сайта роботам Google Новостей, тогда они не появятся в Google News:

<meta name="Googlebot-News" content="noindex, nofollow">.

Ограничить индексацию страниц через файл robots.txt можно так:

User-agent: * #название поисковой системы

Disallow: /catalog/ #частичный или полный URL закрываемой страницыAuthType Basic

AuthName "Password Protected Area"

AuthUserFile путь к файлу с паролем

Require valid-user

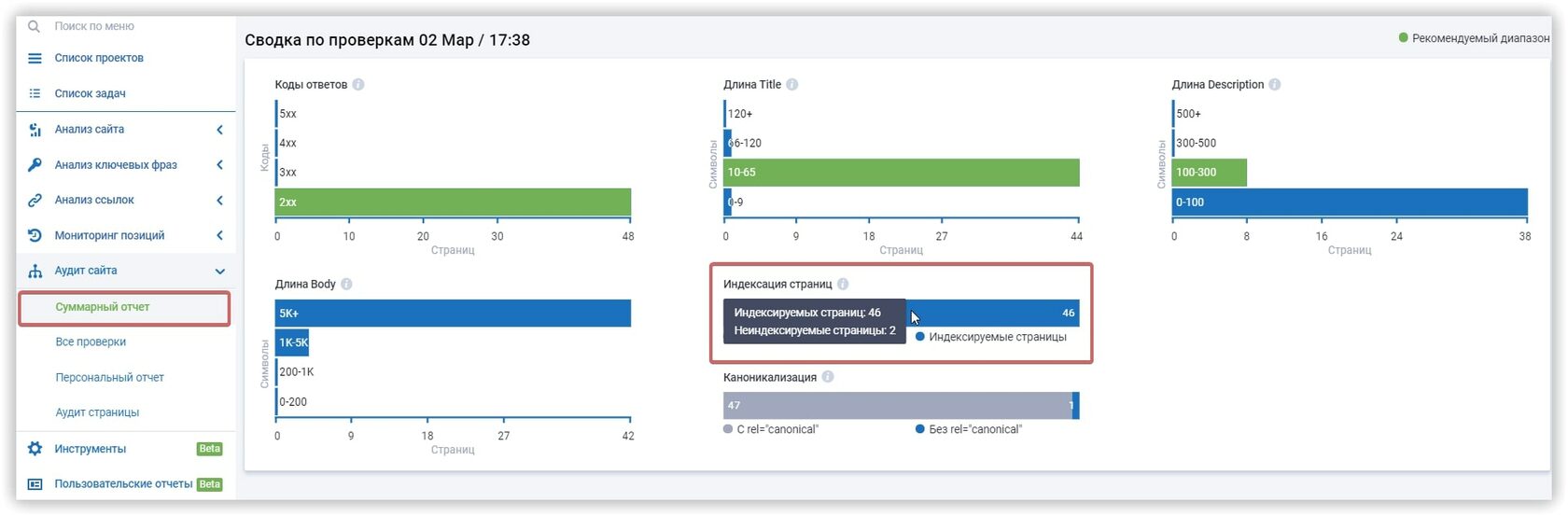

Как проверить, сколько страниц закрыто от индексации

Для того, чтобы это сделать нужно всего лишь нажать на кнопку ниже, и у вас будет возможность создать проект для сайта ↓

Заключение

Ограничение доступа к ряду страниц и документов сэкономит ресурсы поисковой системы и ускорит индексацию сайта в целом.

FAQ

Как запретить индексацию сайта?

Запретить доступ ботов поисковых систем к сайту можно с помощью нескольких способов: добавления метатега robots со значением noindex в html-код; указания директивы Disallow в файле robots.txt; установки пароля для доступа к сайту в конфигурационном файле .htaccess. Также можно блокировать доступ к отдельным каталогам и документам.

Как временно закрыть сайт от индексации

Чтобы закрыть сайт от индексации, добавьте метатег name="robots" content="noindex, nofollow" в раздел всех веб-страниц или добавьте директиву User-agent: * Disallow: / в файл robots.txt.

Как закрыть сайт от индексации WordPress

Чтобы закрыть сайт WordPress от индексации, зайдите в админку CMS, выберите раздел «Настройки» → «Чтение». Найдите подраздел «Видимость для поисковых систем» и отметьте галочкой «Попросить поисковые системы не индексировать сайт». После этого WordPress автоматически внесет коррективы в файл robots.txt для запрета индексации.

Serpstat — набор инструментов для поискового маркетинга!

Находите ключевые фразы и площадки для обратных ссылок, анализируйте SEO-стратегии конкурентов, ежедневно отслеживайте позиции в выдаче, исправляйте SEO-ошибки и управляйте SEO-командами.

Набор инструментов для экономии времени на выполнение SEO-задач.

Используйте лучшие SEO инструменты

Подбор ключевых слов

Поиск ключевых слов – раскройте неиспользованный потенциал вашего сайта

Возможности Serpstat

Возможности Serpstat – комплексное решение для эффективного продвижения вебсайтов

Кластеризация ключевых слов

Кластеризация ключевых слов автоматически обработает до 50 000 запросов в несколько кликов

SEO аудит страницы

Проанализируйте уровень оптимизации документа используя SЕО аудит страницы

Рекомендуемые статьи

Кейсы, лайфхаки, исследования и полезные статьи

Не успеваешь следить за новостями? Не беда! Наш любимый редактор подберет материалы, которые точно помогут в работе. Только полезные статьи, реальные кейсы и новости Serpstat раз в неделю. Присоединяйся к уютному комьюнити :)

Нажимая кнопку, ты соглашаешься с нашей политикой конфиденциальности.