Как задать в robots.txt директивы для роботов Google

2. Где можно найти файл robots.txt и как его создать или редактировать

3. Как создать и редактировать robots.txt

4. Инструкция по работе с robots.txt

5. Синтаксис в robots.txt

6. Директивы в Robots.txt

- Disallow

- Allow

- Sitemap

- Crawl-delay

7. Как проверить работу файла robots.txt

- В Google Search Console

Заключение

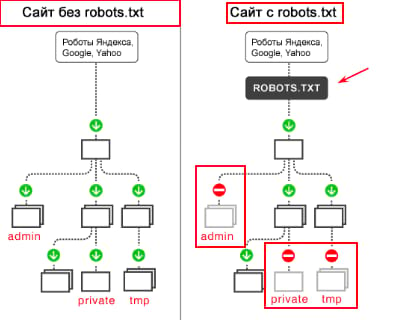

Зачем robots.txt нужен на сайте

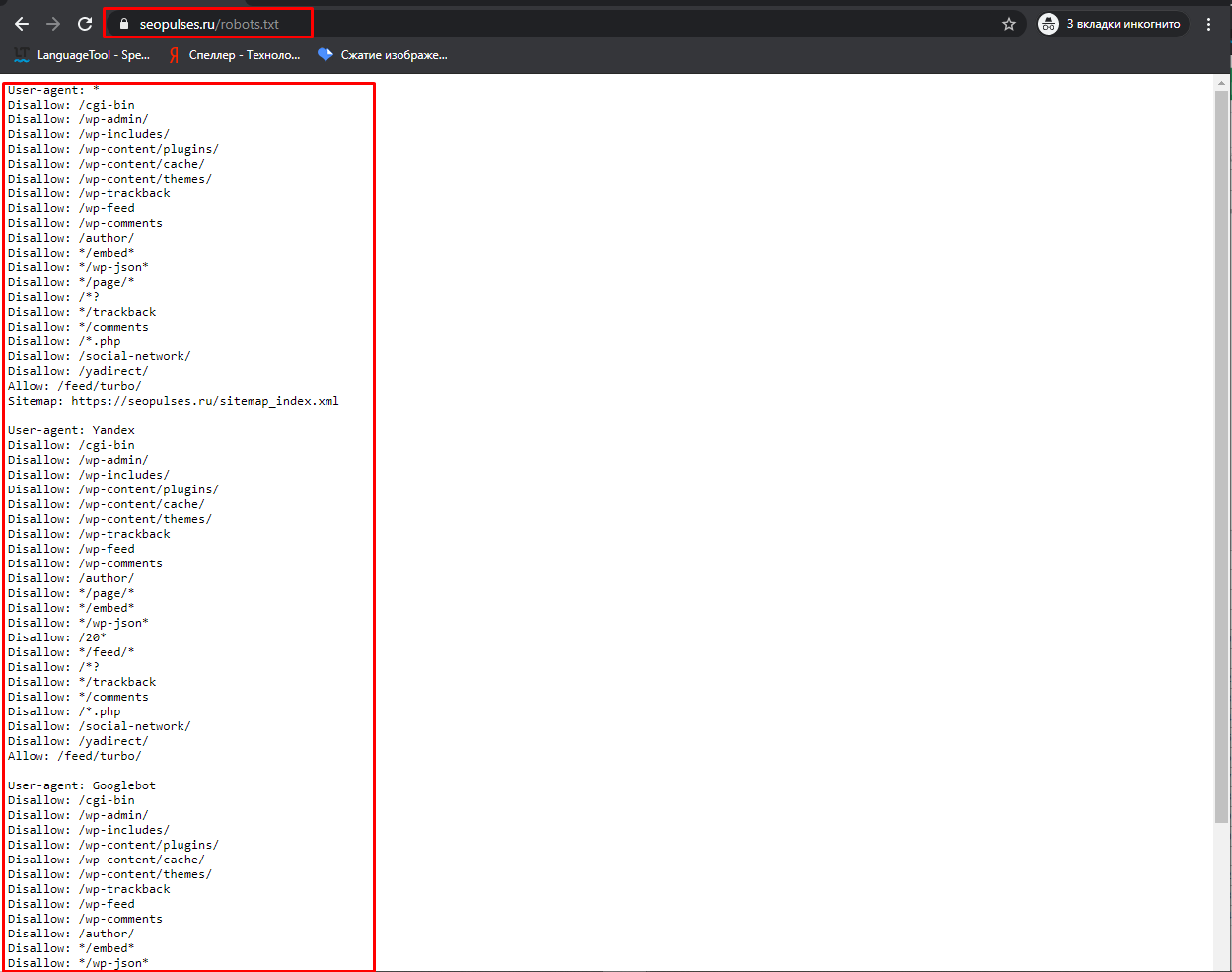

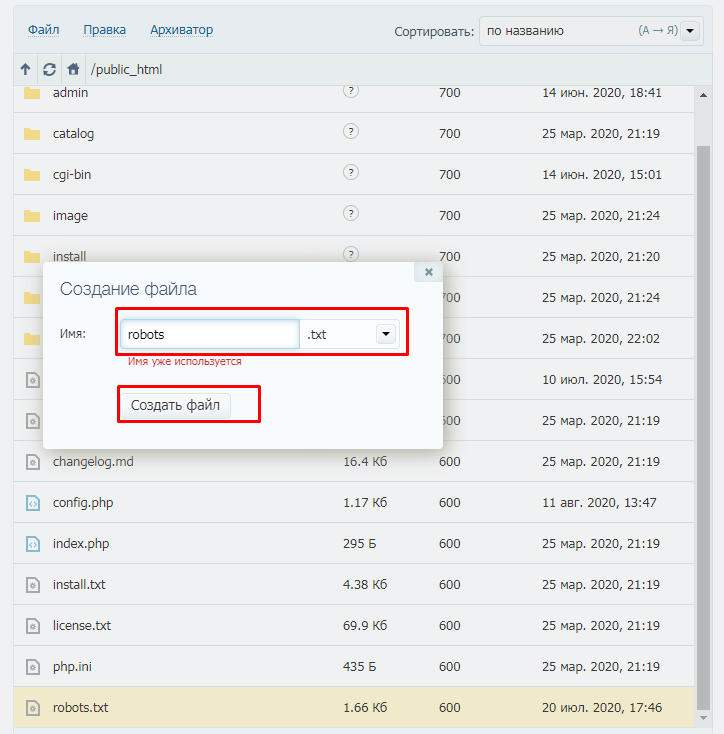

Где можно найти файл robots.txt и как его создать или редактировать

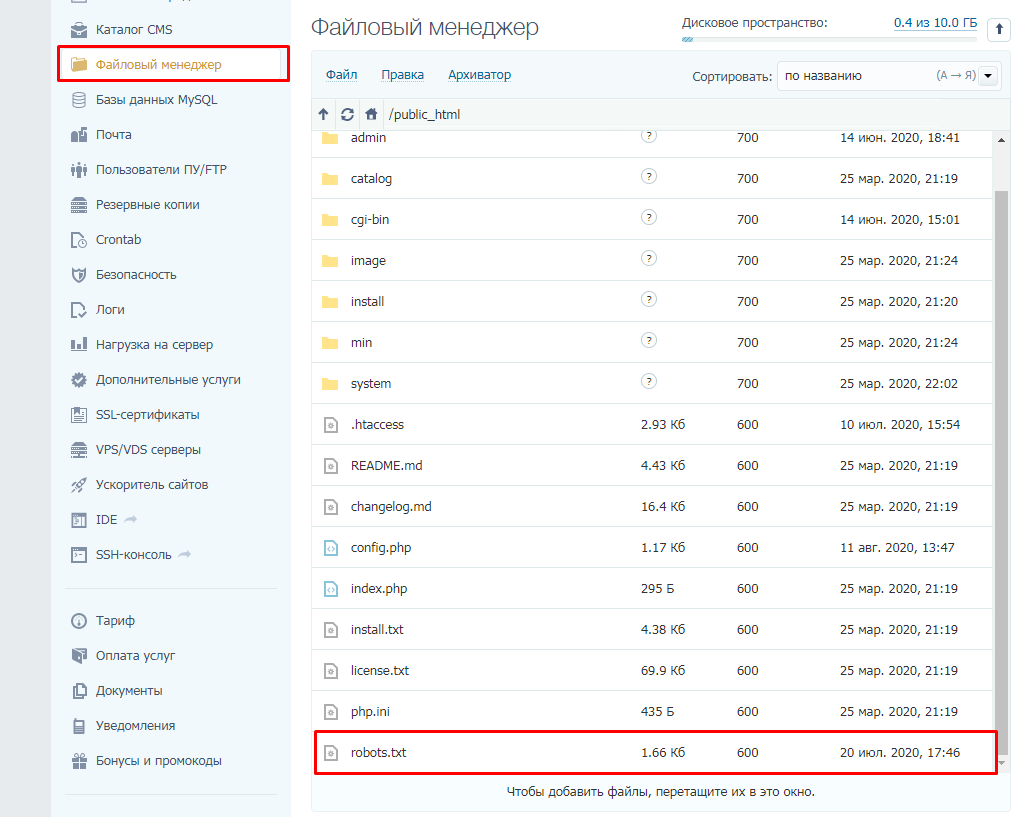

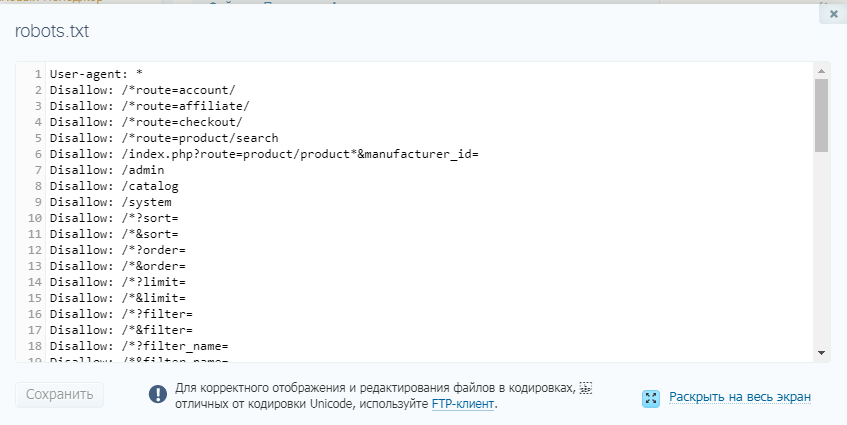

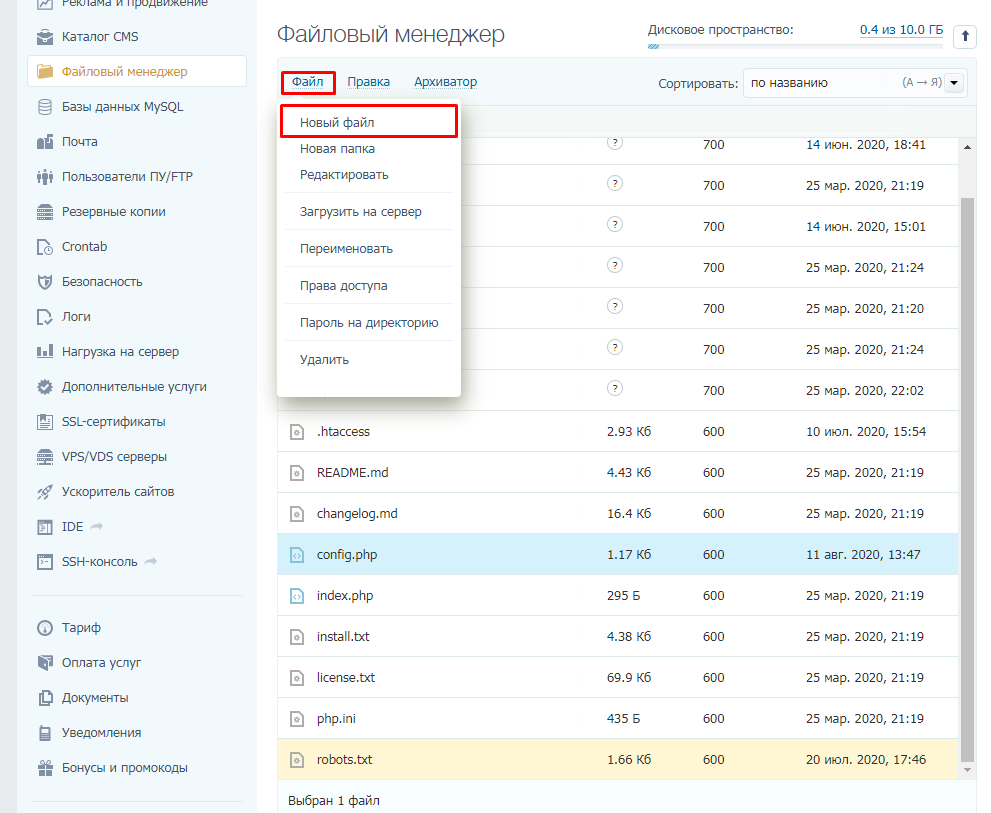

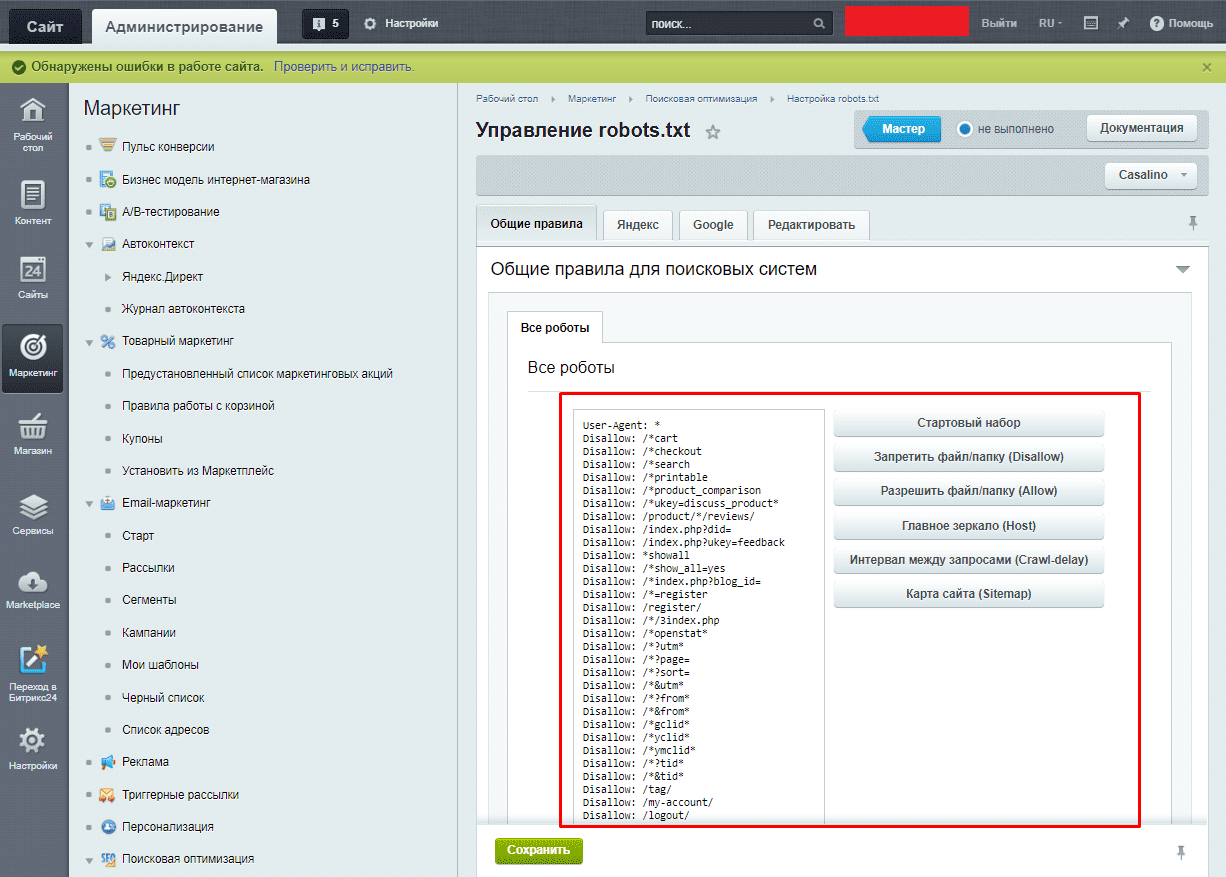

Как создать и редактировать robots.txt

Вручную

Через модули/дополнения/плагины

Инструкция по работе с robots.txt

- User-agent: Googlebot — в случае с краулером Google;

- Googlebot — краулер, индексирующий страницы веб-сайта;

- Googlebot Image — сканирует изображения и картинки;

- Googlebot Video — сканирует всю видео информацию;

- AdsBot Google — анализирует качество размещенной рекламы на страницах для компьютеров;

- AdsBot Google Mobile — анализирует качество рекламы мобильных версий сайта;

- Googlebot News — оценивает страницы для использования в Google Новости;

- AdsBot Google Mobile Apps — расценивает качество рекламы для приложений на андроиде, аналогично AdsBot.

Синтаксис в robots.txt

- # — отвечает за комментирование;

- * — указывает на любую последовательность символов после этого знака. По умолчанию указывается при любого правила в файле;

- $ — отменяет действие *, указывая на то что на этом элементе необходимо остановиться.

Директивы в Robots.txt

Disallow

User-agent: *

Disallow: /

Disallow: /category1/

User-agent: *

Disallow: /category2/$

User-agent: *

Disallow:

Allow

Disallow: */feed/*

Allow: /feed/turbo/

Allow: /doc.xml

Sitemap

Важно понимать, что в отличие от стандартных директив у нее есть особенности в записи:

- Следует указывать полный URL, когда относительный адрес использовать запрещено;

- На нее не распространяются остальные правила в файле robots.txt;

- XML-карта сайта должна иметь в URL-адресе домен сайта.

Crawl-delay

Crawl-delay: 3

Заказывайте бесплатную персональную демонстрацию сервиса, и наши специалисты вам все расскажут! ;)

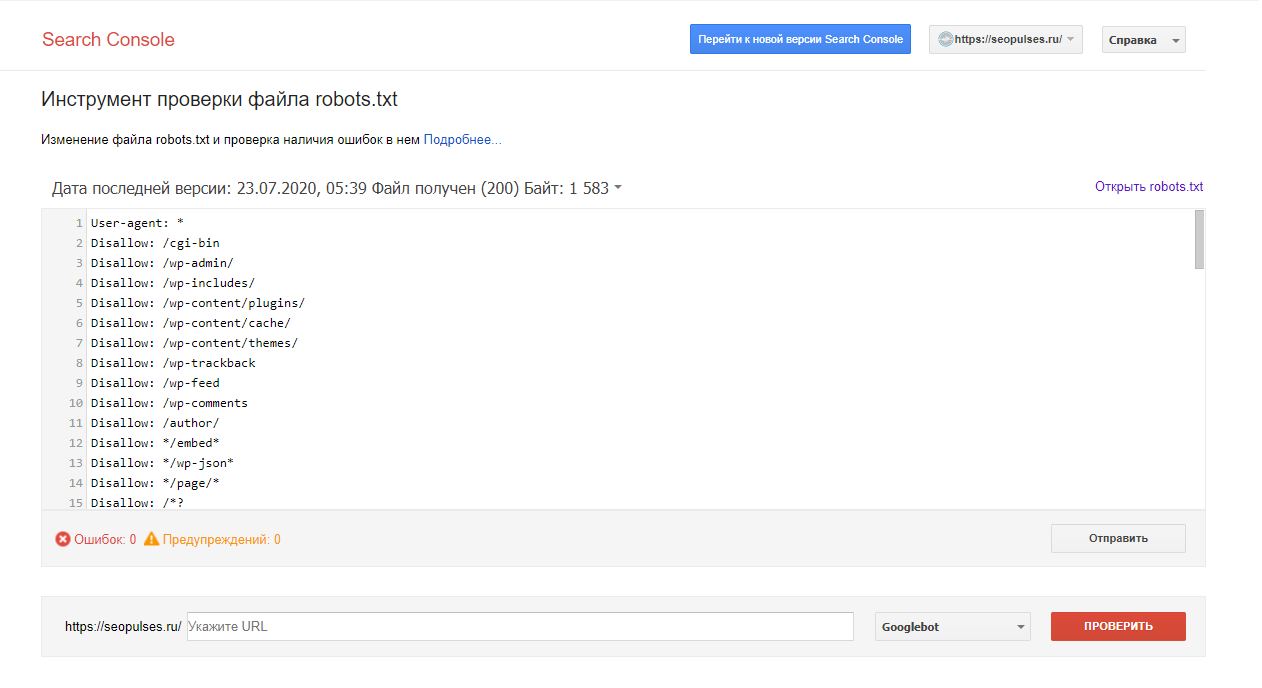

Как проверить работу файла robots.txt

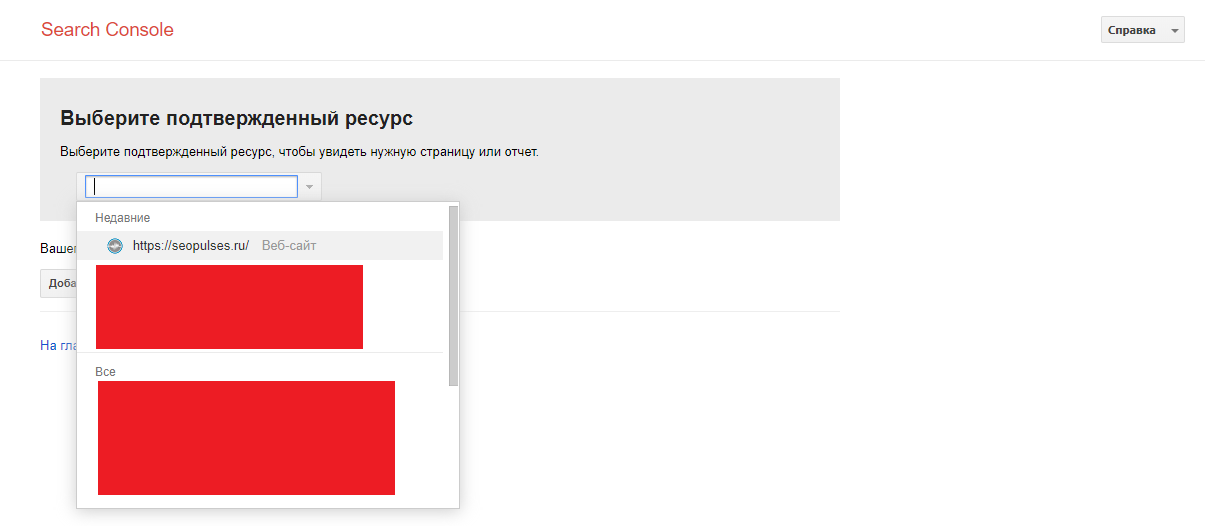

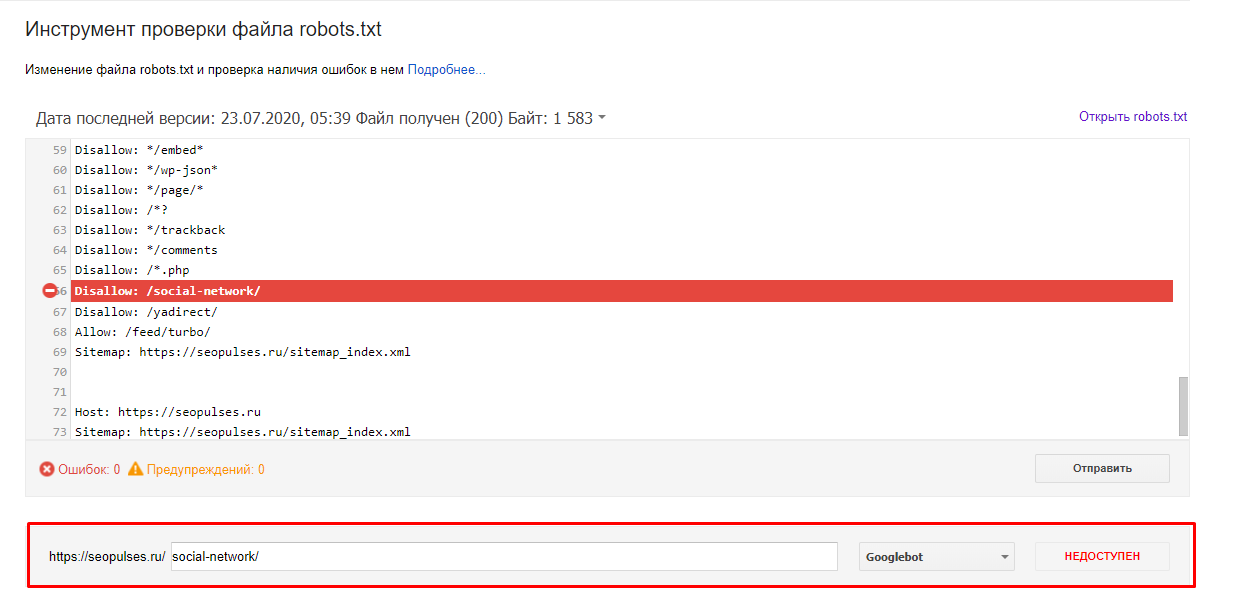

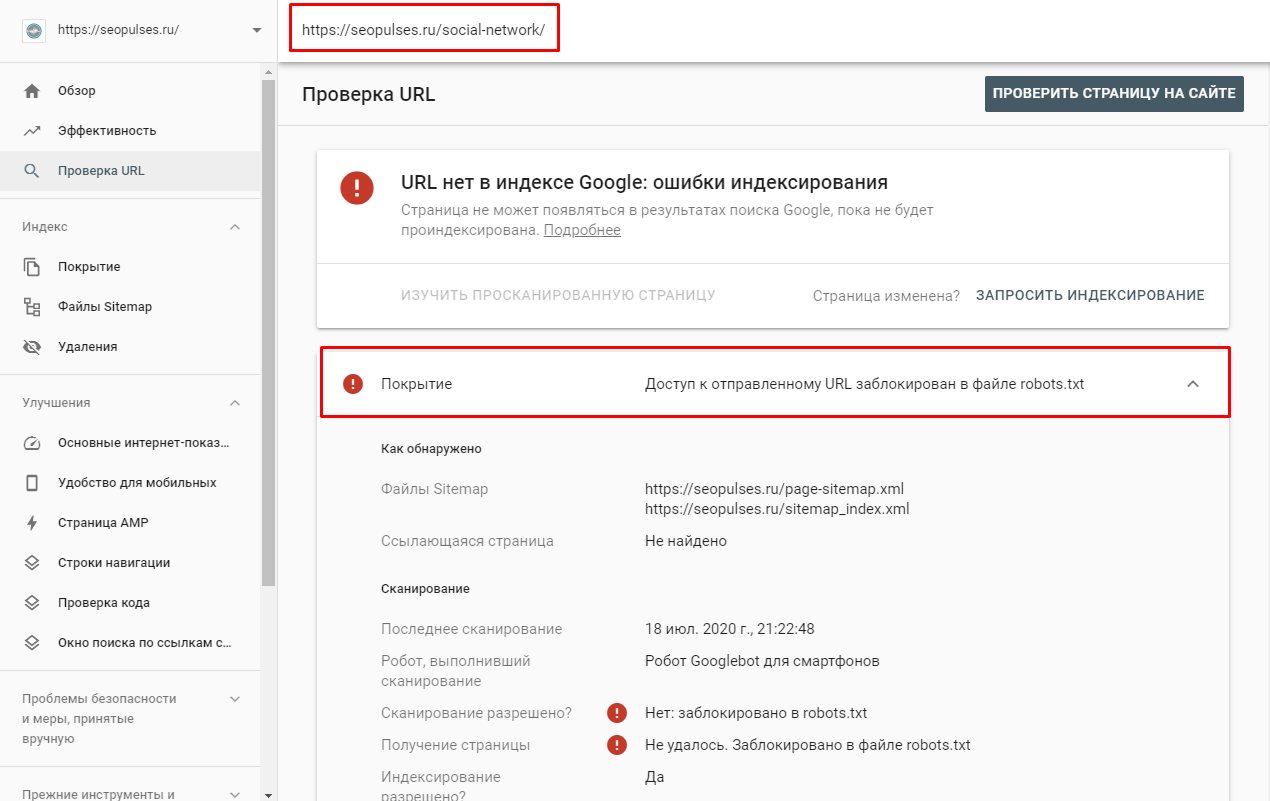

В Google Search Console

- Сам файл;

- Кнопку, открывающую его;

- Симулятор для проверки сканирования.

Заключение

Пропишите к каким поисковым роботам вы обращаетесь и дайте им команду, как описано выше.

Далее, проверьте его правильность через встроенные инструменты Google. Если не возникает ошибок, сохраните файл в корневую папку и еще раз проверьте его доступность, перейдя по ссылке http://yoursiteadress.com/robots.txt. Активная ссылка говорит о том, что все сделано правильно.

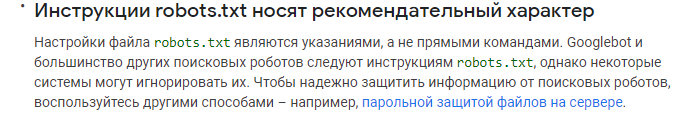

Помните, что директивы носят рекомендательный характер, а для того чтобы полностью запретить индексирование страницы нужно воспользоваться другими методами.

о выполнении работ по конкретному проекту. Инструмент содержит готовые шаблоны с обширным списком параметров по развитию проекта, к которым также можно добавлять собственные пункты.

| Начать работу со «Списком задач» |

Используйте лучшие SEO инструменты

Проверка обратных ссылок

Быстрая проверка обратных ссылок вашего сайта и конкурентов

API для SEO

Получите быстро большие объемы данных используя SЕО API

Анализ конкурентов

Сделайте полный анализ сайтов конкурентов для SEO и PPC

Мониторинг позиций

Отслеживайте изменение ранжирования запросов используя мониторинг позиций ключей

Рекомендуемые статьи

Кейсы, лайфхаки, исследования и полезные статьи

Не успеваешь следить за новостями? Не беда! Наш любимый редактор подберет материалы, которые точно помогут в работе. Только полезные статьи, реальные кейсы и новости Serpstat раз в неделю. Присоединяйся к уютному комьюнити :)

Нажимая кнопку, ты соглашаешься с нашей политикой конфиденциальности.