Начните искать ключевые слова

Используйте Serpstat, чтобы находить лучшие ключи

Как массово находить дропнутые домены. Находим освобождённые домены которые ранжируются выше в выдачи

Отличие методов GET от POST лежит в способе передачи данных. Запрос GET передает данные в URL, а запрос POST – в теле запроса.

Это различие описывает характеристики способов и особенности запросов для использования того либо другого способа.

Пример из кейса можно рассматривать как демонстрацию возможностей для написания собственных скриптов или использования существующих и получения данных в соответствии с вашими задачами.

Ознакомиться с актуальными APi-методами и синтаксисом можно здесь. serpstat.com/ru/api/

Пример запроса с POST-методом:

{

"id": "1",

"method": "SerpstatDomainProcedure.getDomainsInfo",

"params": {

"domains": ["nike.com", "adidas.com"],

"se": "g_us"

}

}

Данная статья построена на основе доклада Дмитрия Мазуряна — Senior SEO at Tonti Laguna&Netpeak Group. Вы узнаете, что такое анализ топов, как и зачем находить дроп-домены, определять узкие ниши и как автоматизировать все эти процессы. Поехали!

- Зачем нужно анализировать топы?

- Как найти дропы, которые ранжировались в вашей выдаче?

- Как найти сайты, которые добиваются успеха в нише?

- Как определить узкие ниши по конкретным сайтам?

- Как разбить семантику на группы и получить рекомендации по оптимизации текста автоматически?

Подытожим

Зачем нужно анализировать топы?

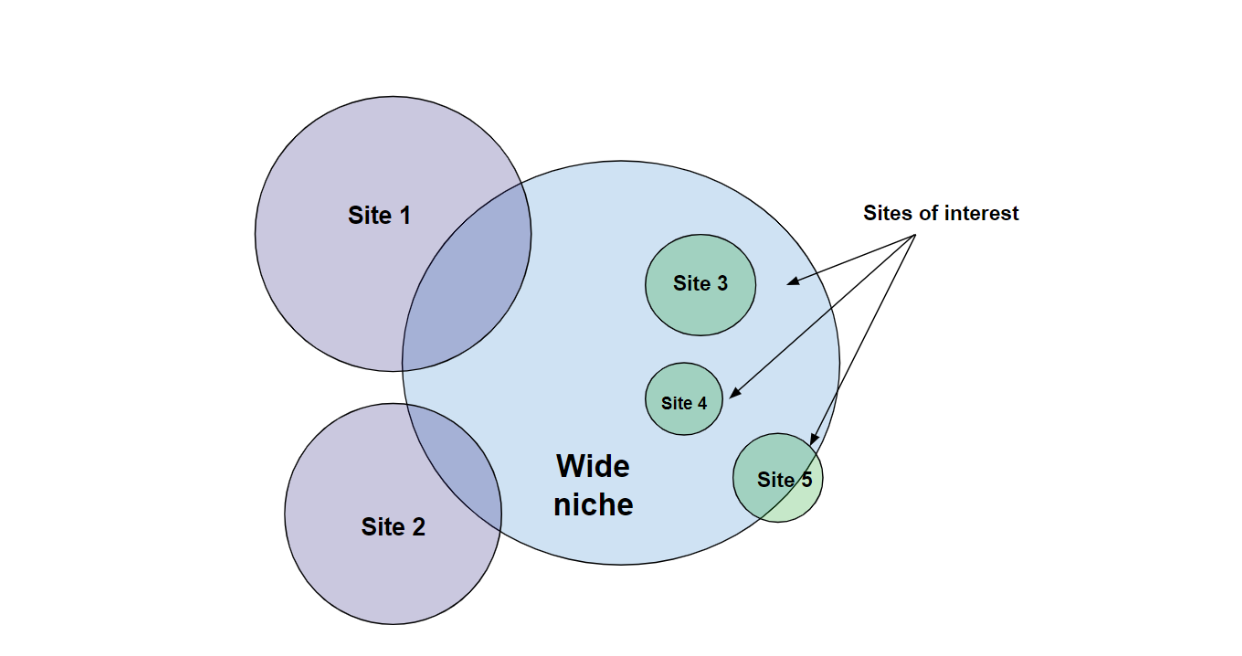

Результаты очень разнообразны: это происходит потому, что ниша разделена на субниши, поэтому невозможно увидеть все это разнообразие доменов, если посмотреть только на топ-10 или топ-100. Необходимо прибегать к анализу топов и рассматривать сотни и тысячи доменов.

Благодаря этому анализу можно узнать больше о конкурентах и выявить закономерности распределения доменов в выдаче. Также можно получить информацию о разнице между результатами поиска разных ключевых слов в вашей нише.

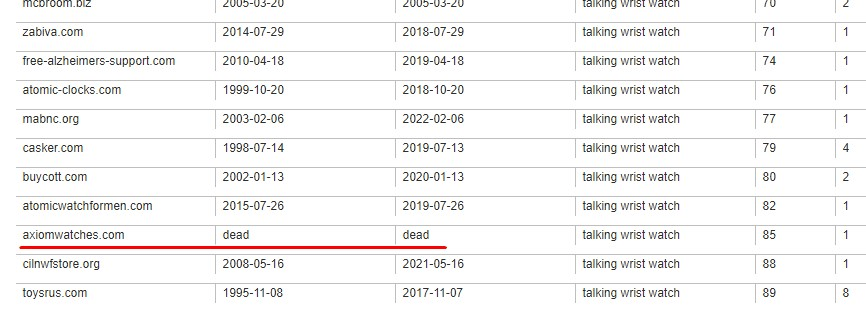

Как найти дропы, которые ранжировались в вашей выдаче?

Чем хороши такие домены?

Как найти дропы?

Скачать скрипт можно по ссылке: http://mz.kiev.ua/tools/serpstat-api-funcs.rar (скопируйте ссылку и вставьте в строку поиска, файл со скриптом скачается к вам на компьютер).

Как это работает?

Мы вводим ключ, и скрипт собирает все запросы, которые находятся в базе данных Serpstat для этого ключа через API. Сервис анализирует топы, собирает домены и уже автоматически проверяет whois для этих доменов и формирует таблицу, которая включает:

Но не все, найденные таким образом, домены одинаково полезны.

Исключения:

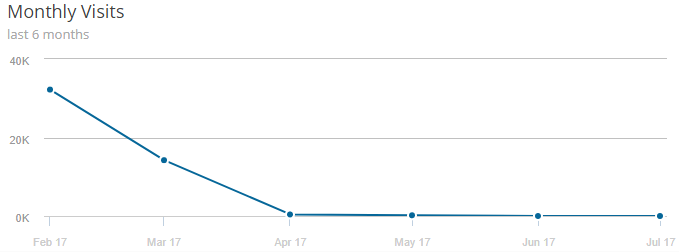

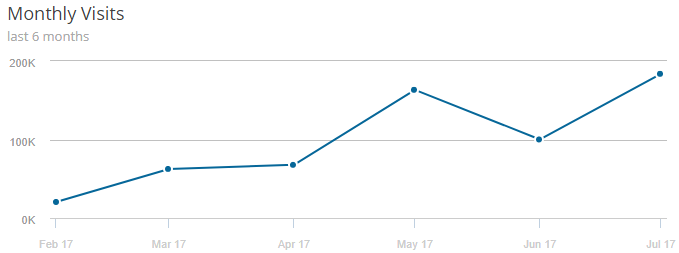

Трафик и видимость начали падать еще до истечения срока годности.

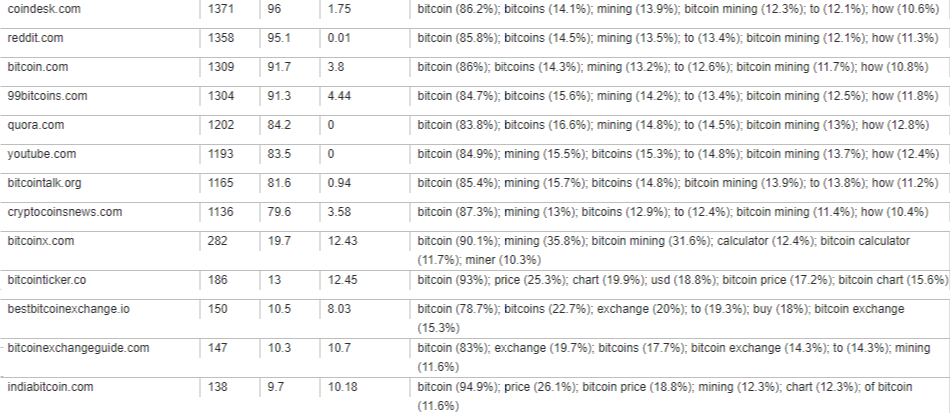

Как найти сайты, которые добиваются успеха в нише?

Зачем нам нужна эта информация?

Как найти такие сайты?

Что мы проверяем после получения списка

таких сайтов?

таких сайтов?

Как определить узкие ниши по конкретным сайтам?

В чем польза такого метода?

Как это работает?

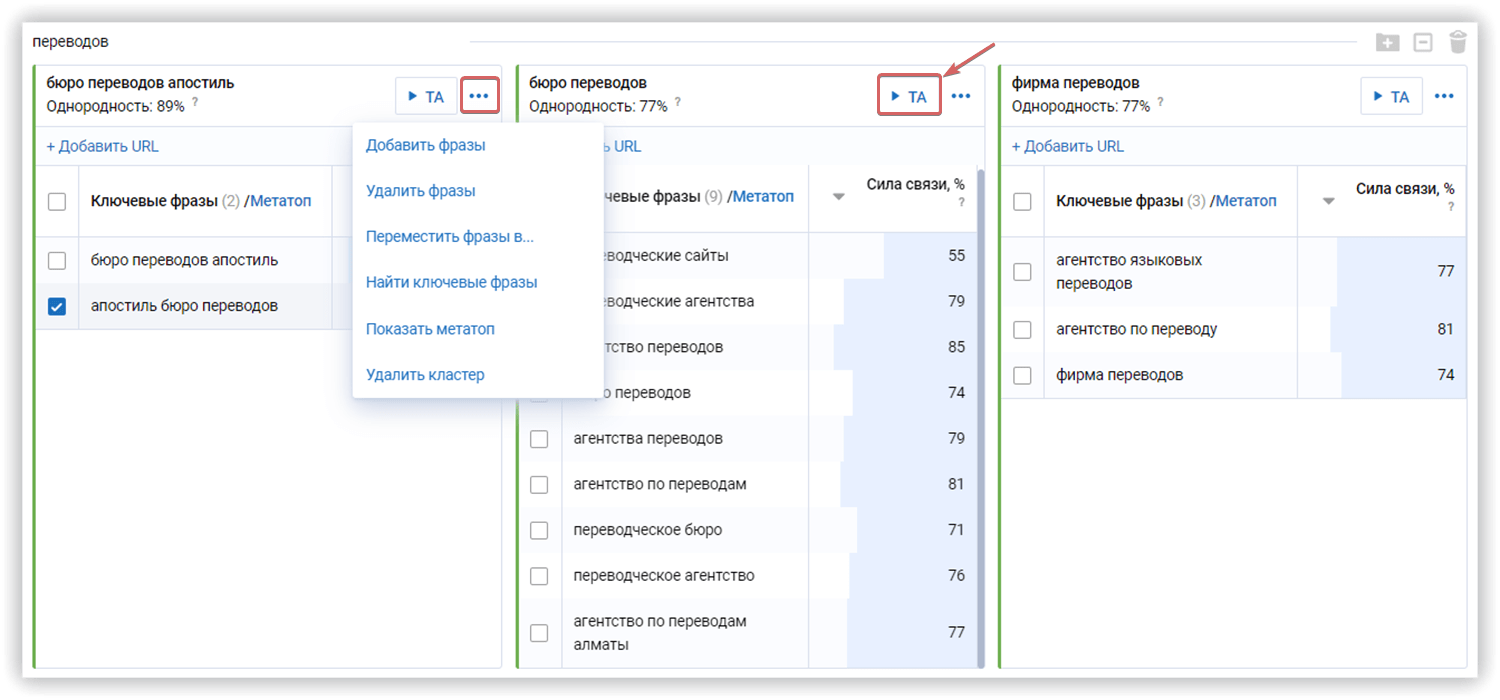

Как разбить семантику на группы и получить рекомендации по оптимизации текста автоматически?

Вы получаете:

Как работает текстовая аналитика?

Бонусный метод для тех, кто дочитал до конца :D

Способ #1

Делаем разбор важности слов в нише. По API выгружается несколько тысяч фраз и разбираются на слова. В итоге по каждому слову получаем две метрики: количество фраз со словом и суммарная частотность фраз со словом.

Здесь скрипта нет. Все это можно сделать через Google Sheets.

Заготовок описания тоже нет. Просто берем выгрузку ключей по фразе. Например 40к ключей. Ключи делим на слова. Например ключ «убойная водка» — это два слова «убойная» и «водка».

С помощью базовых возможностей Google Sheets можно получить список таких слов, и для каждого посчитать количество попаданий в выгруженные 40к ключей и суммарную частотность в них. Так можно выделить основные слова, которые встречаются с главным словом, например, «водка».

Это отличный способ, который помогает при быстром и ленивом разборе темы ;)

Массовые проверки количества фраз у страниц, количествава фраз в топ-10 у доменов, количества фраз с фильтром у доменов/страниц и тд. В общем, все массовое чего нет в интерфейсе или чекере. По сути это массовый анализ, который есть в интерфейсе для обработки доменов, но отсутствует для отдельных страниц

Подытожим

Serpstat — набор инструментов для поискового маркетинга!

Находите ключевые фразы и площадки для обратных ссылок, анализируйте SEO-стратегии конкурентов, ежедневно отслеживайте позиции в выдаче, исправляйте SEO-ошибки и управляйте SEO-командами.

Набор инструментов для экономии времени на выполнение SEO-задач.

Используйте лучшие SEO инструменты

Проверка обратных ссылок

Быстрая проверка обратных ссылок вашего сайта и конкурентов

API для SEO

Получите быстро большие объемы данных используя SЕО API

Анализ конкурентов

Сделайте полный анализ сайтов конкурентов для SEO и PPC

Мониторинг позиций

Отслеживайте изменение ранжирования запросов используя мониторинг позиций ключей

Рекомендуемые статьи

Кейсы, лайфхаки, исследования и полезные статьи

Не успеваешь следить за новостями? Не беда! Наш любимый редактор подберет материалы, которые точно помогут в работе. Только полезные статьи, реальные кейсы и новости Serpstat раз в неделю. Присоединяйся к уютному комьюнити :)

Нажимая кнопку, ты соглашаешься с нашей политикой конфиденциальности.