Начните искать ключевые слова

Используйте Serpstat, чтобы находить лучшие ключи

Как не расходовать зря краулинговый бюджет

Что такое краулинговый бюджет и как его определить?

Краулинговый спрос — это определенное количество URL, которые Google намеревается просканировать на веб-ресурсе.

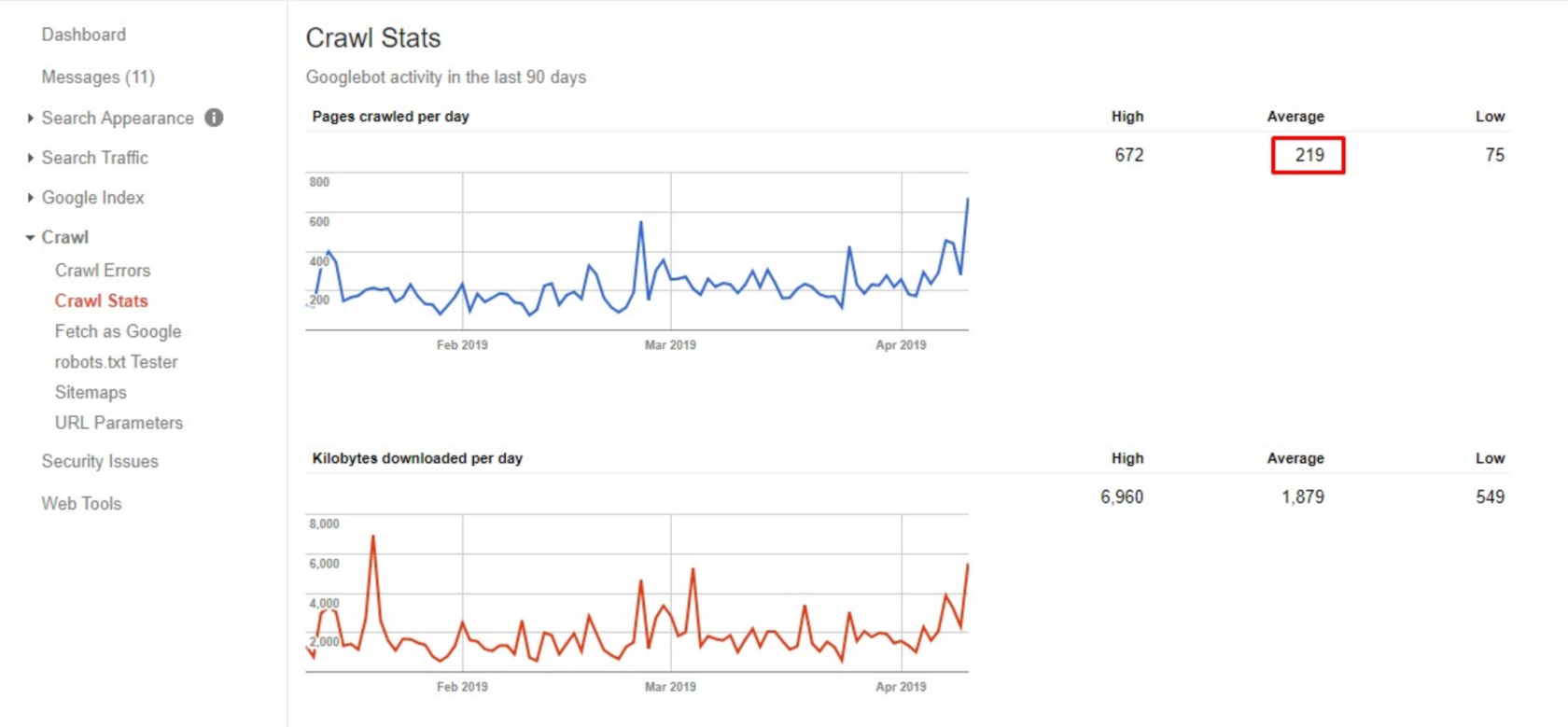

Краулинговый бюджет — это лимит страниц сайта, которые поисковый паук сможет обойти за какую-то единицу времени. Иногда робот просто не способен обойти все страницы за один раз, поэтому нужно принимать меры для оптимизации этого показателя.

Как использовать на практике эти данные?

Важно, чтобы в индекс попали все приоритетные посадочные страницы. В противном случае вы будете терять целевых посетителей из органики, которые могли бы стать вашими клиентами.

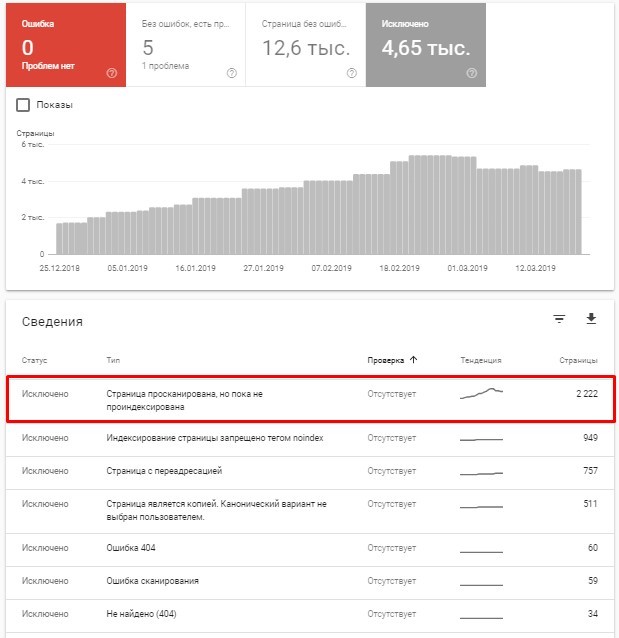

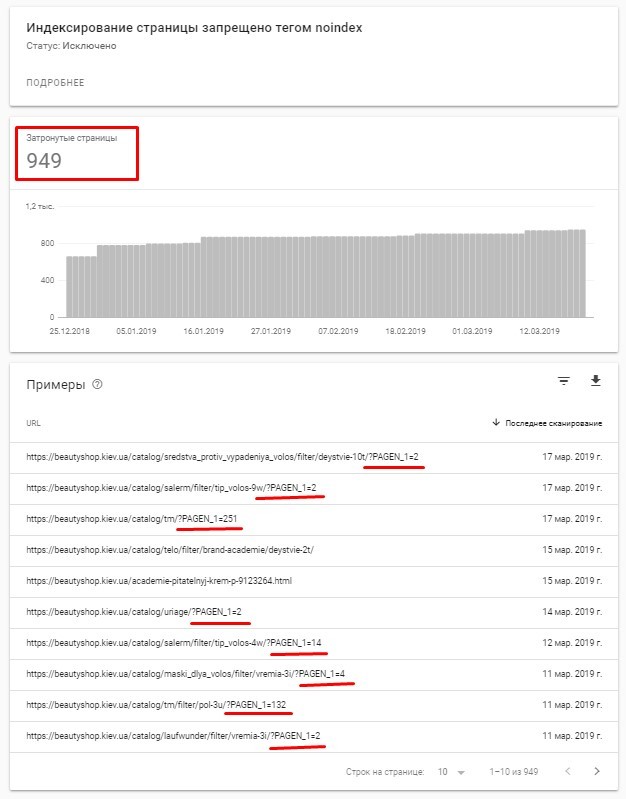

- индексация мусорных страниц;

- расходование краулингового бюджета на неприоритетные и неэффективные страницы.

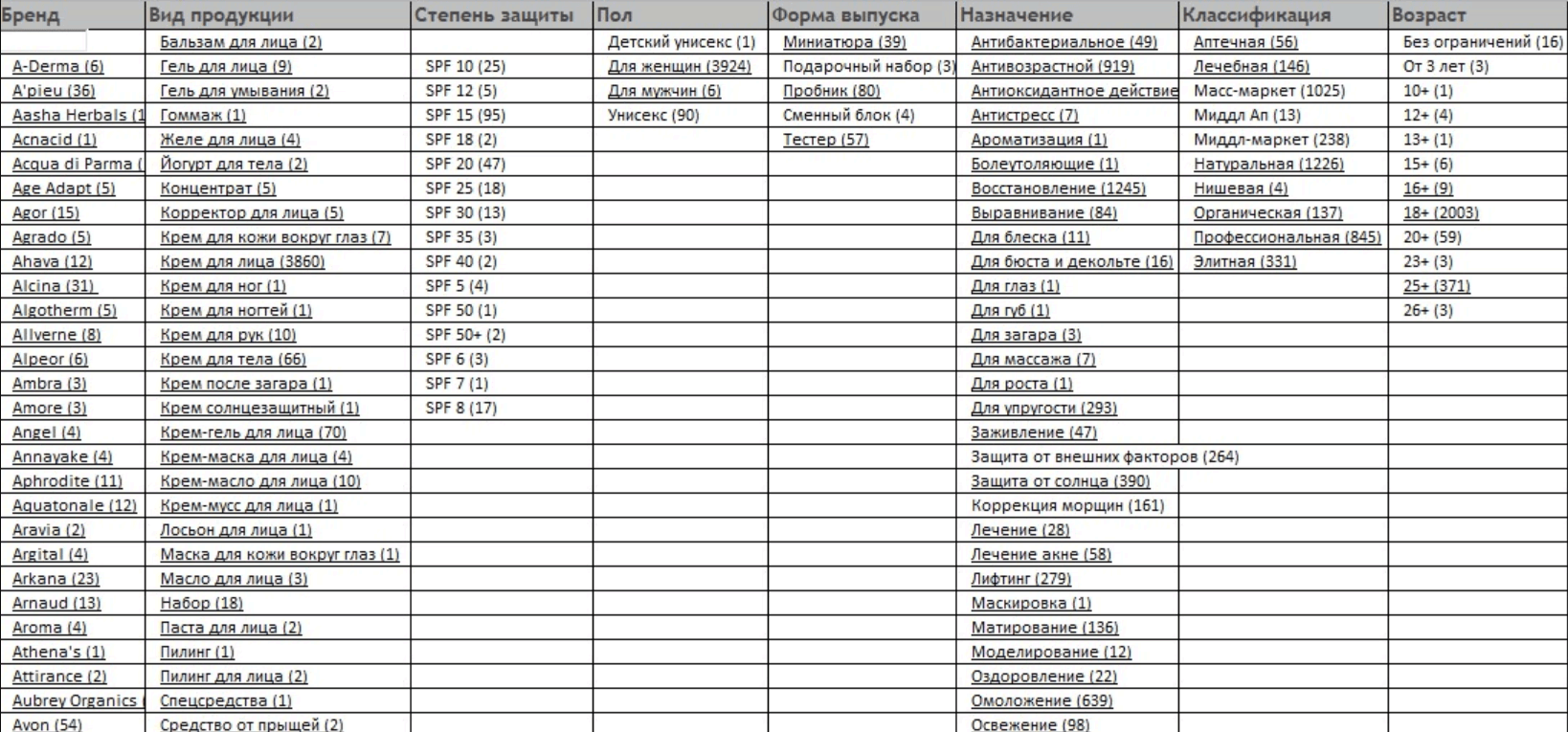

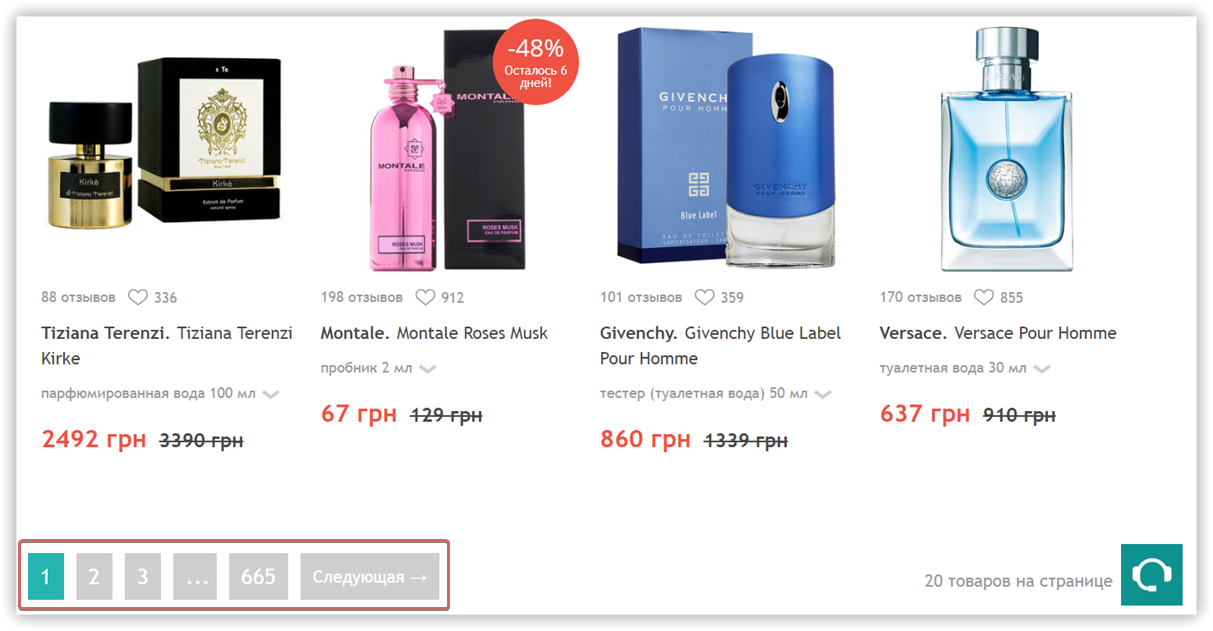

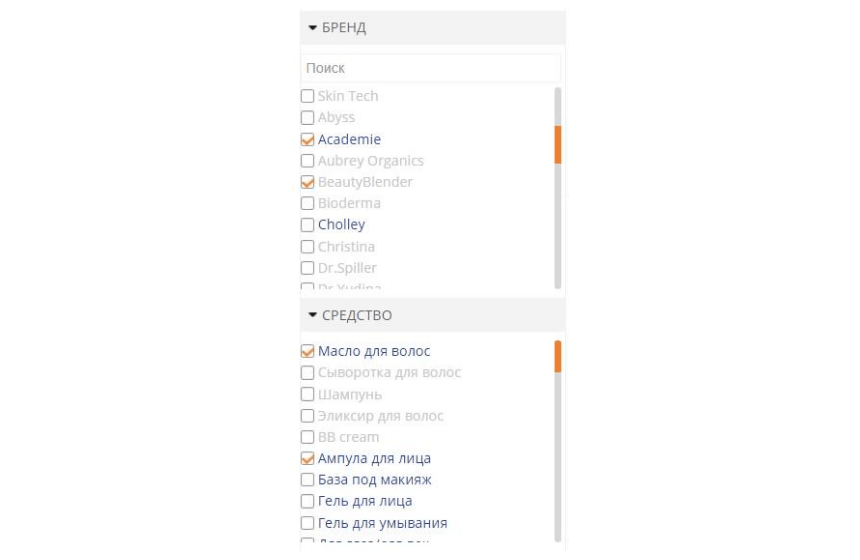

Или второй пример: для любого интернет-магазина важна удобная фильтрация. Для этого создаются фильтры, которые формируют множество комбинаций. Чтобы увидеть, какое количество страниц создается из-за комбинаций фильтров возьмем пример из интернет-магазина косметики — страница Крем для лица.

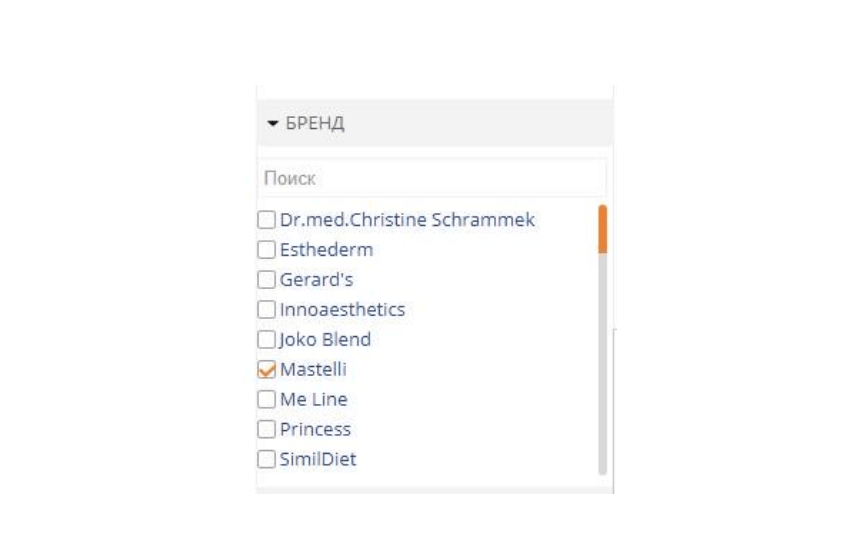

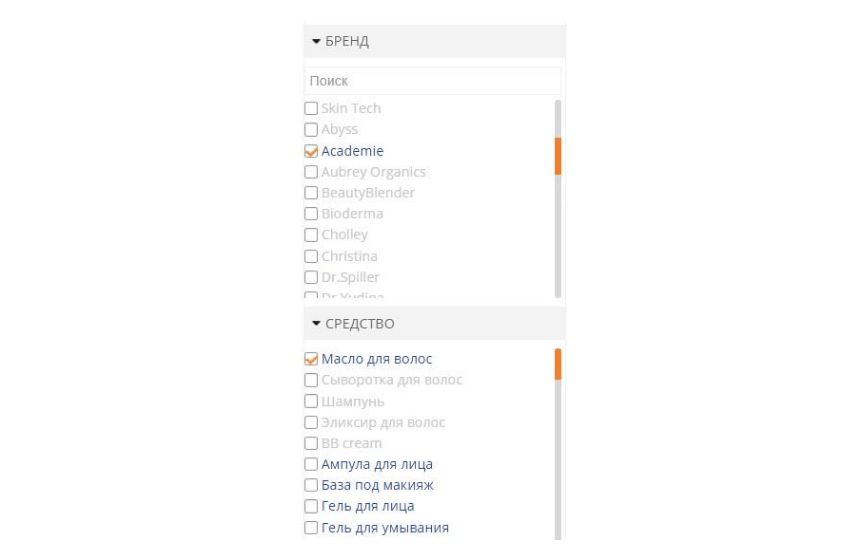

Составляем такую табличку: список названий и значений фильтров (на картинке только бренды на букву А).

Как управлять краулинговым бюджетом?

Блокируйте мусорные страницы в robots.txt, не допускайте их попадания в карту сайта. В sitemap должны попадать только полезные страницы, освобождайте ее от мусора, URL с редиректами, canonical, ошибками сканирования.

Не забывайте указывать в карте сайта last-modified, чтобы избежать повторного сканирования страниц, которые не менялись после того, как ее просканировали. Это также позволит не растрачивать впустую краулинговый бюджет, Google бот пойдет дальше по измененным или новым страницам. Так он сможет проиндексировать новые страницы, а не заходить на те, которые уже ранее сканировал.

Кроме этого, каждое перенаправление — это потеря краулингового бюджета. Проверяйте на своем сайте цепочки редиректов, анализируйте их необходимость, в идеале избавляйтесь от них.

Согласно Google, не все краулеры способны быстро и благополучно обрабатывать javaSсript. Конечно, нам все обещают, что этот вопрос будет решен, но на сегодня Google рекомендует применять именно динамический рендеринг.

Нужно, чтобы сервер определял краулер. Запросы от краулеров будут передаваться рендереру, а от пользователей — обрабатываться в обычном режиме. При необходимости динамического рендеринга будет предоставляться версия контента, которая подобрана для определенного краулера. Например, для бота показываем статическую HTML-версию.

Динамический рендеринг можно настроить на всех URL сайта или на определенных. Так вы сможете облегчить боту сканирование страниц вашего сайта. Он не будет тратить лишние ресурсы на загрузку всех деталей, а сразу получит HTML-версию. Как пошагово внедрить рендеринг на сайте читайте в статье блога Google.

Почему нужно оптимизировать фильтры?

В своей практике мы часто наблюдаем такие ситуации, когда в индексе находятся страницы с нечастотными комбинациями фильтров, со страницами без товаров и т.д. В то же время, частотные кластеры не попадают в индекс, из-за чего теряется ценный трафик.

- если выбран один фильтр из блока фильтров:

- если выбраны по одному фильтру из двух разных блоков:

- если выбрано два и больше фильтра одного блока фильтров:

- Если выбрано два и больше фильтров разных блоков фильтров

Для первичной оптимизации фильтров этого достаточно. Но этот способ не самый эффективный, так как некоторые важные комбинации оказывались закрытыми, а ненужные попадали в индекс.

По частотности кластера можно понять важный он для продвижения или нет:

Как закрыть страницы от индексации?

Мы проанализировали серверные логи сайтов и увидели, что страницы с nofollow Google бот успешно индексирует. Поэтому данный способ, хоть и является самым популярным, но не дает 100% гарантии закрытия страниц от краулера.

Суть метода заключается в следующем:

- Post передаем ссылку серверу;

- Redirect браузер получает от коннектора с сервера URL;

- Get браузер запрашивает данные новой страницы.

Преимущество этого способа состоит в том, кто не тратится краулинговый бюджет, как в случаем с nofollow. Ссылки будут закрыты от поисковых систем на 100%.

Недостаток — переход по такому URL будет медленней, чем обычный переход по ссылке.

Вы запрещаете боту доступ к файлу *.js, в котором хранится исполняемый код и скрываемый контент, вдобавок закодированный стандартом Base64. Причем в HTML-коде вы также не увидите URL-адреса. В таком случае браузеры смогут исполнять код, а Google — нет.

Но с этим методом нужно быть аккуратным, использовать для улучшения сайта, а не для манипуляций с поисковой системой. Иначе, могут быть санкции, так как по сути это клоакинг. Часто не автоматические, а по «стуку» конкурентов или по оценке асессоров.

Выводы

Serpstat — набор инструментов для поискового маркетинга!

Находите ключевые фразы и площадки для обратных ссылок, анализируйте SEO-стратегии конкурентов, ежедневно отслеживайте позиции в выдаче, исправляйте SEO-ошибки и управляйте SEO-командами.

Набор инструментов для экономии времени на выполнение SEO-задач.

Используйте лучшие SEO инструменты

Проверка обратных ссылок

Быстрая проверка обратных ссылок вашего сайта и конкурентов

API для SEO

Получите быстро большие объемы данных используя SЕО API

Анализ конкурентов

Сделайте полный анализ сайтов конкурентов для SEO и PPC

Мониторинг позиций

Отслеживайте изменение ранжирования запросов используя мониторинг позиций ключей

Рекомендуемые статьи

Кейсы, лайфхаки, исследования и полезные статьи

Не успеваешь следить за новостями? Не беда! Наш любимый редактор подберет материалы, которые точно помогут в работе. Только полезные статьи, реальные кейсы и новости Serpstat раз в неделю. Присоединяйся к уютному комьюнити :)

Нажимая кнопку, ты соглашаешься с нашей политикой конфиденциальности.