Начните искать ключевые слова

Используйте Serpstat, чтобы находить лучшие ключи

SEO-инсайты, которые можно достать из логов серверов

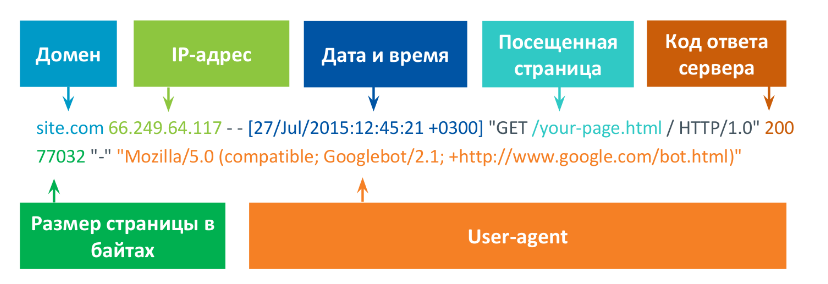

Что собой предоставляют логи серверов?

- домен,

- IP-адрес, с которого был переход,

- точное время посещения запроса,

- сама страница, которая была посещена скраулером,

- код ответа, с которыми сталкиваются и роботы, и люди,

- размер страницы в байтах,

- user-agent — имя клиента, который обратился к серверу. Находится в HTTP-заголовке. Так по имени можно узнать какой браузер или робот обращался к странице.

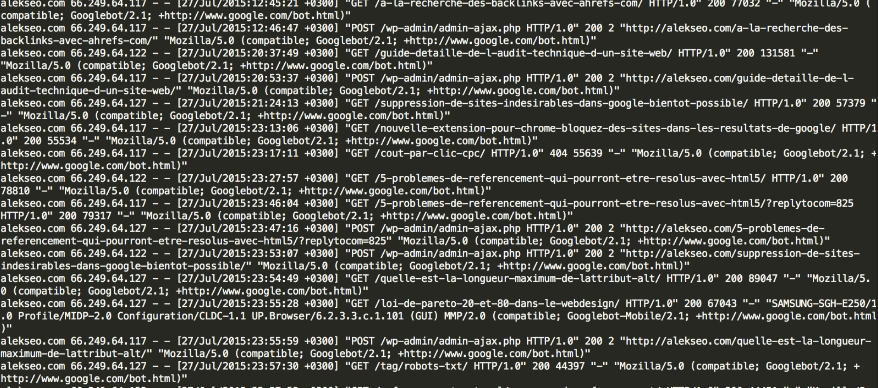

Когда происходят несколько сотен посещений, все такие строки суммируется в непонятное мессиво, которое на первый взгляд абсолютно не читабельно и неоперабельно. Оно выглядит примерно так:

Если логи имеются у вас на сервере, их можно найти по одному из следующих адресов:

Nginx /var/log/nginx/access.log

IIS %SystemDrive%\inetpub\logs\LogFiles

У каждого из них логи лежат в разных местах + путь к ним можно переопределить в настройках виртуальных хостов. Например, у nginx логи могут лежать в /var/log/nginx/ или /usr/local/nginx/logs/

Это зависит от того, как именно он был установлен. Чаще всего, путь к логам переопределяют в настройках, эти настройки можно найти в каталоге /etc/nginx/

Лучше всего сделать поиск по всему каталогу "access_log". Это настройка, которая отвечает за путь к логам. На многих серверах её отключают для экономии места на диске.

В apache ситуация аналогичная, путь к нему /etc/apache2/

Только за логи отвечают настройки ErrorLog и CustomLog

Проверяем сами: что можно узнать с помощью Googlebot?

Аналитика логов сервера — самый надежный источник данных о том, как поиск относится к нашим сайтам.

Googlebot и неактивные ссылки

- Нужно иметь небольшой сайтик,

- использовать Google Search Console (нужно принудительно пригласить робота на эту страницу),

- и там уже посмотреть, какие страницы у нас правильно или неправильно отображаются.

Что получилось на выходе?

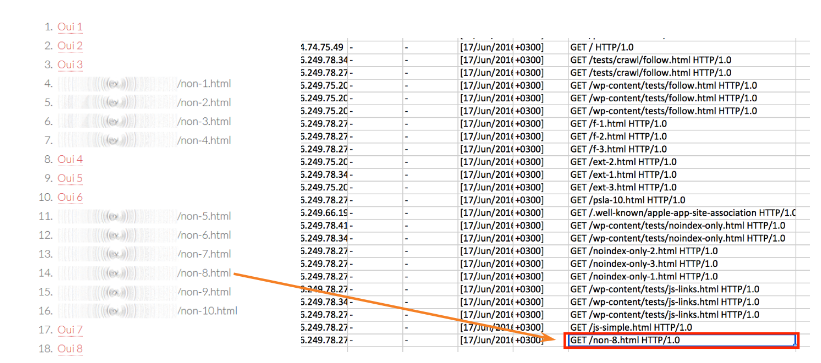

Файл был добавлен в Search Console и робот перешел по всем ссылкам, которые были активны. Но через несколько дней в логах сервера появились такие адреса:

Googlebot и robots.txt

При работе с файлом robots.txt нужно запомнить важные моменты:

Нередко случается, что многие страницы, которые мы закрыли robots.txt, могут встречаться в результатах выдачи. В заголовке сниппета указано не то, что мы писали в Тайтле, а в описании отмечено, что не возможно его показать по ограничению файла robots.txt

Все дело в том, что Googlebot может видеть страницы, которые закрыты инструкциями robots.txt, но не может переходить на них. Он использует внешние сигналы — анкоры внешних ссылок, которые ведут на нашу страницу в robots.txt.

То есть он показывает пользователю, что этот файл существует, но не может к нему постучаться. Он лишь отображает заголовок страницы, который он высчитал из анкоров входящих ссылок и говорит о том, что страница закрыта в файле robots.txt. И сохраненной копии такой страницы нет.

Пример: Если мы посмотрим срез по одному проекту с посещаемостью около 100 000 в день (сайт по недвижимости), то увидим посещаемость страниц robots.txt. Их примерно от 50 до 100 в день.

Часто начинающему специалисту приходит такая задача: на сайте обнаружено большое количество мусорных страниц, и их нужно удалить.

Что он делает?

Он берет весь возможный арсенал средств, сначала закрывает страницу в robots.txt, размещает метатег <meta name="robots" content="noindex">, а потом начинает удивляться: почему некоторые страницы все еще остаются в индексе.

А это случилось потому, что возник конфликт: с одной стороны мы говорим, что страница не в индексе, с другой стороны мы блокируем доступ робота к этой странице. Фактически Googlebot не увидит того содержания документа.

Поэтому для того, чтобы избавиться от мусорных страниц лучше всего использовать директивы meta name="robots". Робот все просканирует, узнает, что нужно выкинуть, а вы потом добавьте это в robots.txt.

Задача: удалить из индекса много ненужных страниц.

Частая ошибка: robots.txt + meta name="robots" "noindex".

Правильный вариант: meta name="robots" content="noindex", убедиться, что страницы не в индексе, а потом robots.txt.

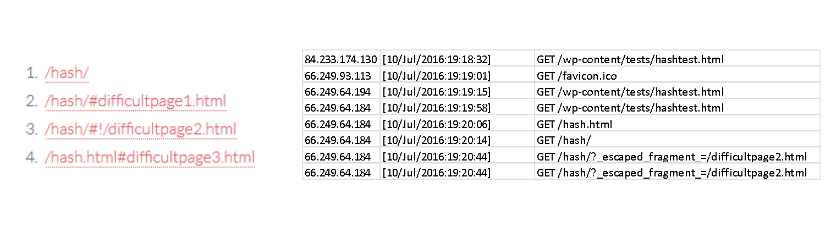

Googlebot и адреса с решеткой

Эксперимент: Я создал страницу со следующими типами ссылок:

- Ссылка с решеткой, которая стоит в одиночку и указывает на отдельной место нашей страницы.

- Ссылка с решеткой и восклицательным знаком.

Все, что после хэш # в URL точно не распознается гуглботом, а может быть распознано только если хэшбэнг #!

Google преобразовал страницу следующим образом: вместо #! добавил ?_escaped_fragment_=/

Когда контент на странице обновляется без перезагрузки, то робот ПС не сможет его найти. Роботу нужны отдельные URL. Чтобы дать отдельные URL при использовании ajax, серверы и роботы поисковиков договорились, что Google будет добавлять ?escaped_fargment в URL и по такому можно адресу получить контент страницы.

Использование ?_escaped_fragment_ все еще работает при сканировании объектов документа, но уже не рекомендуется Гуглом с октября прошлого года.

Что такое краулинговый бюджет и куда он уходит?

А это значит, для того, чтобы робот Google посещал хотя бы раз в три месяца каждую из этих страниц, он должен каждую секунду сканировать 77 млн страниц. Это очень сложная задача, поэтому был введен так называемый краулинговый бюджет.

Краулинговый бюджет — процессорное время, выделяемое поисковой системой для сканирования определенного сайта за единицу времени. И основной фактор влияния в нем является эффективность документа.

В наших руках — руках каждого оптимизатора, правильно распределить микроквоту, которая дается нашему сайту.

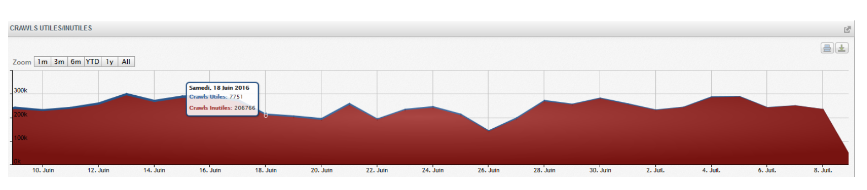

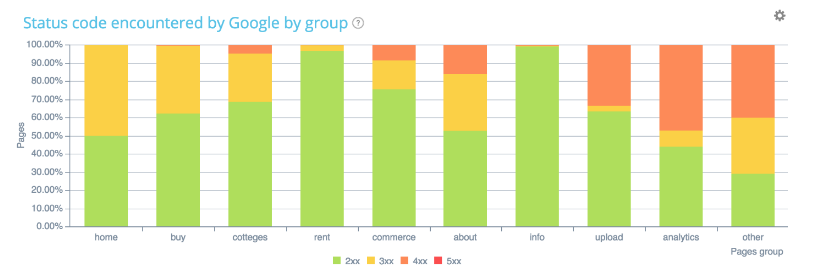

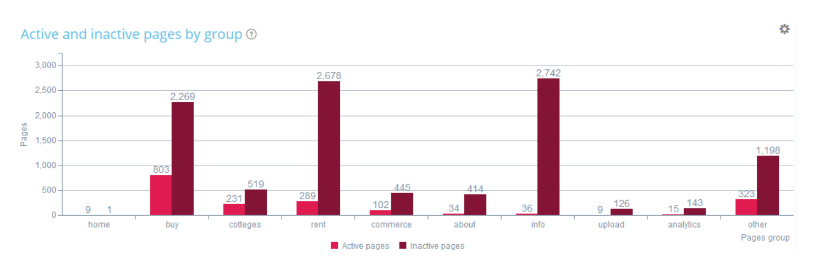

Пример: Вот это проект крупного сайта по недвижимости. Все, что обозначено красным на графике — это бесполезный краулинг (то есть краулинг, который не приносит ни одного визита нашему сайту). Синяя полоска — краулинг полезный.

Еще один пример:

Это снова сайт по продаже недвижимости. Допустим, на данном этапе продвижения для нас очень приоритетным является раздел «Аналитика». Однако из всего числа страниц, который содержит этот раздел, робот краулит только 41%.

1.Совпадают ли ваши приоритетные зоны сайта с предпочтениями робота Google?

Здесь важно сопоставить: что знает о вашем сайте поиск, а что знает программа.

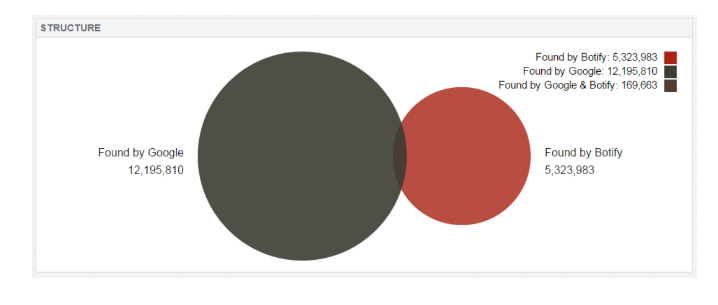

На примере крупный онлайн-ритейлер (~10 млн переходов из поиска в месяц). У сайта есть пять миллионов страниц, которые были найдены в результате сканирования сайта самостоятельно. Но есть еще 12 миллионов страниц, о которых почему-то знает робот. Такие страницы-называются страницами-сиротами. И их нужно анализировать.

2. Страницы-сироты

- Страницы, на которые ведут внешние ссылки, но нет внутренних.

- Страницы с исправленными ошибками, но в базе Googlebot.

- Более неактуальные страницы с кодом 200OK.

- Оставшиеся после переезда страницы.

- Ошибки в rel=«canonical» и sitemap.xml.

3. Активные страницы

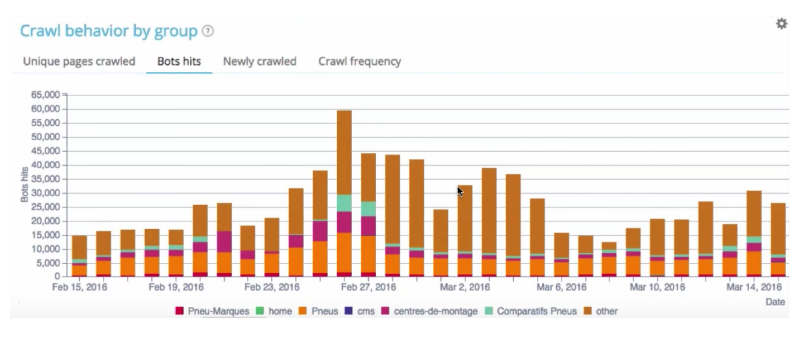

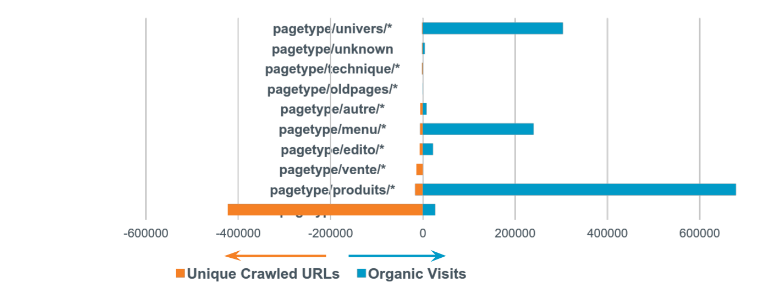

На примере интернет-магазин по продаже игр (1 млн переходов из органического поиска). Разложим визиты Гуглбота по категориям слева, а справа все посещения, которая дала категория.

Получили результаты поиска по сайту, который расходует весь краулинговый бюджет и все ресурсы робота. Многие страницы дают нам очень мало. И это большая проблема.

Как оценить эффективность разделов сайта и над чем работать в первую очередь?

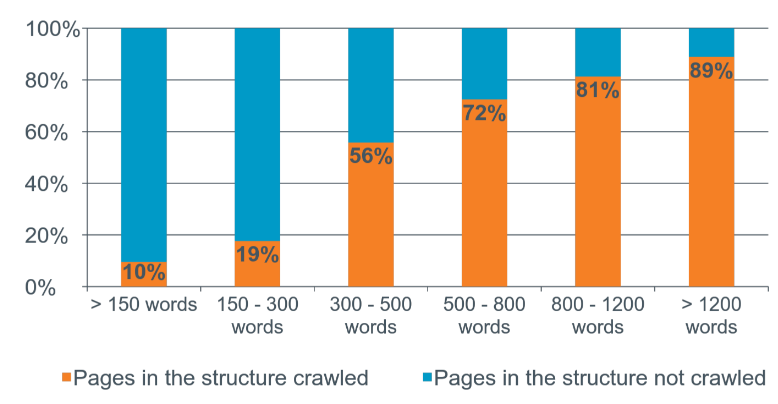

Какого объема контент нам нужен на странице?

Например, это проект по продаже автомобилей.

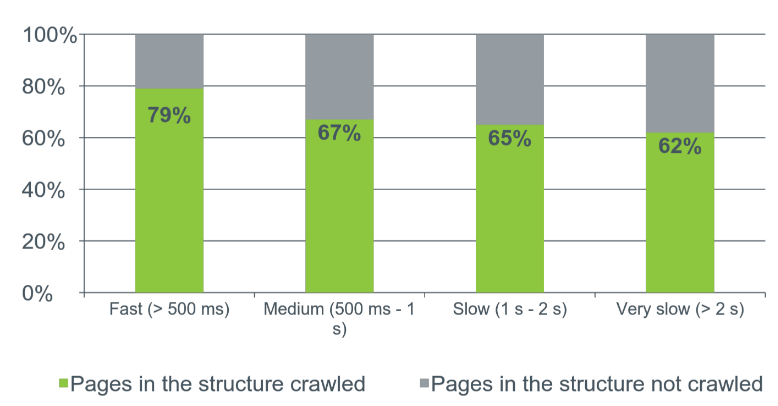

Краулинг и скорость загрузки

Эксперимент:

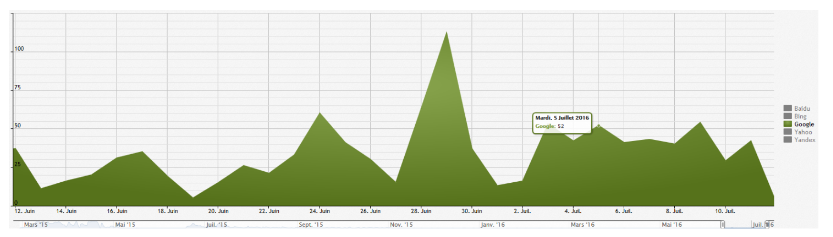

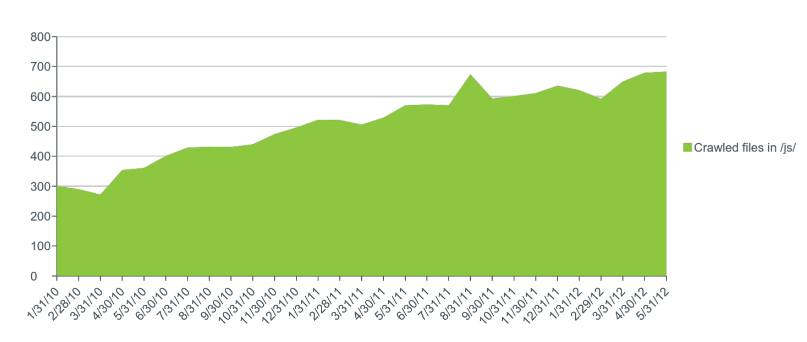

Глобальные тренды в поведении Googlebot'а

Например, можно проследить тенденции поведения гуглбота. На слайде видно, что Гуглбот чаще начал обращаться к файлам javascript. Это связано с важностью анализа ботом удобства версий для мобильных устройств.

Отслеживаем эффект от своих действий

Можно с легкостью фиксировать:

- рост и падения;

- сработали ли изменения;

- успешно ли прошел переезд;

- повлияла ли перелинковка и т.д.

И напоследок:

два подхода в работе с логами серверов

два подхода в работе с логами серверов

Аудит

- Логи за 30-60 дней (размер и тематика).

Берутся логи за месяц или за два и делается срез — смотрится, какие проблемы выявлены за этот период. - Кросс-аналитика: Краулинг + Логи + Google Analytics.

К логам всегда подключаются данные краулинга — сканирования сайта, и GA. - Диагностика полезных и бесполезных страниц, зон сайта, о которых Google знает и нет.

При мониторинге нужно загрузить в разные системы обработки данных ваши логи за каждый день и настроить оповещения об ошибках, росте и уменьшении объемов краулинга, атаках, а также сканировании новых страниц.

Мониторинг обязателен при редизайне / переезде сайта — сразу можно увидеть как изменения повлияли на сайт.

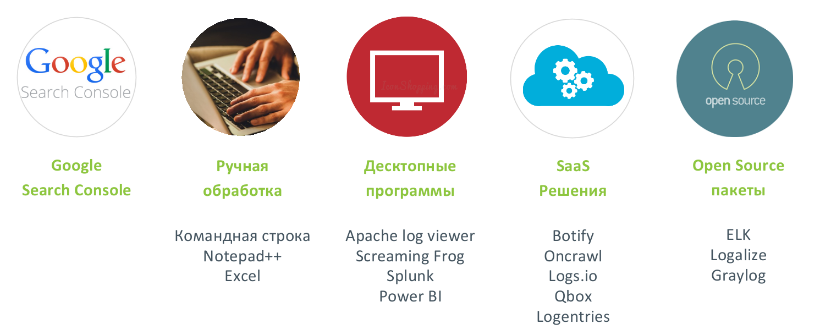

Существует следующие инструменты для работы с логами, некоторые из них платные, а некоторые бесплатные:

Подведем итог

- Оценка ссылочных кампаний на основе роста краулингового бюджета и частоты краулинга.

- Определение наложения антиспам фильтров типа «Google Panda».

Используйте лучшие SEO инструменты

Проверка обратных ссылок

Быстрая проверка обратных ссылок вашего сайта и конкурентов

API для SEO

Получите быстро большие объемы данных используя SЕО API

Анализ конкурентов

Сделайте полный анализ сайтов конкурентов для SEO и PPC

Мониторинг позиций

Отслеживайте изменение ранжирования запросов используя мониторинг позиций ключей

Кейсы, лайфхаки, исследования и полезные статьи

Не успеваешь следить за новостями? Не беда! Наш любимый редактор подберет материалы, которые точно помогут в работе. Только полезные статьи, реальные кейсы и новости Serpstat раз в неделю. Присоединяйся к уютному комьюнити :)

Нажимая кнопку, ты соглашаешься с нашей политикой конфиденциальности.