Начните искать ключевые слова

Используйте Serpstat, чтобы находить лучшие ключи

9 лучших инструментов для парсинга сайтов в помощь SEO-специалисту

В статье мы познакомим вас с актуальными инструментами парсинга, это поможет быстро и эффективно выбирать необходимые данные для задач поискового продвижения. Надеемся, они помогут вывести вашу работу на качественно новый уровень.

- Алгоритм парсинга

- Парсинг и закон

- Какие данные и элементы можно спарсить?

Лучшие инструменты парсинга для SEO-специалиста

- Netpeak Spider

- Netpeak Checker

- A-Parser

- import.io

- ParseHub

- Screaming Frog SEO Spider

- ComparseR

- Google Spreadsheets

- Serpstat

FAQ

Домашнее задание

Что такое парсинг сайтов и как он помогает SEO-специалисту

В программном смысле сбор информации – достаточно трудный процесс. Для написания стабильно работающего парсера надо хорошо разбираться в регулярных выражениях и языке запросов XPath. Плюс уметь обрабатывать ошибки и ответы страниц. Естественно, нельзя обойтись без навыка программирования хотя бы на среднем уровне.

Большинство SEO-специалистов не располагают глубокими знаниями в IT-технологиях. Потому сбор данных вызывает у них проблемы. К счастью, профессиональные разработчики ПО давно придумали программы для парсинга информации. Разобраться со многими из них не составит труда даже далекому от программирования человеку.

Современные инструменты веб-парсинга осуществляют извлечение данных как с единичных, так и многочисленных веб-ресурсов. В зависимости от функционала, ПО производит автоматический сбор мета-тегов, котировок валют, расписаний авиарейсов, описаний продукции интернет-магазинов и пр.

Алгоритм парсинга

2. Парсинг HTML-кода страниц.

3. Составление отчета согласно установленным параметрам.

Третий пункт опциональный, так как инструменты парсинга сайтов не всегда поддерживают функционал по формированию отчетов и структурированию информации. Например, простые самописные скрипты на PHP или Python зачастую сохраняют извлеченные из веб-страниц данные в обычные текстовые документы. Затем они обрабатываются другими программами или анализируются в исходном виде.

Главное преимущество, которое сочетает любой инструмент парсинга данных, заключается в экономии времени. Допустим, SEO-специалист решил заняться сбором данных конкурентов. Для этого ему надо скопировать и структурировать внушительный объем информации со 100 сайтов. Вручную процесс рискует затянуться на десятки часов. Правильно настроенный парсер справится гораздо быстрее.

Не стоит забывать и про человеческий фактор. Людей утомляет однообразная работа. Чем дольше работаешь в таком режиме, тем сильнее устаешь и совершаешь больше ошибок. Программы лишены недостатков человека. Главное, правильно указать, что можно и нельзя парсить. Об остальном позаботится ПО. Задаете настройки, идете пить чай или кофе, приходите, а нужная информация собрана. Удобство и практичность налицо!

Парсинг и закон

- сбор информации не нарушает чьих-либо авторских прав;

- данные в свободном доступе и не содержат коммерческой тайны;

- программы для сбора данных не вызывают сбоев в работе сайтов.

При любых сомнениях в законности парсинга проконсультируйтесь с юристами! Этим вы убережете себя от проблем с законом и крупных штрафов в будущем.

Какие данные и элементы можно анализировать с помощью парсинга?

2. Котировки ценных бумаг.

3. Тематические статьи.

4. Изображения разных форматов.

5. Аудио и видео файлы.

6. Документы.

7. Контактная информация.

8. Таблицы.

9. Программный код.

Представленные на рынке парсеры сайтов собирают практически любые данные. Что касается SEO-специалистов, то они пользуются программами для широкого круга задач:

1. Поиск ссылок на удаленные страницы.

2. Обнаружение неправильных 301 редиректов.

3. Нахождение дублей мета-тегов и заголовков страниц.

4. Анализ файла ROBOTS.TXT и соблюдения правил микроразметки.

5. Выявление ухудшающих поисковое продвижение страниц.

6. Сбор информации о сайтах конкурентов.

7. Подготовка данных для написания технических заданий.

8. Проверка позиций в выдаче популярных поисковых систем.

9. Заполнение интернет-магазинов контентом с официальных веб-сайтов производителей.

Лучшие инструменты парсинга для SEO-специалиста

Сбор информации осуществляется по списку адресов или в пределах одного сайта. Поддерживается 4 вида поиска – по содержимому, CSS, регулярным выражениям или языку запросов XPath. Пользователь имеет возможность задавать до 100 поисковых условий, чего более чем достаточно для многочисленных задач.

Парсер «Нетпик Спайдер» подходит для извлечения контактов, проверки микроразметки, анализа атрибутов HTML-тегов и пр. Собранные данные представляются в таблицах. Табличный вид особенно удобен, если SEO-специалист работает с сетями сайтов или проектами, где региональные веб-ресурсы выносятся на подддомены.

Официальный сайт – https://netpeaksoftware.com/ru/spider

Парсер выдачи Netpeak Checker позволяет задавать кастомные настройки. Наряду с языком, страной и геолокацией поддерживается использование поисковых операторов. При необходимости легко наложить ограничения по виду сниппетов. Скажем, картинки, новости или видеоролики.

В «Нетпик Чекер» включена проверка индексации веб-страниц. Программа анализирует индекс в Bing, Yahoo и Google. Если предстоит работать с внушительным количеством адресов, к услугам пользователей поддержка прокси и популярных сервисов для разгадывания капчи вроде RuCaptcha или CapMonster.

Официальный сайт – https://netpeaksoftware.com/ru/checker

Разработчики оперативно обновляют встроенные в программу парсеры, что гарантирует их стабильную работу при изменениях HTML-кода источников. Консультации по вопросам использования «А-Парсер» оказываются бесплатно. На официальном сайте работает форум для общения пользователей.

Несмотря на широкий функционал, ПО не слишком требовательно к ресурсам. Многие SEO-специалисты устанавливают парсер на офисные компьютеры или недорогие виртуальные сервера. Для относительно комфортной работы вполне хватает VDS с арендной платой 5-10 $ в месяц.

Официальный сайт – https://a-parser.com

Помимо онлайн-сервиса, пользователям предлагаются бесплатные программы для различных операционных систем. Приложения облегчают процесс создания экстракторов и роботов для поиска информации. Дополнительно программы согласовывают данные с пользовательскими учетными записями.

На сайте сервиса работает форум поддержки. Есть раздел с подробной справкой. Периодически разработчики публикуют обучающие видео. Проект постоянно развивается и обрастает новым функционалом. За удобство и стабильность работы его высоко ценят и SEO-специалисты, и крупные компании из области Data Science.

Официальный сайт – https://www.import.io

В парсере применяется машинное обучение. Поддержка последнего открывает возможность извлекать данные из документов со сложной HTML-разметкой. Экспорт собранной информации производится в файлы формата CSV или JSON.

Функционал программы весьма обширен. Кроме стандартных текстов, ПО обрабатывает карты, календари, ссылки из выпадающих меню и формы для отправки данных. Поддерживает парсер и аутентификацию вместе с бесконечной прокруткой страниц.

Бесплатная версия программы парсит до 200 страничек приблизительно за 40 минут. Число проектов ограничивается 5. Техническая поддержка оказывается в ограниченном режиме. Данные сохраняются до 2 недель.

Официальный сайт – https://www.parsehub.com

Screaming Frog SEO Spider

Программа умеет находить битые ссылки, проводить аудит редиректов, анализировать заголовки и метаданные страниц. ПО автоматически генерирует карты сайтов в формате XML и поддерживает извлечение данных посредством XPath. Если надо найти дубли контента, Screaming Frog SEO Spider справится и с этим. Одновременно визуализирует архитектуру веб-сайта в понятном для человека виде.

В ПО предусмотрен планировщик заданий для автоматизации парсинга по расписанию. Предположим, вы хотите получать отчеты о состоянии сайта 1 раз в неделю по понедельникам. Выставляете настройки, парсер начинает собирать информацию в указанное вами время. Данные экспортируются в любую нужную вам локацию, в том числе сервис онлайн-таблиц Google Sheets.

Официальный сайт – https://www.screamingfrog.co.uk

Приложение выявляет технические проблемы и информирует о них в отчетах. Сайт проверяется на ошибки с кодом 404, дубли заголовков страниц и наличие внутренних редиректов. Обнаруживаются и запрещенные к индексации странички. Краулер реально настроить таким образом, что он будет представляться веб-сайту как робот поисковика.

К программе подключены сервисы по разгадыванию капчи. Применение регулярных выражений гарантирует гибкость парсинга выдачи. Программа также удаляет URL из индексной базы в пакетном режиме. По заверениям создателя ПО, инструмент является уникальным и производит удаление в 1 клик.

Официальный сайт – https://parser.alaev.info

Google Spreadsheets

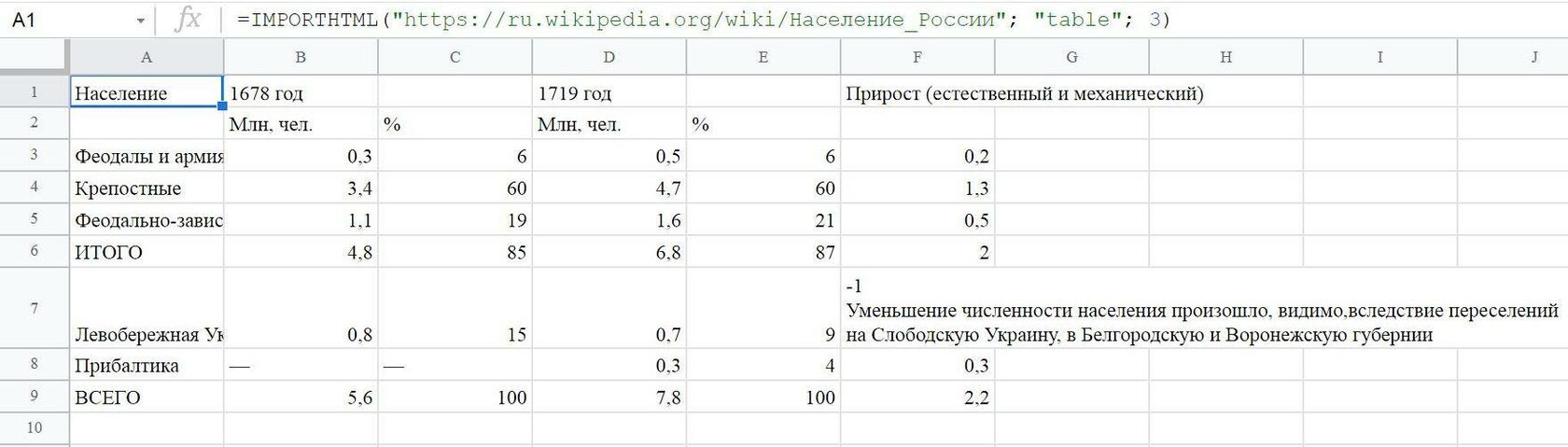

IMPORTHTML извлекает данные из списков или таблиц. Функция поддерживает 3 параметра. Ссылка указывает на веб-страницу для сбора данных, а запрос – на их тип. Речь идет о list или table. Индекс отвечает за порядковые номера элементов. Обратите внимание, что отсчет начинается с 1.

Синтаксис =IMPORTHTML(«ссылка»; «запрос»; индекс) 3)

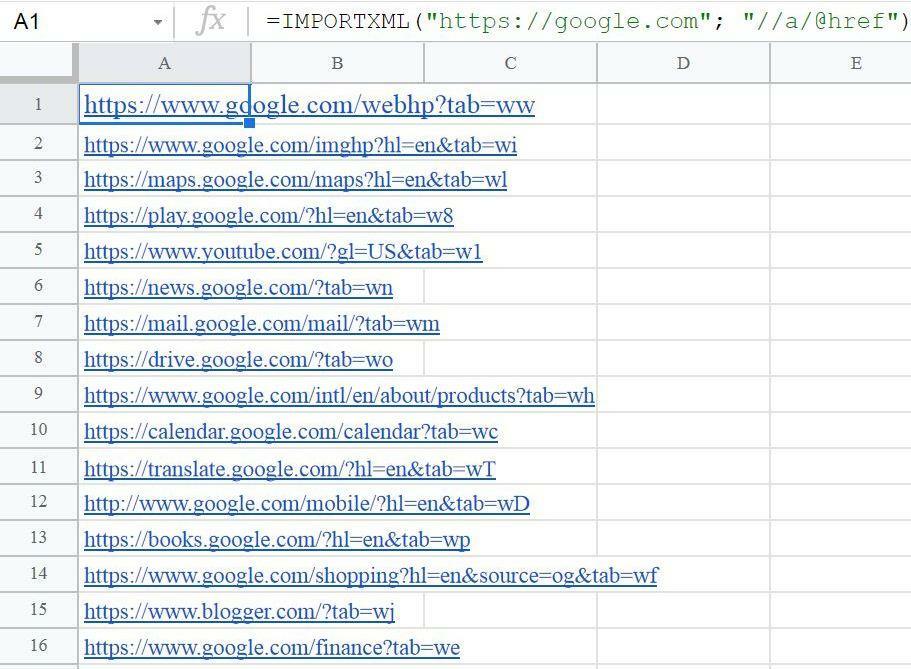

Синтаксис =IMPORTXML(«ссылка»; «запрос_xpath»)

Пример использования =IMPORTXML(«https://google.com»; «//a/@href»)

Недостаток таблиц Google заключается в ограничениях сервиса. В промышленных масштабах парсить данные не выйдет. Виной тому лимиты на количество исходящих запросов. В документ легко добавить хоть 10000 конструкций для парсинга. По факту отработает малая часть. В ячейках, где функции не сработают из-за лимитов, вместо данных останется надписать Loading.

1. Официальный сайт Google Spreadsheets. https://spreadsheets.google.com

2. Справка по IMPORTHTML. https://support.google.com/docs/answer/3093339?hl=ru

3. Справка по IMPORTXML. https://support.google.com/docs/answer/3093342?hl=ru 4. Руководство по XPath. https://www.w3schools.com/xml/xpath_intro.asp

Второй инструмент – парсинг частотности ключевых запросов с поддержкой точного и широкого соответствия. Это незаменимый сервис для анализа и подготовки семантического ядра. Он также оптимален для запуска рекламных кампаний в контекстных сетях. 100000 ключей обрабатывается всего за 70 минут. Данные выгружаются в JSON. Частота фраз проверяется по регионам и городам. В рамках White Label отчеты допускается брендировать логотипами сторонних компаний.

Третий вид парсинга применяется для сбора данных по размещающимся в топе объявлениям контекстной рекламы. Парсер платной выдачи настраивается с учетом поисковика, языка запроса, региональной принадлежности и города. Время и частотность сбора данных устанавливаются пользователем. За счет этого инструмент адаптируется под потребности конкретного бизнеса. Немаловажным преимуществом сервиса считается доступная цена пробивки 1 запроса.

- Официальный сайт Serpstat. https://serpstat.com/ru

- Статья о преимуществах парсинга топа контекстной рекламы. https://serpstat.com/ru/blog/kak-obojti-krupnejshih-reklamodatelej-na-rinke/

- Пост о парсинге топа для проведения анализа ниши. https://serpstat.com/ru/blog/analiz-nishi-s-pomoschyu-parsinga-topa-v-serpstat/

- Подробный разбор парсинга частотности ключевых слов. https://serpstat.com/ru/blog/parsing-chastotnosti-serpstat/

FAQ

С помощью какого инструмента можно быстро спарсить и проанализировать мета-теги на сайте?

Для парсинга малого числа документов подходит Google Spreadsheets. Ниже представлены формулы для извлечения title и description. На место URL подставляется адрес страницы. 1. title. =IMPORTXML(«URL»; «//title») 2. description. =IMPORTXML(«URL»; «//meta[@name=’description’]/@content») Для извлечения мета-тегов из тысяч или миллионов страниц потребуется самописная программа или платное решение. Тот же A-Parser или один из продуктов NetPeak.

Какие бесплатные инструменты парсинга можно использовать для SEO-анализа?

Как вариант, Netpeak Spider или Checker. Обе программы имеют бесплатные версии с урезанным функционалом, которого хватает для базового анализа. Если собираетесь заниматься SEO профессионально, рано или поздно придется купить какой-либо инструмент. Бесплатное ПО либо нестабильно работает, либо накладывает на пользователей много ограничений.

Зачем парсить данные с сайта при SEO-анализе?

Чтобы повысить производительность труда и исключить из процесса сбора информации человеческий фактор. Чем эффективнее SEO-специалист справляется с рутинными задачами, тем он востребованней среди работодателей. Поисковая оптимизация на 80-90 % состоит из рутины. По этой причине высоко ценится умение оперативно и продуктивно решать повседневные вопросы.

Домашнее задание

Serpstat — набор инструментов для поискового маркетинга!

Находите ключевые фразы и площадки для обратных ссылок, анализируйте SEO-стратегии конкурентов, ежедневно отслеживайте позиции в выдаче, исправляйте SEO-ошибки и управляйте SEO-командами.

Набор инструментов для экономии времени на выполнение SEO-задач.

Используйте лучшие SEO инструменты

Проверка обратных ссылок

Быстрая проверка обратных ссылок вашего сайта и конкурентов

API для SEO

Получите быстро большие объемы данных используя SЕО API

Анализ конкурентов

Сделайте полный анализ сайтов конкурентов для SEO и PPC

Мониторинг позиций

Отслеживайте изменение ранжирования запросов используя мониторинг позиций ключей

Рекомендуемые статьи

Кейсы, лайфхаки, исследования и полезные статьи

Не успеваешь следить за новостями? Не беда! Наш любимый редактор подберет материалы, которые точно помогут в работе. Только полезные статьи, реальные кейсы и новости Serpstat раз в неделю. Присоединяйся к уютному комьюнити :)

Нажимая кнопку, ты соглашаешься с нашей политикой конфиденциальности.