Начните искать ключевые слова

Используйте Serpstat, чтобы находить лучшие ключи

8 фишек нестандартного анализа трафика конкурентов

Приготовьтесь, вас ждет объемный лонгрид!

Отличие методов GET от POST лежит в способе передачи данных. Запрос GET передает данные в URL, а запрос POST – в теле запроса.

Это различие описывает характеристики способов и особенности запросов для использования того либо другого способа.

Пример из кейса можно рассматривать как демонстрацию возможностей для написания собственных скриптов или использования существующих и получения данных в соответствии с вашими задачами.

Ознакомиться с актуальными APi-методами и синтаксисом можно здесь. serpstat.com/ru/api/

Пример запроса с POST-методом:

{

"id": "1",

"method": "SerpstatDomainProcedure.getDomainsInfo",

"params": {

"domains": ["nike.com", "adidas.com"],

"se": "g_us"

}

}

2. Как найти новые страницы, которые начали давать органический трафик

3. Как определять топовые страницы по трафику из контекста

4. Как определять рекламные сети, с которыми стоит поработать

5. Определяем страницы, которые сейчас «шерят»

6. Как сравнивать реферальный трафик с общих источников

7. Как палить трафик через сокращалки

8. Как получить доступ к логам конкурентов

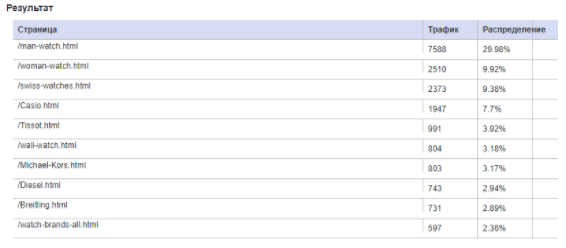

Как точно определить топовые страницы по органическому трафику

Польза от результата:

Понимание, где мы теряем и можем ли нарастить объемы целевого трафика.

В итоге я создал методику, с помощью которой можно получить более точные данные.

Что делаем?

Σ(Частота * CTR соответствующей позиции, где ранжируются фразы страниц)

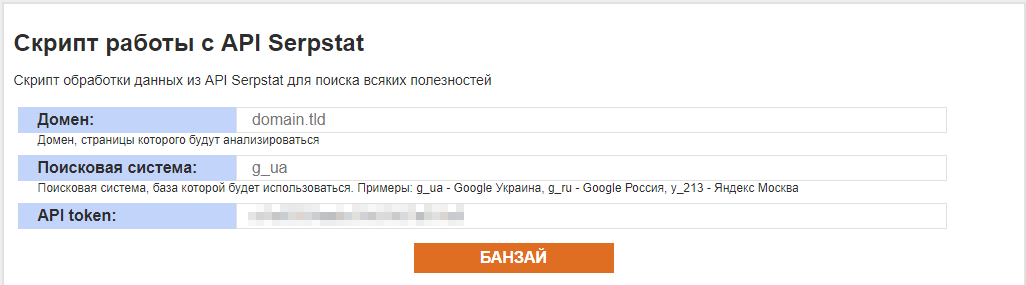

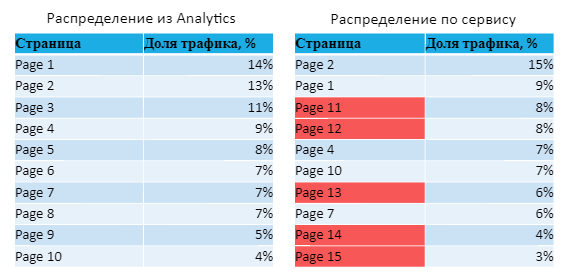

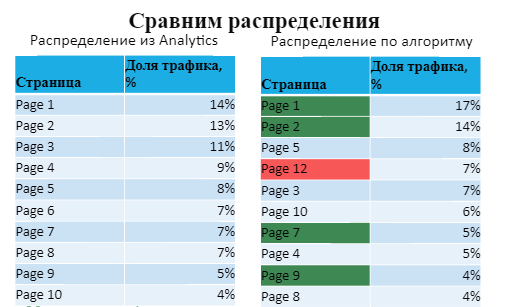

Теперь содержимое таблиц немного изменится:

Моя методика работает :)

Данные неидеальны, однако по ним уже можно что-то судить.

Главное, методика предполагает автоматизацию — получение данных нажатием одной кнопки.

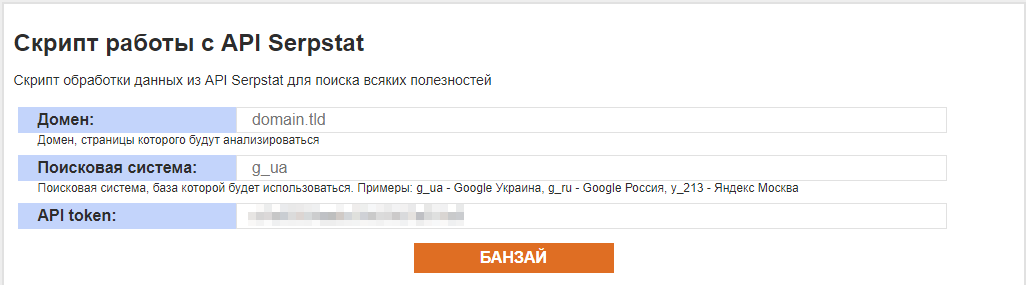

- Домен — сюда вбиваем домен без http://, https://, слэшей и т.д.

- Поисковая система — указываем с какой базой Serpstat будем работать.

- Перечень значений тут.

- token — ключ доступа к API Serpstat. Находится на странице профиля.

Ссылка на исходник: http://mz.kiev.ua/tools/8p2017/8p2017-scripts.rar

Поверьте, с ним вы получите более точные данные (хотя возможны исключения).

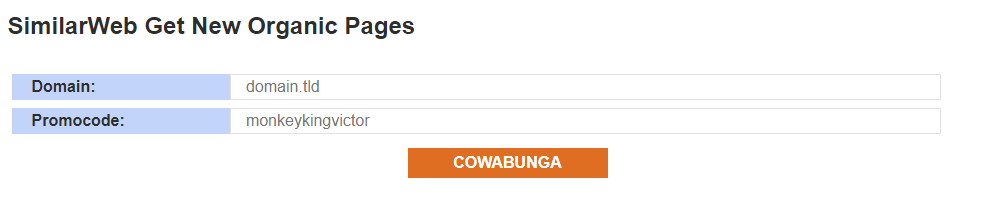

Как найти новые страницы, которые начали давать органический трафик

Польза от результата:

Можем определить, какие действия привели к росту трафика конкурента и использовать это в своих целях (сравнить, использовали ли мы аналогичное в тематике, или вообще ничего не делали, а так же и стоит ли нам что-то делать).

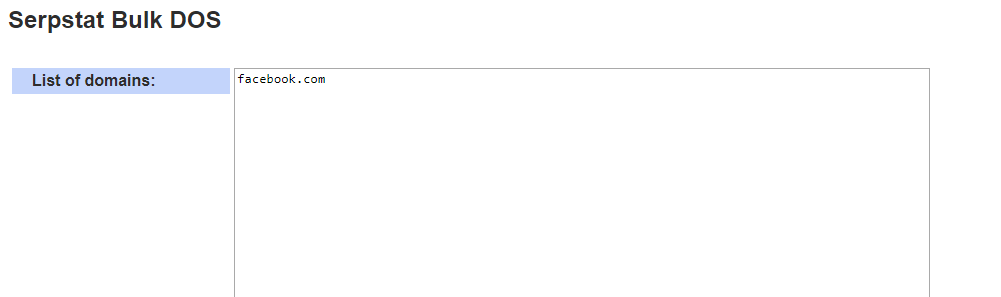

1. API Serpstat

- Домен — сюда вбиваем домен без http://, https://, слэшей и т.д.

- Поисковая система — указываем с какой базой Serpstat будем работать. Перечень значений тут.

- API token — ключ доступа к API Serpstat. Находится он на странице профиля.

Выделяем результат, копируем в Excel / Google Sheets и делаем разбивку по столбцам через точку с запятой.

Ссылка на исходник: http://mz.kiev.ua/tools/8p2017/8p2017-scripts.rar

2. API Similarweb

Соответственно, можно выделить те страницы и те запросы, частотность которых по Adwords и Wordstat вообще ноль, потому что эти запросы появились совсем недавно.

Например, сайт ITC получил очень много органического трафика, благодаря статье, посвященной проблемам с работой Приват24.

Или вот пример с интернет-магазином ALLO, который в июне получил очень много дополнительного трафика, связанного с выходом в продажу смартфона Xiaomi mi6.

Соответственно, эта методика работает не только для информационных ресурсов. Теперь вы легко узнаете, какие новые страницы конкурентов выстрелили и что использовать для своего сайта.

Сам алгоритм следующий:

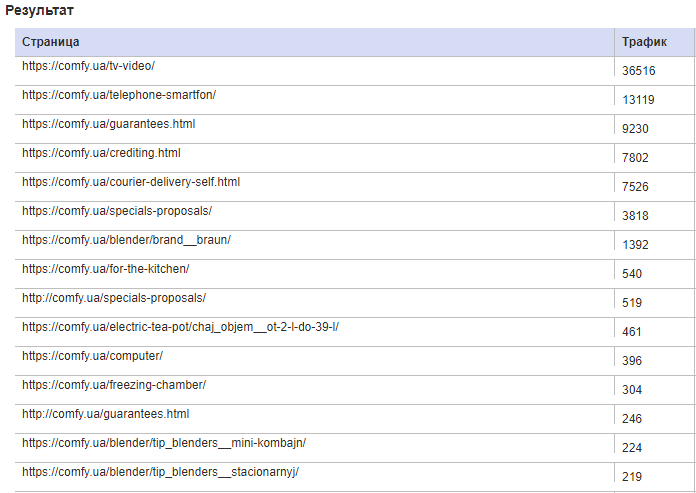

Как определить топовые страницы по трафику из контекста

В Semrush есть данные по трафику целого сайта, но нет отдельного отчета по страницам с контекстной рекламы. В Serpstat есть отчет, но здесь показываются только количество фраз для каждой страницы.

Польза от результата:

Понимание распределения трат конкурентов на контекст.

Формула: Σ(Частота * CTR).

Если у вас нет данных по CTR объявлений из Adwords, в зависимости от позиций в рамках вашей ниши, советую воспользоваться исследованием Word Stream. Там более-менее адекватное распределение CTR.

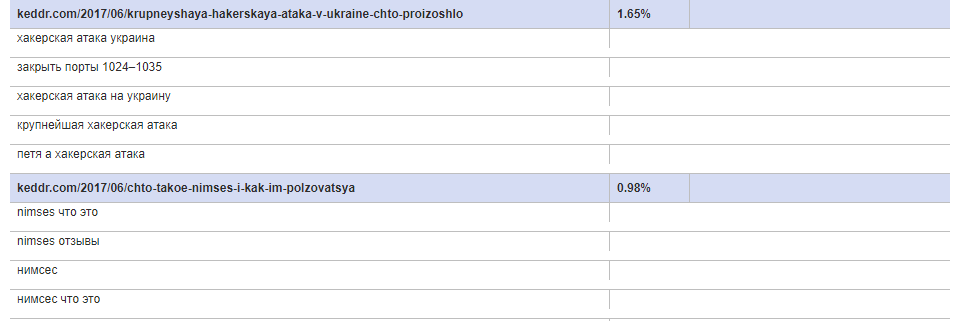

- Домен — сюда вбиваем домен без http://, https://, слэшей и т.д.

- Поисковая система — указываем с какой базой Serpstat будем работать. Перечень значений тут.

- API token — ключ доступа к API Serpstat. Находится он на странице профиля.

Ссылка на источник: http://mz.kiev.ua/tools/8p2017/8p2017-scripts.rar

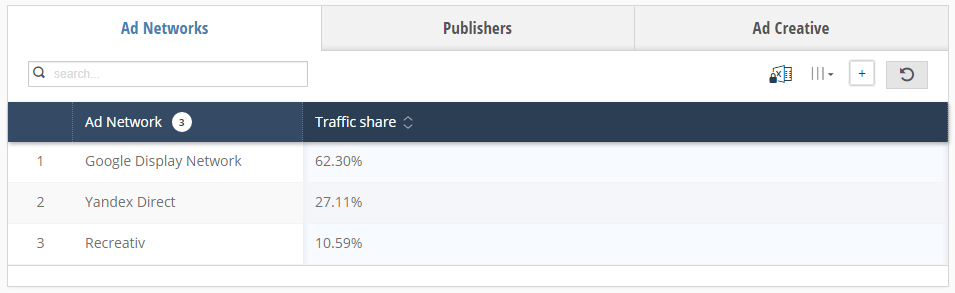

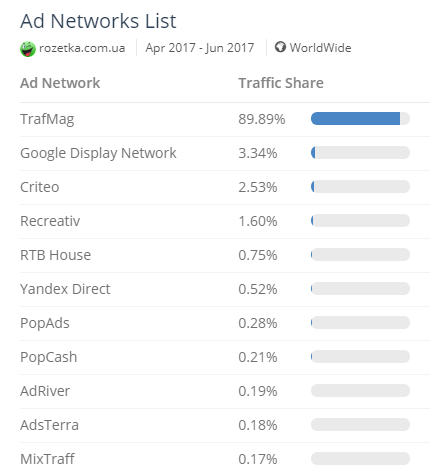

Как определять рекламные сети, с которыми стоит поработать

Польза от результата:

1. Знание рекламных сетей, где представлены конкуренты.

2. Знание рекламных сетей, где конкуренты не рекламируются.

Кроме того, так можем найти сети, в которых не представлены даже конкуренты. Соответственно, конкуренция в рамках нашей аудитории там ниже и мы можем попробовать заработать больше.

А вот насчёт того, как узнать, где они не рекламируются: просто берем какого-то из лидеров (например, интернет-магазин, у которого большие бюджеты и он предположительно может работать со всеми сетями).

Затем смотрим перечень сетей, где он представлен, сравниваем с тем, что мы получили прежде с конкурентами и работаем.

И там есть отчет для рекламных сетей Ad Networks List, где нет ограничения в бесплатной версии на проверку сайтов. Может быть, это когда-нибудь прикроют, но пока можете пользоваться.

Определяем страницы, которые сейчас «шерят» в социальных сетях

Каждый раз, когда я это начинаю, нахожу много разной информации и пытаюсь с ней работать, голова начинает пухнуть :)

Очень сложно найти что-то адекватное из социальных сетей, кроме количества социальных сигналов.

В итоге я начал использовать методику — анализ страниц, которые сейчас «шерят».

Польза от результата:

1. Возможность выделить контент, который в данный момент в тренде аудитории конкурента.

2. Косвенная возможность определить соц. трафик конкретных страниц. Считаем, что один соц. сигнал дает охват в 3 пользователя.

В штатах есть куча исследований, связанных с охватом аудитории от одного шера или лайка, которые сводятся примерно к числу 3-5. То есть от трех до 5 посетителей могут перейти на сайт или ознакомиться с шером одного из друзей.

Есть две методики получения этих данных:

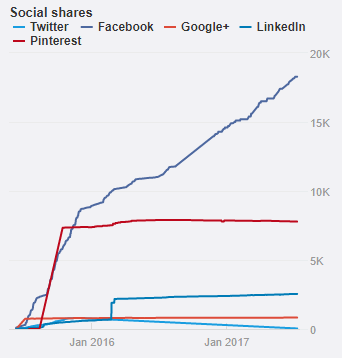

1. Ahrefs:

2) Вбиваем сайт.

3) Для каждой страницы можно посмотреть динамику соц.сигналов.

Нажимаем на Details и видим графики по изменению социальных откликов на каждую страницу.

Недостаток:

Ahrefs хорош тем, что здесь можно посмотреть исторические данные по количеству шеров и лайков с разных социальных сетей. Но очень сложно выделить страницы, которые собирают больше всего шеров именно сейчас.

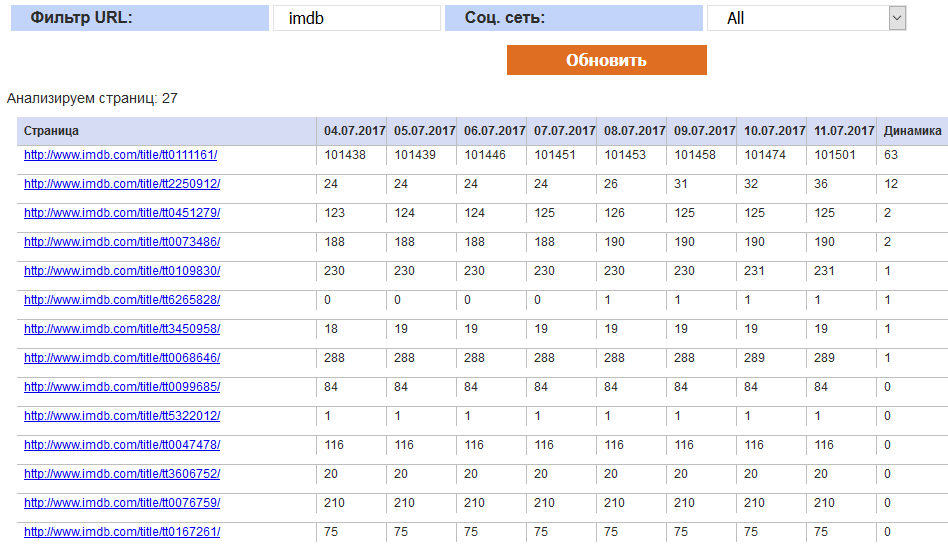

2. Регулярный сбор данных о количестве соц. сигналов на все страницы

1) Собираем все возможные страницы конкурентов.

2) Через API социальных сетей получаем данные о количестве соц. сигналов из каждой системы.

3) Ежедневно, или чаще, обновляем количество соц. сигналов для каждой страницы.

4) Делаем выборки по динамике за несколько дней, которые нам интересны.

Недостаток: Это несложно. Единственное, могут быть проблемы получения всех страниц сайта:

1) Когда у нас больше миллиона страниц сложнее доставать эти данные оперативно.

2) Получить весь перечень страниц конкурентов довольно сложно, особенно если они добавляют по 100-1000 страниц каждый день. Для этого нужно знать, где у них лежит сайт Sitemap. Но эту проблему можно решить.

Результат можно фильтровать по части url и социальной сети. Для каждого адреса смотрите динамику соц. откликов.

Если вам нужен сервис, чтобы установить его у себя, напишите мне, я дам исходники и инструкции по базе данных, как это все налаживать.

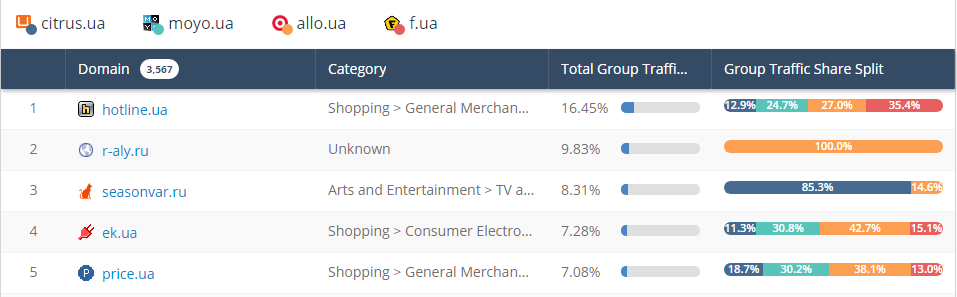

Как сравнивать реферальный трафик с общих источников

Польза от результата:

1. Возможность определить, с каких сайтов конкуренты получают больше трафика, чем ваш проект.

2. Возможность определить, с каких сайтов конкуренты получают трафик, а ваш проект — нет.

Здесь поможет все тот же Similarweb.

Реализация №1:

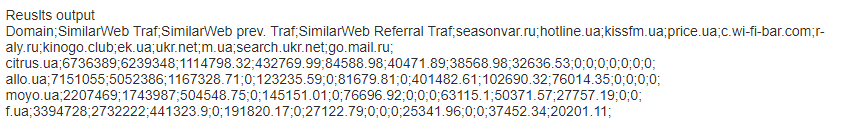

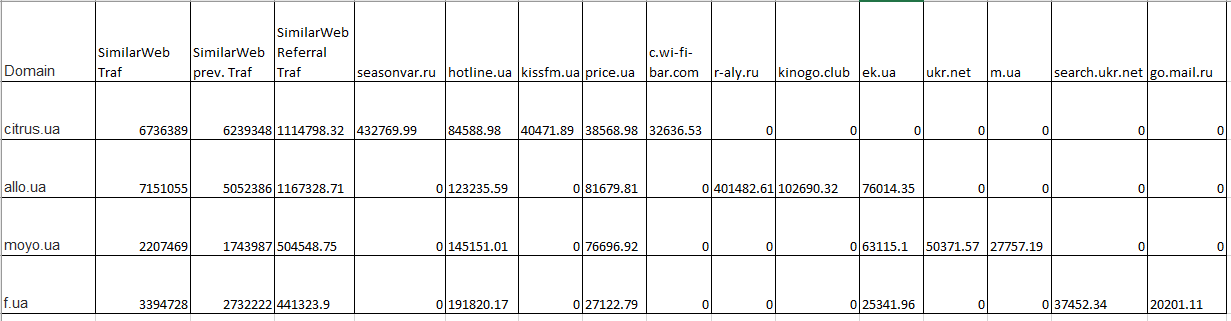

Результаты выглядят примерно так:

Реализация №2:

Результат будет в формате «как csv», где значения через точку с запятой.

Копируем данные в Excel / Google Sheets и разбиваем по столбцам через точку с запятую и получаем удобную таблицу для анализа.

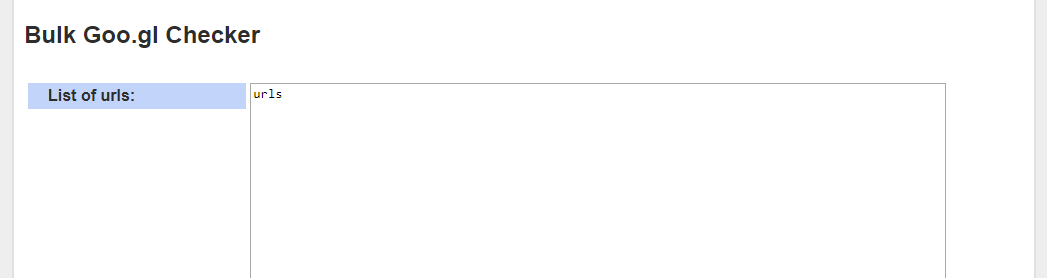

Как палить трафик через сокращалки

В случае Google можно смотреть не только динамику переходов на какую именно страницу ведет. Здесь также показывается много технической информации, связанной с типом устройства, с географией, даже с какого сайта был переход.

В случае bit.ly вы получаете динамику переходов, которая зачастую открыта.

Вопрос в том, как анализировать эти данные? Как находить такие адреса?

1. Через бэклинки

- Берем любой сервис анализа обратных ссылок. Смотрим ссылающиеся домены на конкурентов.

- Выделяем сокращалки (например,goo.gl) и смотрим все страницы, которые ссылаются). Иногда такие сервисы связывают ссылки за счет редиректа и показывают, что ваша страница — это и есть та сокращалка.

- Анализируем статистику.

2. Анализируем выдачу

Просто гуглим по фразе «intext:»домен сокращалки» ключевое слово нашей ниши».

И находим сайты, в тексте которых встречаются эти ссылки.

Например, по запросу «intext:"goo.gl" g-shock» можно найти редирект goo.gl/mnr8rk.

Если они в топе в рамках вашей ниши, то проанализировав их, вы можете приблизительно понять, какой объем трафика приводит на Amazon и стоит ли вам работать с этой нишей или нет.

Для каждого редиректа выводится, куда он ведет и сколько было переходов за 30 дней и все время.

Ссылка на исходник: http://mz.kiev.ua/tools/8p2017/8p2017-scripts.rar

Пользуйтесь!

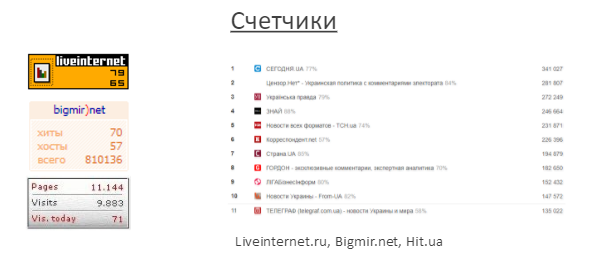

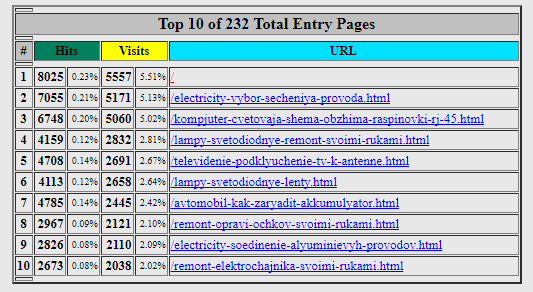

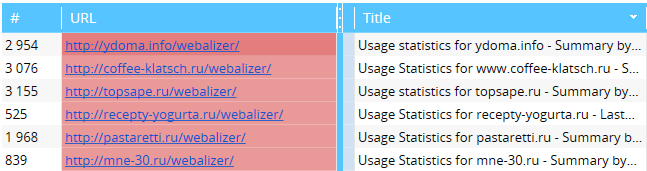

Находим сайты с открытыми логами

WebAlizer

Чаще всего она находится по четырем адресам:

- {домен}/stats/

- {домен}/webalizer/

- {домен}/accesslog/webalizer/usage/

- {домен}/webalizer/usage/

Несмотря на передовой дизайн 1995 года, это очень полезная система ;)

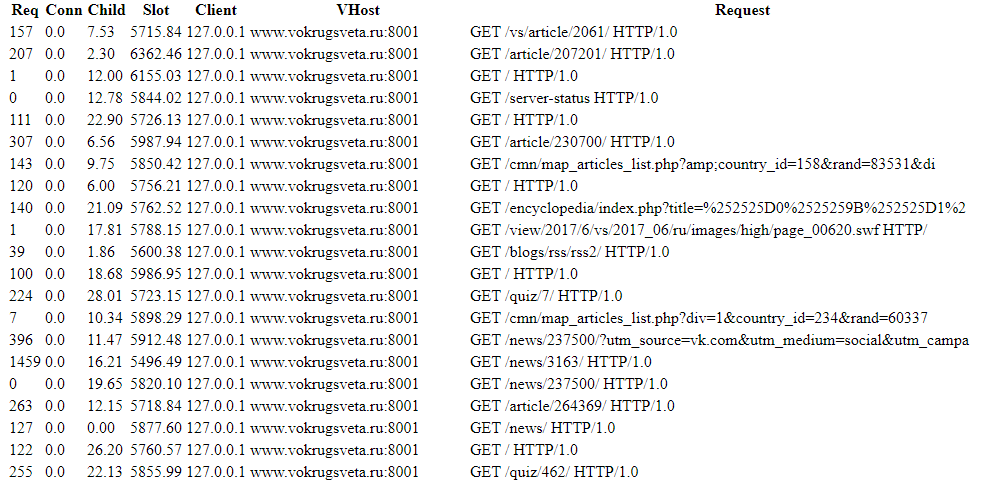

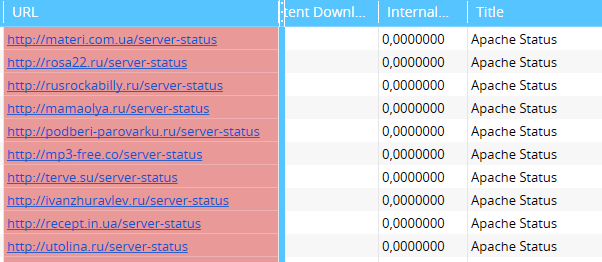

Apache Status

Она находится по адресу {домен}/server-status

Примеры:

http://index.minfin.com.ua/server-status

http://domik.ua/server-status/

https://www.diva.by/server-status/

Это Linux, тут только числа и пробелы, без какого-то дизайна.

Как получать эти данные?

- парсим топы из нашей ниши,

- выделяем уникальные ниши и работаем с ними.

Обновили через 2 секунды, получили данные, которые актуальны через две секунды. И чтобы получать логи, лучше конечно же написать какой-то скрипт, парсить эти данные каждые несколько секунд, куда-то сохранять и, таким образом, вы создаете эдакую копию логов конкурента.

Так как этой штукой пользуются продвинутые сайты, у которых большая нагрузка и большая посещаемость — скажем так, большие игроки у которых невнимательные сисадмины. Поэтому лучше получать о них данные.

Вот и все!

Serpstat — набор инструментов для поискового маркетинга!

Находите ключевые фразы и площадки для обратных ссылок, анализируйте SEO-стратегии конкурентов, ежедневно отслеживайте позиции в выдаче, исправляйте SEO-ошибки и управляйте SEO-командами.

Набор инструментов для экономии времени на выполнение SEO-задач.

Используйте лучшие SEO инструменты

Парсинг выдачи

Парсинг выдачи Google: получите быстро все интересующие вас данные

Проверка обратных ссылок

Быстрая проверка обратных ссылок вашего сайта и конкурентов

Пакетный анализ ключевых слов

Ускорьте процесс работы с запросами используя пакетный анализ ключевых запросов

Проверка частотности

Быстро в удобном виде получите статистику частоты ключевых слов

Кейсы, лайфхаки, исследования и полезные статьи

Не успеваешь следить за новостями? Не беда! Наш любимый редактор подберет материалы, которые точно помогут в работе. Только полезные статьи, реальные кейсы и новости Serpstat раз в неделю. Присоединяйся к уютному комьюнити :)

Нажимая кнопку, ты соглашаешься с нашей политикой конфиденциальности.