Начните искать ключевые слова

Используйте Serpstat, чтобы находить лучшие ключи

Как перестать платить за мусор в ссылочном индексе?

Главное, что показало исследование: объем ссылочного индекса и количество данных в нем никак не связаны с качеством данных и их применимостью.

Чем больше индекс — тем больше требуется ресурсов на поддержание данных в нем в актуальном состоянии. Дубликаты и устаревшие данные весомо искажают общие показатели, и проводить сравнение инструментов на основании этих показателей оказывается бессмысленно.

Чем отличаются ссылочные индексы разных платформ?

Ссылочный индекс Ahrefs построен так:

- live — «живые» ссылки, которые были обнаружены в момент последней проверки роботом и остаются такими до следующего краулинга;

- recent — субиндекс содержит данные об активных ссылках, а также потерянных, которые были в «live» статусе последних 3-4 месяца. Важно понимать, что в этот список могут попадать ссылки, которые робот посчитал потерянными в силу технических причин.

- historical — все исторические ссылки домена, которым краулер присвоил статус «live», начиная с 2016 года (с момента запуска индекса Ahrefs). Т.е. все ссылки, которые находил робот за все время краула интернета с 2016 года, и актуальные, и уже не существующие.

MOZ отображает «fresh» данные, полученные при последнем краулинге. При этом данные обновляются не по всем ссылкам регулярно, приоритет у более качественных страниц, которые сервис определяет с помощью машинного обучения.

Индекс Majestic состоит из таких частей:

- fresh index — все ссылки, которые считались активными при последней проверке за период от 90 до 120 дней.

- historical index — кроме данных fresh-индекса содержит все ссылки, которые когда-либо были замечены по анализируемому домену.

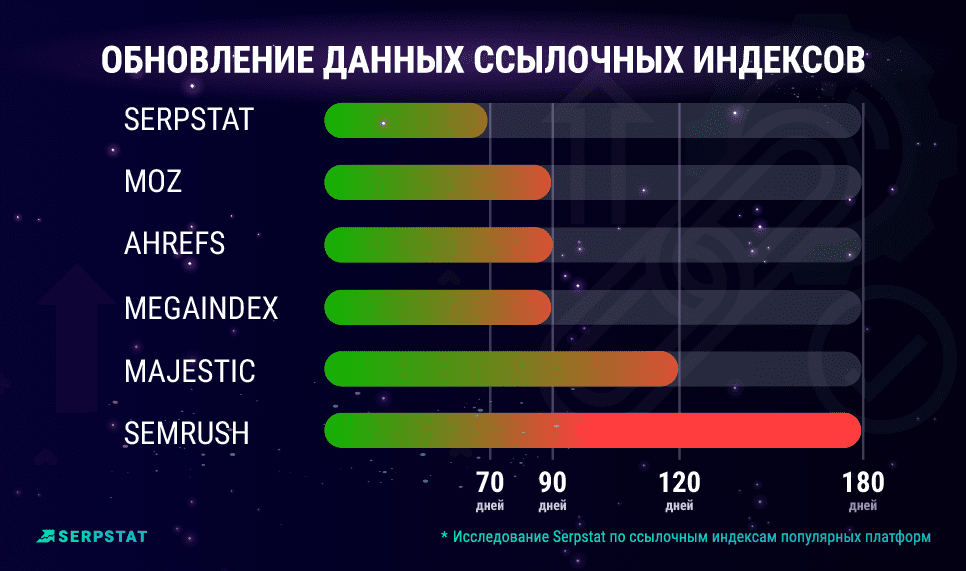

В индексе Serpstat содержатся ссылки только категории fresh — активные в течение последних 70 дней. Такая архитектура позволяет полностью обновлять данные за этот период. Если активная ссылка при проверке не обнаруживается, информация о ней хранится еще 6 месяцев в разделе Потерянные ссылки. Поэтому пользователи получают только актуальную картину ссылочного профиля конкурента или своего сайта. Как Serpstat строил индекс подробно рассказал Олег Саламаха.

Среди главных недостатков подобных программ, можно назвать медленную работу по сравнению с «облачными сервисами», отсутствие «кроссплатформенности», необходимость предварительной установки самого софта и обновлений для дополнительных «фич». Говоря о достоинствах, можно заметить, что такие программы позволяют удобнее работать с фильтрами и сортировками, все данные постепенно скачиваются из базы, с ними можно работать локально.

Доступность ссылочного индекса в Link Assistant и Spy glass зависит от версии, в бесплатной можно проверить до 1,100 ссылок с одного вебсайта.

Архитектура SEO PowerSuite, в отличие от, к примеру, от Semrush анонсирует учет удаленных ссылок и не показывает их вместе с активными, что влияет и на количественные показатели.

В процессе работы с сервисом, было замечено, что актуальность данных у LinkAssistant сильно уступает конкурентам лидерам в нише: в индексе есть ссылки, которые не обновлялись с 2018 года.

В исследовании мы рассмотрим несколько параметров для количественной и качественной оценки индексов:

- объем ссылочного индекса

- частота и скорость обновления

- индекс покрытия

- уникальность данных по ссылкам.

#мнение_экспертов

И будем ориентироваться только на ссылочные метрики, то мы обращаем внимание в первую очередь на метрики качества общей ссылочной массы, в зависимости от сервиса которым вы пользуйтесь к ним будет относиться:

- Domain Rank (DR);

- AS (Authority Score);

- Citation Flow (CF) и Trust Flow (TF).

- общее количество уникальных доменов;

- общее количество внешних ссылок;

- количество IP адресов и подсетей;

- количество уникальных исходящих ссылок с домена;

- SEO/ORG распределение ссылок.

- Динамика ссылок.

- В каком разделе размещается ссылка. Важно, чтобы она не была в каталоге, где только покупные ссылки (проверяем руками).

- DR (Ahrefs API).

- Кол-во ссылающихся доменов и страниц (Serpstat API).

- Кол-во исходящих доменов и страниц (Serpstat API).

- Кол-во ключевых слов, по которым ранжируется сайт (Serpstat API).

- Изменение кол-ва ключевых слов за последние 6 месяцев (Serpstat API).

- Тематичность (проверяем руками).

- Трафик страницы, с которой идет ссылка в нужном мне регионе.

- Количество ключевых слов в топ-100 в этом регионе.

- Тип ссылки (не просто Dofollow/Nofollow — Спонсор, UGC, ссылка в комментарии, подвале (сквозная). Я уверен, если помозговать, можно выловить еще множество типов — ссылка-картинка, анкор, безанкор, бессмысленный анкор (тут здесь и там).

- Тип страницы (по микроразметке например или каталогизация типов страниц и доменов. Например, Govermental, Educational, Catalog, Forum, Review, Blog).

- Количество других исходящих ссылок на этой странице.

- Дата публикации страницы и дата первого обнаружения.

- Тематика домена.

- Title ссылки.

- Title домена (неплохо бы помогло отсеивать ненужные домены).

- Длина контента на данной странице.

- Есть ли данный домен в базах бирж ссылок. Вы сами понимаете, как было бы полезно выловить таких.

Те данные, которые выловить не удается, вытаскиваем самостоятельно, что конечно напрягает — ведь приходится снимать данные в разных таблицах и сводить…

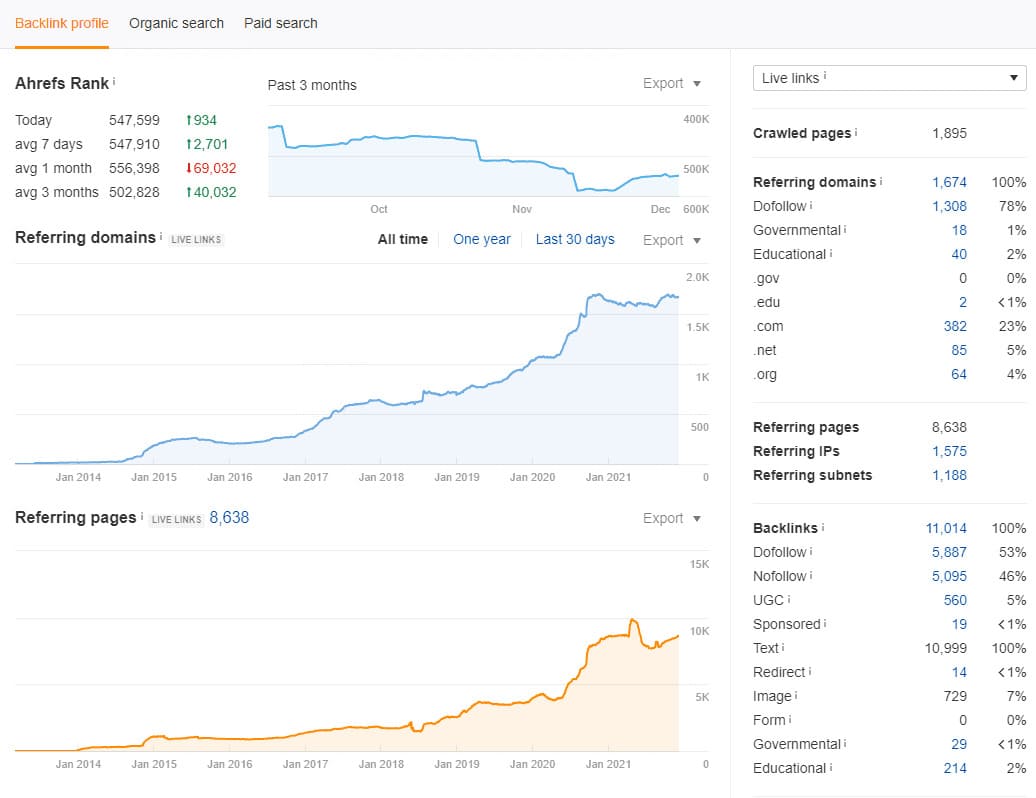

- ссылающиеся домены;

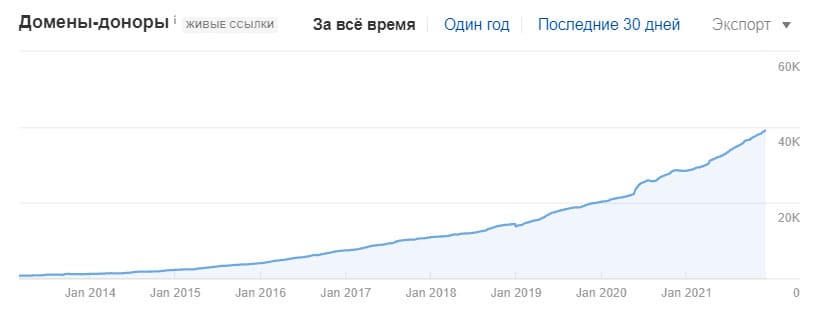

- динамика ссылочной массы (домены);

- ссылающиеся ip-подсети;

- количество dofollow-ссылок;

- распределение dofollow/nofollow/redirect;

- анкор-лист (популярные слова в анкорах).

- Пузомерки DR и UR

- количество ссылающихся доменов, беклинков, акцепторов

- соотношение follow/nofollow

- соотношение анкорных/безанкорных ссылок, а также брендовых анкоров.

- наличие .gov, .edu доменов

- объем трафика и ключевых слов и т.д.

Большая база — преимущество или недостаток?

- дубликаты ссылок с http и https - при условии, что одна из версий недоступна на момент проверки.

- дубликаты ссылок с сессионными параметрами и параметрами аналитических систем (например, GA).

- дубликаты ссылок в связках «Источник»+«Целевой URL»+«Анкор».

- дубликаты данных с разными датами обнаружения (возможно, причина в том, что были уже записаны в БД новые данные, но еще не почищены старые).

- построение детальных отчетов данных на основе, в том числе, и уже удаленных ссылок, из-за чего отчеты становятся некорректны.

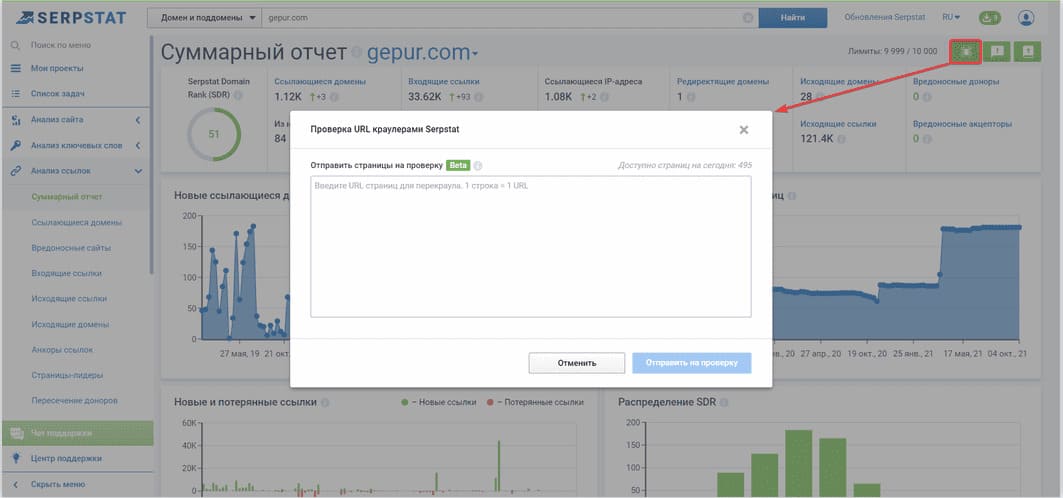

Воспользуйтесь перекраулом ссылок. Отправьте список страниц, на которых размещены новые ссылки и робот Serpstat соберет по ним данные в течение 24 часов.

Крупный индекс может содержать много дубликатов и устаревшей, мусорной информации. Поэтому важен, в первую очередь, не объем, а корректность и актуальность данных.

#мнение_экспертов

Было бы идеально, сделать какой-то фильтр, чтобы посмотреть только ссылающиеся страницы, которые есть в индексе Google.

Также внутри ссылочного индекса нужен функционал поиска дублей ссылок, отсева мусорных ссылок с сервисов анализов сайта и прочего (в Serpstat это реализовано автоматически). Иначе приходится анализировать огромные таблицы данных, где полезных доноров искать приходится долго. Часто ты в итоге выкачиваешь 100000 строк, а реальных интересных ссылок там менее трех сотен.

Имеет значение как размер базы, так и ее актуальность и уникальность. Важно все. Чем больше ссылочный индекс, чем более актуальные и уникальные данные, тем более точно можно проанализировать и сформировать ссылочную стратегию.

Частота обновлений данных

#мнение_экспертов

Я бы предложил сервисам смотреть больше в сторону интеграций с личным кабинетом Google Search Console, чтобы получать данные оттуда и использовать их при маркировке доноров. А те ссылки, которые не имеют разметки, помечать иначе, это был бы важный сигнал при работе со ссылками и при накоплении большой статистики, было бы интересно анализировать эти параметры.

Есть прямая корреляция между количеством ссылок и позициями, но тут дьявол кроется в деталях. Чистый ссылочный профиль в белом SEO важнее гораздо количественных метрик – с этим я столкнулся в 2016-2017 и после этого. Мы часто ссылки делаем по методу аутрич, и нам не всегда сообщают, что их разместили и не присылают их по почте. Поэтому приходится искать их вручную, ведь ссылочный индекс всегда приходит с запозданием.

Полнота данных по ссылкам

Поскольку подсчитать реальное количество ссылок чисто технически невозможно, воспользуемся количеством ссылок по Google Search Console* как независимого источника данных, чтобы получить представление об их полноте.

*Google Search Console также не отображает все данные о ссылках и актуализирует их с задержкой.

Нужно отметить, что Google Search Console - это не эталон, с которым стоит сравнивать все сервисы, рассчитывая на наиболее точные данные. В выгрузках из GSC тоже зачастую присутствуют дубликаты и неактуальные ссылки. Наше исследование иллюстрирует то, насколько сильно могут разниться данные, а если вы самостоятельно наращиваете ссылочную массу и документируете все новые ссылки, вы сможете провести свой анализ.

Для поиска примеров мы обратились к нашим читателям запросили данные по Google Search Console и сравнили данные с тем, что обнаруживают платформы.

Таким образом сложилось понимание, что для того, чтобы покрыть 80+% ссылочных данных приходится собирать данные со всех доступных инструментов.

Уникальность ссылочных данных

Доля уникальных ссылающихся доменов — параметр, показывающий % доноров, которых нет в аналогичных отчетах платформ конкурентов.

Для такого анализа выбрали случайным образом 10 доменов в разных нишах: от гейминга до YMYL, но мы старались сделать подборку разнообразной в плане географии, ниш и трафика.

Список доменов, которые исследовали:

- brightlocal.com (США) — онлайн маркетинг

- worldofwarcraft.com (США) — гейминг

- namepros.com (США) — вебхостинг

- subaru.com (США) — автомобильная промышленность

- ourplanet.com (США) — охрана окружающей среды, правительственные организации

- ispringsolutions.com (США) — IT, программирование

- roccat.org (США) — видеоигры и консоли

- 11bitstudios.com (Польша) — гейм дизайн

- aeg.com (Украина) — техника

- ppmco.org (США) — правительственная организация по здравоохранению.

По каждому домену получили данные о количестве:

- ссылающихся сайтов-доноров по Serpstat

- ссылающихся сайтов-доноров по конкурентному сервису

- общих доноров Serpstat и конкурента

- уникальных доменов-доноров Serpstat.

Эти значения могут зависеть от множества факторов, так как принцип их расчета порой схож с Page Rank (как у Serpstat), а иногда, содержит в себе внутренние метрики сервиса. К примеру, Link Assistant учитывает индекс токсичных ссылок, сервис акцентирует внимание на том, что он схож с алгоритмом Google для поиска сайтов с риском пенальти.

Позицию Google касательно подобных метрик не раз демонстрировал Джон Мюллер:

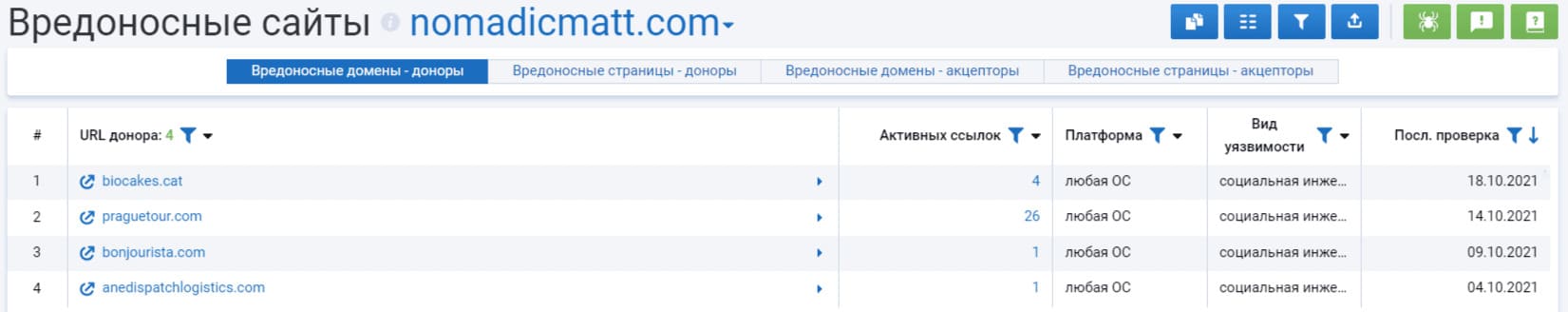

Стоит вспомнить о том, что низкий показатель авторитетности не является призывом к действию, а вот присутствующие вредоносные ссылки - лучше убрать. С недавнего времени, Serpstat собирает данные о вредоносных донорах совместно с Bundestag Security Institute, это немецкий институт информационной безопасности, следящий за сайтами, которые участвовали в нарушениях закона. Возле таких доменов, можно увидеть метку BSI.

#мнение_экспертов

Пока ни один инструмент не дает четких параметров, которые нужны для отсева, поэтому приходится сортировать домены и проверять их уже отдельно.

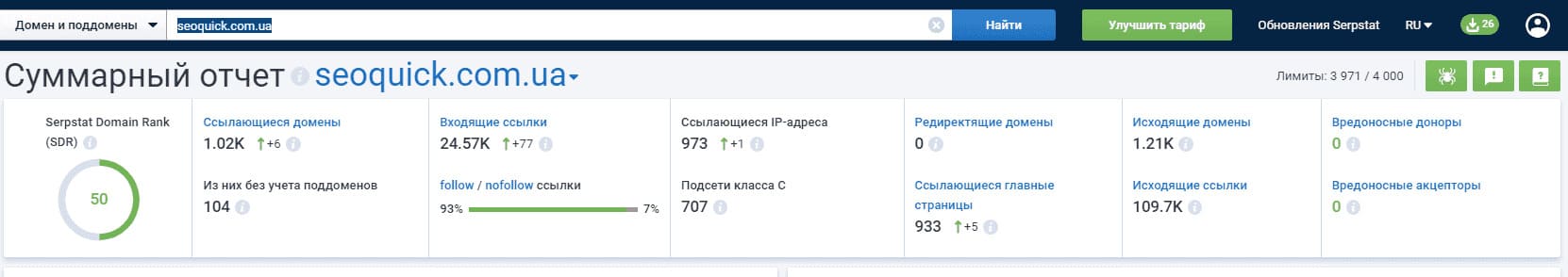

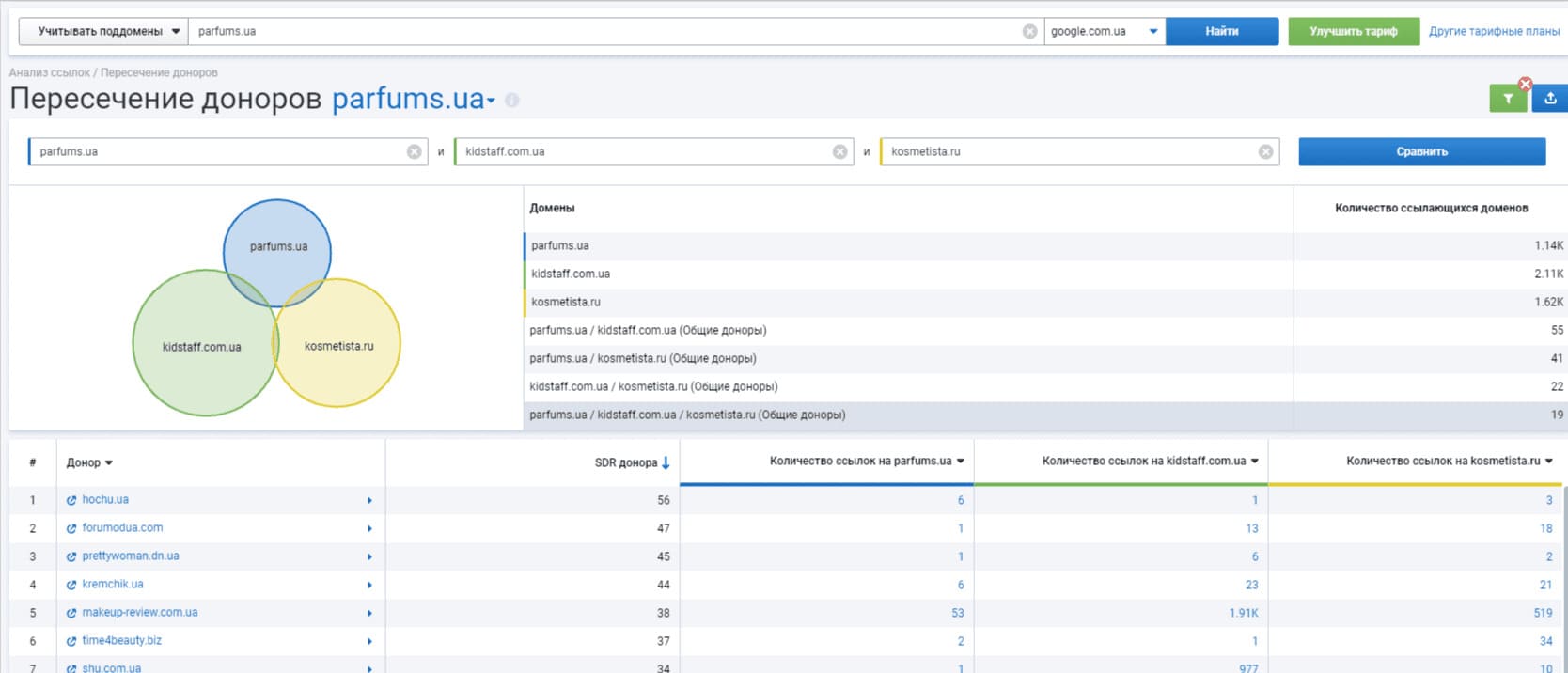

Но мне очень нравится инструмент сравнения доменов – у Serpstat он реализован удобнее, чем у аналогичных сервисов, и его данные достойны изучения. Например, на этом скрине сайт нашего клиента.

Тем не менее нужно больше интеграций с вебмастером для своевременного поиска собственных ссылок и конечно же иметь отличные методы сортировки ссылочных баз (об этом говорил в вопросе размера базы) – от их истории до актуального состояния (у Serpstat это уже есть). А для сортировки мне как раз не хватает ряда метрик, которых пока нет ни у кого и приходится изучать ссылки руками.

Николай Шмичков, SEOquick

Какие сервисы используем зависит от региона ресурса. В разных сервисах база беклинков будет отличаться между собой, поэтому, чтобы качественно проанализировать ссылочный профиль, собираем базы из нескольких сервисов.

Почему стоит попробовать Serpstat для ссылочного анализа

Так как ссылочный фактор ранжирования — один из ведущих в SEO, необходимо уделять тщательное внимание не только анализу ссылок, но и качеству анализируемых данных.

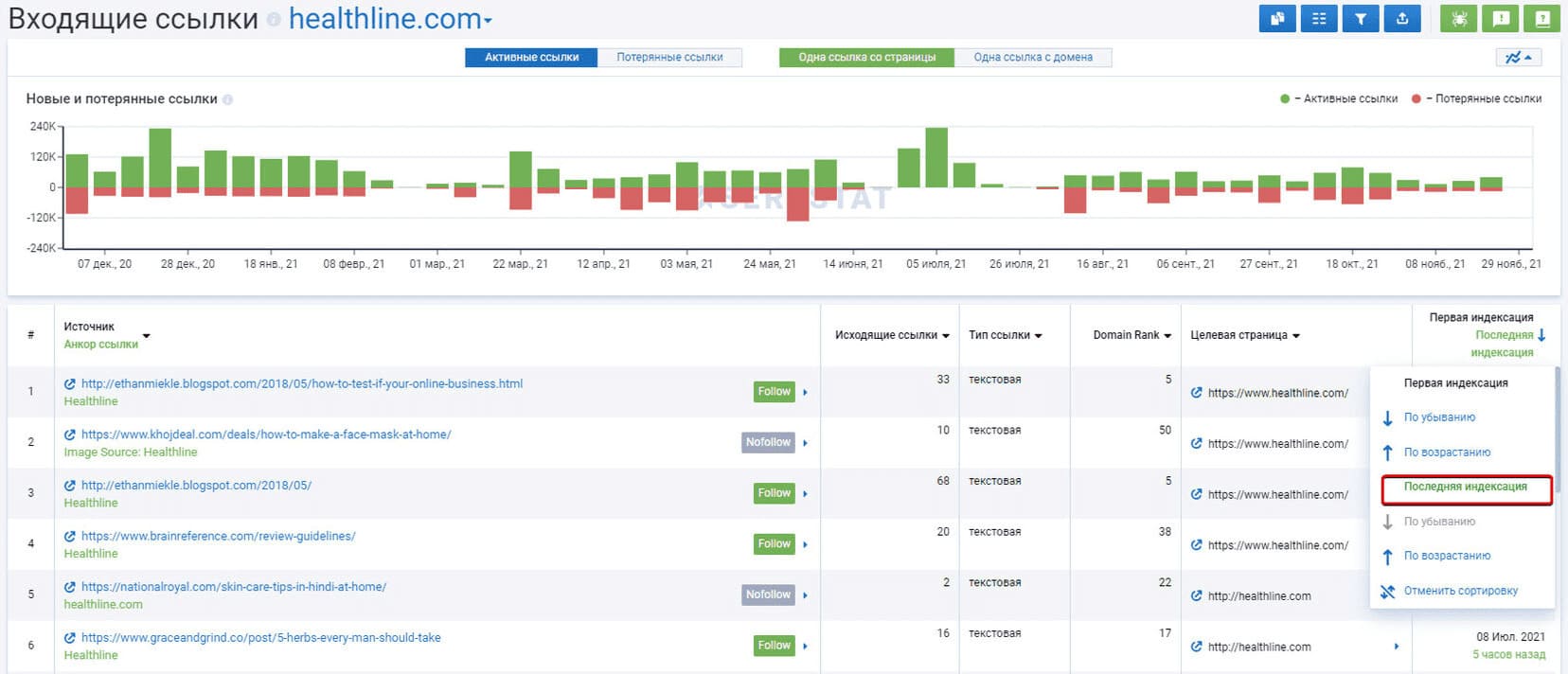

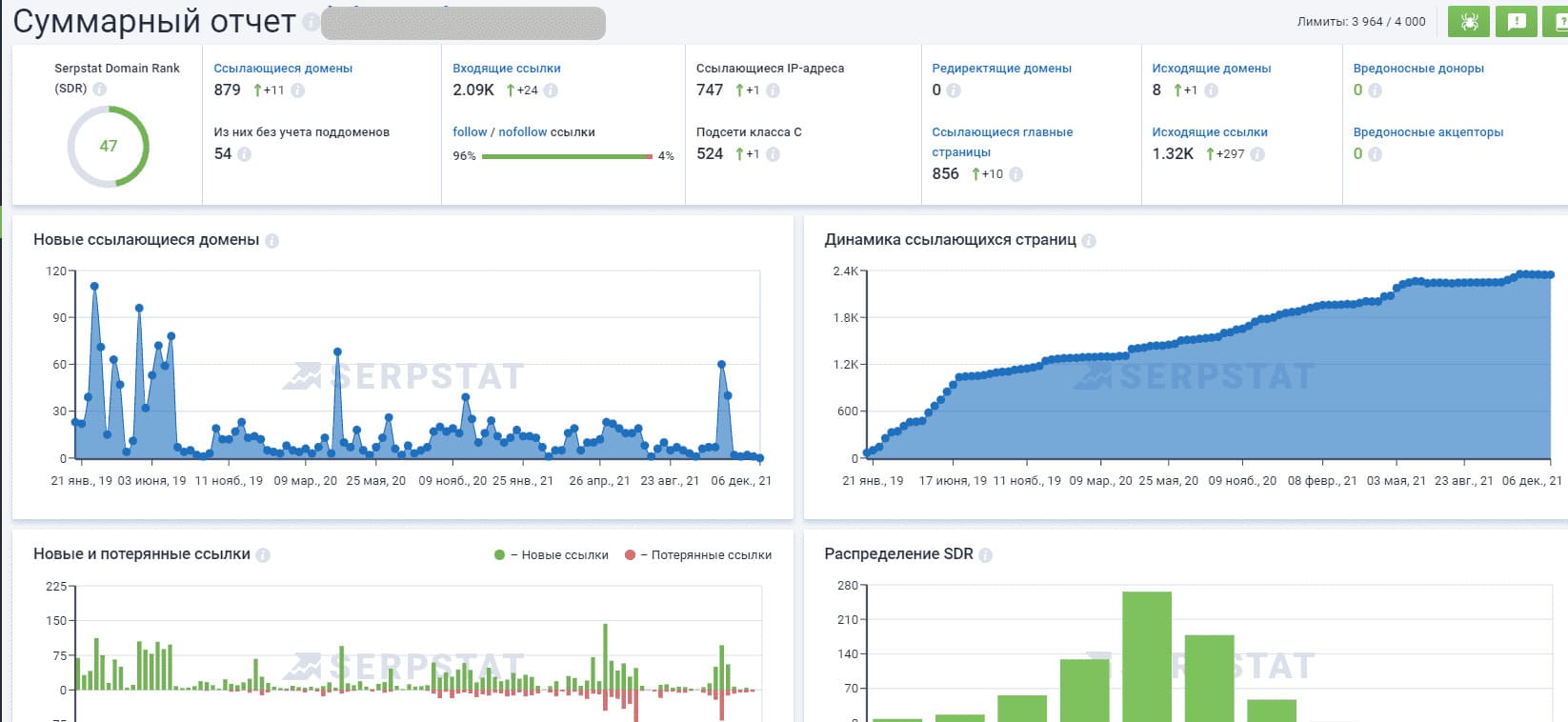

Изучаю динамику роста ссылочной массы. Желательно, чтобы она увеличивалась постепенно и постоянно, без резких изменений в плюс или минус. Вот пример хорошего роста:

Михаил Шакин, Shakin blog

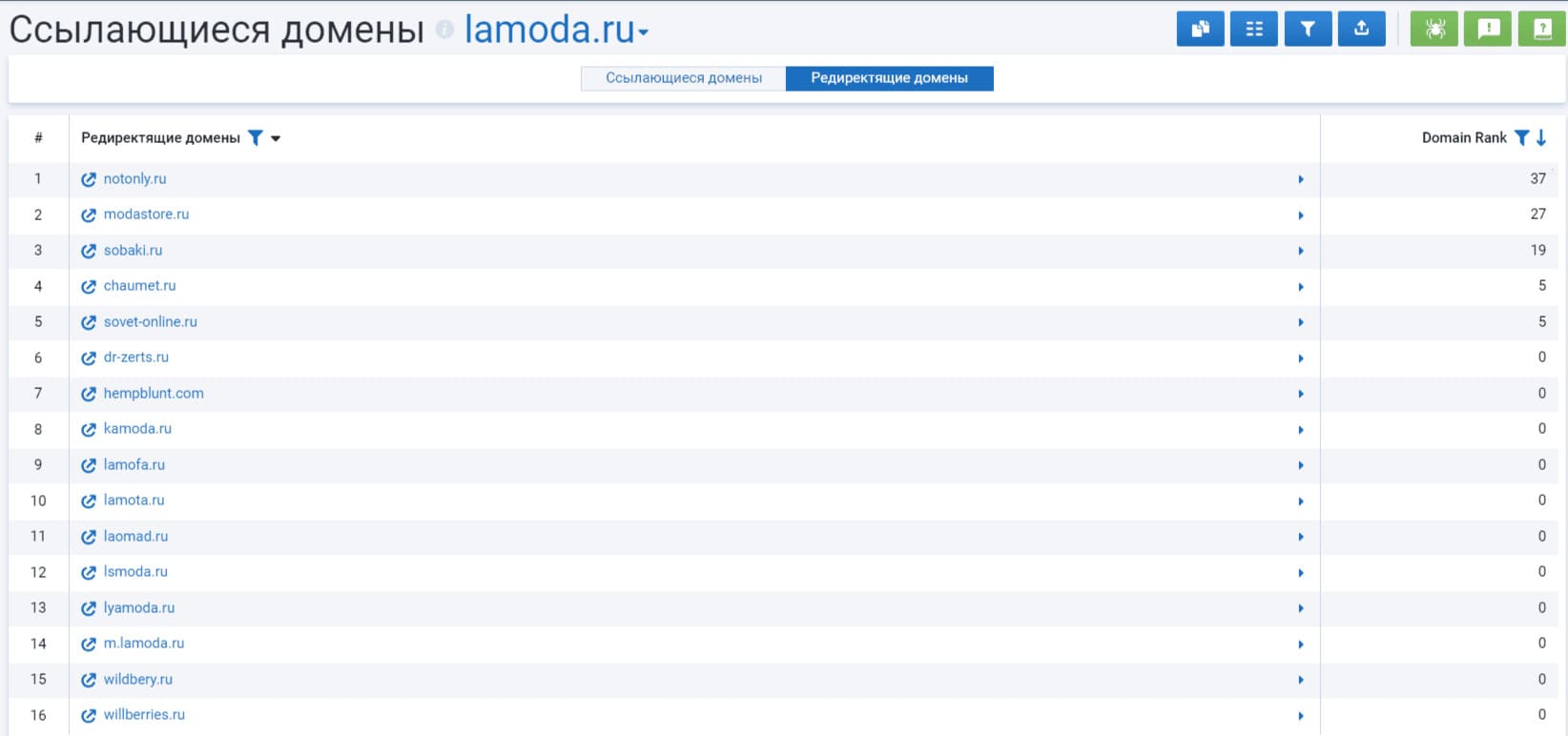

Serpstat делает упор на качество данных индекса. А, кроме привычных отчетов ссылочного анализа, таких как:

- Ссылающиеся домены

- Входящие ссылки

- Исходящие ссылки

- Исходящие домены

- Анкоры ссылок

- Страницы-лидеры

Сервис располагает рядом уникальных фич для линкбилдинга — пересечение доноров, редиректящие домены, вредоносные домены и перекраул ссылок.

Инструмент, будет полезен, если вы закупили ссылки и хотите тут же проследить их влияние на SDR, чтобы при необходимости снять их и избежать негативных последствий. Или ваш клиент требует актуальную информацию «на сегодня», а новые ссылки еще не отобразились в отчете.

Например, вы хотите найти качественные и релевантные площадки для размещения ссылок. Ранее вам пришлось бы анализировать каждого конкурента по отдельности и вручную искать общие площадки в отчетах. Сейчас же достаточно найти нескольких крупных конкурентов, ввести их домены в инструменте и автоматически найти тех доноров, которые ссылаются на них всех одновременно.

- Serpstat считает только уникальные ссылки: если есть на одной странице несколько ссылок, у которых одинаковые целевая страница и анкор, в нашем индексе будет указана одна ссылка.

- Детальные отчеты Serpstat строятся на основе данных по активным ссылкам: ссылки, которые не были обнаружены при проверке, попадают в отдельные отчеты. В отчетах анализируемых сервисов для того, чтобы получить эти сводки, нужно задействовать дополнительные фильтры, по умолчанию — данные отдают все вместе.

- Мы показываем в Суммарном отчете данные по актуальным ссылкам, а не суммарные данные с учетом удаленных ссылок, такая информация содержит мусор.

Заключение

Для всестороннего анализа ссылок, зачастую SEO-специалисты используют преимущества различных платформ и комбинируют данные нескольких сервисов. Одним из таких инструментов в вашем арсенале может стать Serpstat, который, кроме собственного индекса ссылок, имеет также ряд уникальных инструментов для ссылочного анализа.

Ну что ж, рядом инсайдов из мира беклинков мы с вами поделились. Оставляйте комментарии, чтобы обсудить статью и задать дополнительные вопросы по анализу ссылок в Serpstat :)

Serpstat — набор инструментов для поискового маркетинга!

Находите ключевые фразы и площадки для обратных ссылок, анализируйте SEO-стратегии конкурентов, ежедневно отслеживайте позиции в выдаче, исправляйте SEO-ошибки и управляйте SEO-командами.

Набор инструментов для экономии времени на выполнение SEO-задач.

Рекомендуемые статьи

Кейсы, лайфхаки, исследования и полезные статьи

Не успеваешь следить за новостями? Не беда! Наш любимый редактор подберет материалы, которые точно помогут в работе. Только полезные статьи, реальные кейсы и новости Serpstat раз в неделю. Присоединяйся к уютному комьюнити :)

Нажимая кнопку, ты соглашаешься с нашей политикой конфиденциальности.