Почніть шукати ключові слова

Використовуйте Serpstat, щоб знаходити найкращі ключі

Які сторінки потрібно закрити від індексації

ЧЕК — ЛИСТ: ТЕХНІЧНА ЧАСТИНА

Контент сайту має бути інформативним і корисним для користувача, а відповідні сторінки — відкритими для сканування пошуковим роботом. Однак є випадки, коли потрібно закрити сторінку від індексації. Розберемося, коли це доречно.

Причини заборонити індексацію сторінок

Власник сайту зацікавлений, щоб потенційний клієнт знаходив його веб-ресурс у видачі, а пошукова система — в тому, щоб надати користувачеві цінну і релевантну інформацію. Для індексації мають бути відкриті тільки ті сторінки, які має сенс виводити в результати пошуку.

Розглянемо причини, через які слід заборонити індексацію сайту або окремих сторінок:

До такого контенту можна віднести технічні та адміністративні сторінки сайту (кошик, сторінка оплати, результатів пошуку, авторизація тощо), дані з персональною інформацією, набори фільтрів каталогу товару в електронній комерції (множинний вибір фільтрів за ціною, кольором, фактурою тощо).

Краулінговий бюджет — це певна кількість сторінок сайту, яку періодично сканує пошукова система. Для сайтів це значення кількості сторінок не постійне і в тому числі залежить від типу сайту і частоти його оновлення. У наших інтересах витрачати ресурси краулерів на ті сторінки, які становлять цінність і користь як для клієнта, так і для нас (бізнесу). Щоб краулер частіше відвідував і оновлював контент в індексі потрібних нам сторінок, необхідно закрити від сканування ті, які витягають краулінговий бюджет і не приносять користі.

Схема сканування, індексування та ранжування сайту

Хотіли б просто зараз перевірити, які сторінки вашого сайту індексуються і перебувають у топі пошукової видачі?

Або за якими фразами ранжується ваш конкурент? Розпочніть тестовий 7-денний період та відкрийте для себе всі можливості Serpstat!

Які сторінки варто закрити від індексації

Закриття сторінок чи цілого сайту від індексації може бути корисним у декількох випадках:

Якщо проєкт тільки в процесі створення, краще закрити сайт від пошукових систем. Рекомендується відкрити доступ до сканування наповнених і оптимізованих сторінок, відображення яких у результатах пошуку доцільне. Під час розробки сайту на тестовому сервері доступ до нього має бути обмежений за допомогою файлу robots.txt, метатега noindex або пароля, однак пріоритетний варіант — це саме присвоєння метатега <meta name="robots" content="noindex, nofollow" /> до всіх сторінок ресурсу, адже в такому разі індексація сторінки неможлива, на відміну від robots.txt, де директива заборони скоріше рекомендація для краулера, а індексація сторінок однаково можлива. Найчастіше програмісту не складно додати потрібну логіку, щоб вивести додатковий метатег і заборонити індексацію сайту. Для Word Press можна використовувати налаштування плагіну Yoast SEO або іншого з подібною функцією.

Закрити сайт від індексації в robots.txt можна так (перша директива означає звернення до всіх краулерів, друга директива — забороняє сканувати всі URL сайту):

User-agent: *

Disallow: /

Ці два рядки заборонять доступ до сайту всім роботам пошукових систем.

Якщо потрібно при цьому дозволити сканувати конкретні URL, потрібно додати директиву Allow: /namepage$ де /namepage URL сторінки дозволеної до сканування. Директива дозволу сканування домінує над забороною (для конкретного URL), а значок $ скасовує застосування за замовчуванням не виведеного символу "*". Тобто якщо не поставити $ — ми дозволимо сканувати вкладені відносно головного URL, такі як /namepage/indexpage.html і т.д.

Заборона індексації для сайту на сервері NGINX здійснюється за допомогою додавання коду add_header X-Robots-Tag "noindex, nofollow"; у файл .conf.

Налаштовуючи копію сайту, важливо правильно вказати дзеркало за допомогою 301 редиректу або атрибута rel="canonical", щоб зберегти позиції наявного ресурсу і проінформувати пошукову систему: де сайт-першоджерело, а де його аналог. Закривати від індексації робочий ресурс вкрай небажано. Тим самим можна анулювати вік сайту і напрацьовану репутацію.

Сторінки друку можуть бути корисні відвідувачеві. Потрібну інформацію можна видрукувати у вигляді адаптованого тексту: статтю, відомості про товар, карту розташування організації.

По суті, сторінка друку є копією її основної версії. Якщо ця сторінка відкрита для індексації, пошуковий робот може вибрати її пріоритетною і більш релевантною. Для правильної оптимізації сайту з великою кількістю сторінок слід встановити заборону індексації сторінок для друку.

Щоб закрити посилання на документ, можна використовувати виведення контенту за допомогою AJAX, закрити сторінки за допомогою метатегу <meta name="robots" content="noindex, follow"/> , або в роботс закрити від індексації всі сторінки друку.

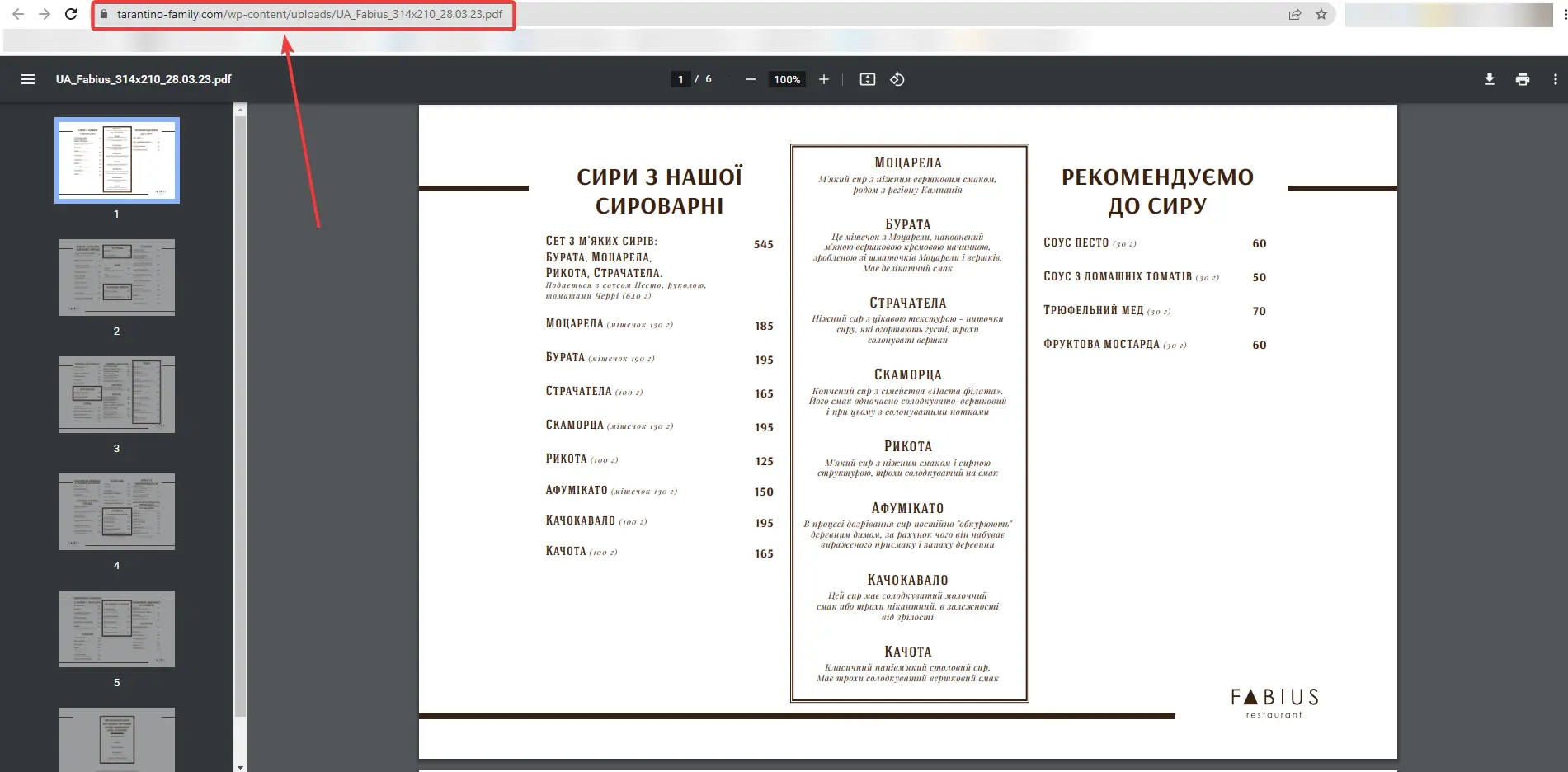

На сайті, крім сторінок з основним контентом, можуть бути документи PDF, DOC, XLS, доступні для читання і завантаження. У результатах пошуку поряд зі сторінками сайту можна побачити заголовки pdf-файлів.

Можливо, вміст цих файлів не відповідає запитам цільової аудиторії сайту. Або ж документи з'являються в пошуку вище html-сторінок сайту. У цьому разі індексація документів небажана, і їх краще закрити від сканування у файлі robots.txt.

Приклад індексації pdf-файлу на сайті

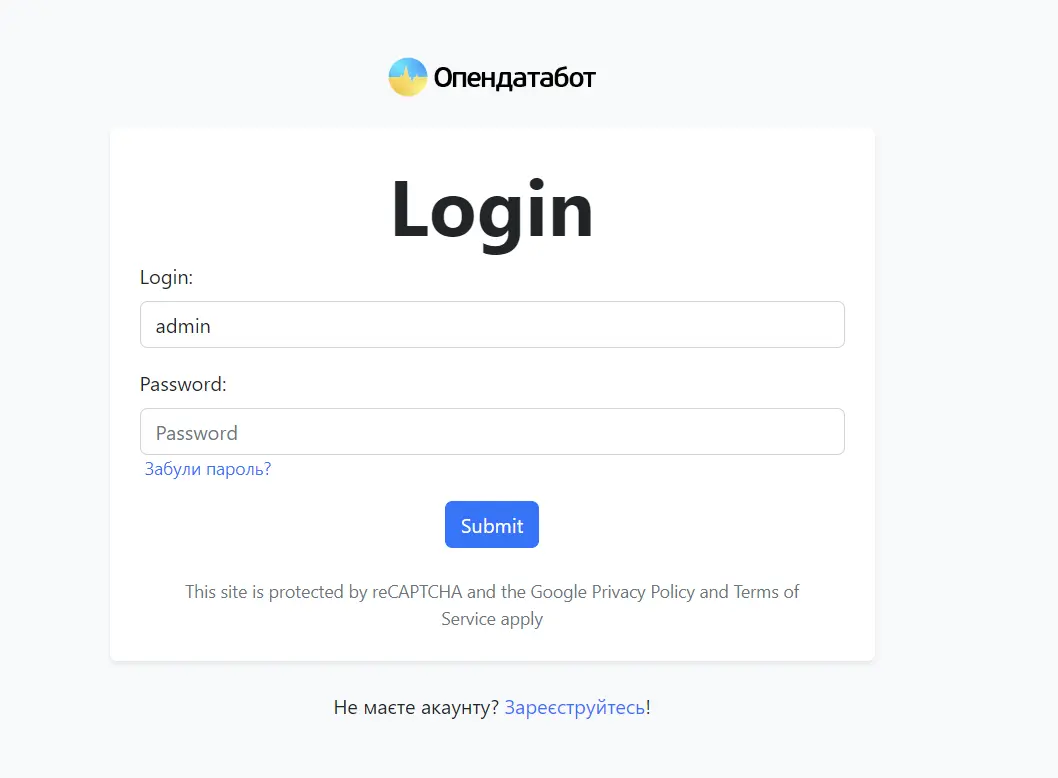

Сюди відносять усі сторінки, що корисні для клієнтів, але не несуть інформаційної цінності для інших користувачів і, як наслідок, пошукових систем. Це можуть бути форми реєстрації та оформлення заявок, кошик, особистий кабінет. Доступ до таких сторінок слід обмежити.

Технічні сторінки потрібні виключно для службового використання адміністратором. Наприклад, форма авторизації для входу в панель керування має закриватись від індексації.

Ці дані можуть містити не тільки ім'я та прізвище зареєстрованого користувача, а й контактні та платіжні дані, залишені під час оформлення замовлення. Ця інформація має бути надійно захищена від перегляду.

Особливості структури таких сторінок роблять їх схожими одна на одну. Щоб знизити ризик санкцій від пошукових систем за дубльований контент, рекомендуємо закривати до них доступ.

Сторінки пагінації

Ці сторінки хоч частково і дублюють зміст основної сторінки, закривати від індексації їх не рекомендується. В таких випадках необхідно налаштувати атрибут rel="canonical", редирект (коли сторінки ідентичні через технічні особливості CMS), або цілеспрямовано їх оптимізувати, в тому числі й під геозалежні запити.

Як закрити сторінки від індексації

Метатег robots зі значенням noindex у html-файлі

Щоб закрити сторінку від індексації, використовуйте атрибут noindex у html-коді сторінки — це сигнал пошуковій системі про те, що її слід виключити з результатів пошуку. Щоб використовувати метатеги, необхідно в заголовок <head> відповідного html-документа додати <meta name="robots" content="noindex, follow"/>.

Це дає змогу повністю закрити сторінку, залишивши роботам можливість переходити за розміщеними на сторінці посиланнями. Просто замініть follow на nofollow:

<meta name="robots" content="noindex, nofollow"/>

У разі використання цих методів сторінка буде закрита для сканування навіть за наявності зовнішніх посилань на неї.

Як закрити сайт від індексації Google

Ви можете також закрити доступ до сайту тільки ботам Google. Додайте цей метатег всередині <head> </head> усіх сторінок ресурсу:

<meta name="googlebot" content="noindex, nofollow"/>

Через robots доступ до сайту ботам Google закривається так:

User-agent: googlebot

Disallow: /

Ще можна заборонити доступ до будь-яких статей сайту роботам Google Новин, тоді вони не з'являться в Google News:

<meta name="Googlebot-News" content="noindex, nofollow">.

Файл robots.txt

У цьому документі можна заблокувати доступ до всіх обраних сторінок або вказати пошуковикам не індексувати сайт.

Обмежити індексацію сторінок через файл robots.txt можна так:

User-agent: * #назва бота пошукової системи

Disallow: /catalog/ #частковий або повний URL сторінки, що закриваєтьсяЩоб використання цього методу було ефективним, слід перевірити, чи немає зовнішніх посилань на розділ сайту, який потрібно приховати, а також змінити всі внутрішні посилання, що ведуть на нього.

Файл конфігурації .htaccess

Використовуючи цей документ можна обмежити доступ до сайту за допомогою пароля. Необхідно вказати Username користувачів, які зможуть потрапити до потрібних сторінок і документів, у файлі паролів .htpasswd. Потім вказати шлях до цього файлу за допомогою спеціального коду у файлі .htaccess.

AuthType Basic

AuthName "Захищена паролем зона"

AuthUserFile шлях до файлу з паролем

Require valid-userВидалення URL через сервіси вебмайстрів

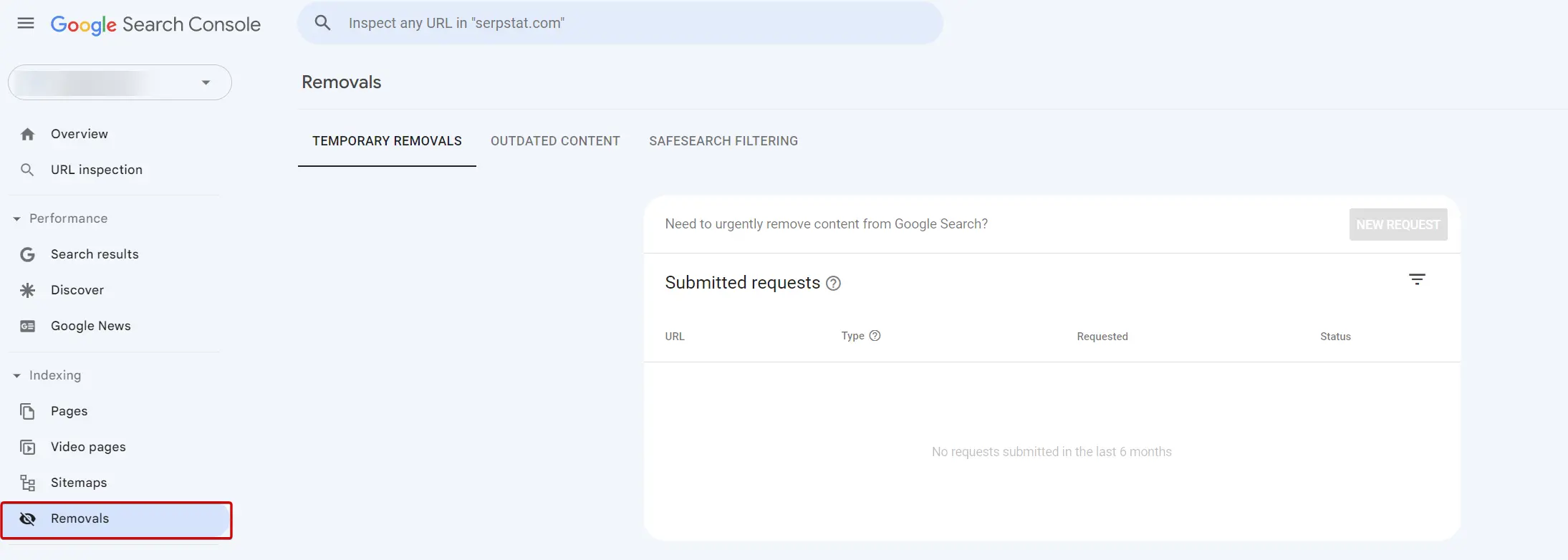

У Google Search Console можна прибрати сторінку з результатів пошуку, вказавши URL у спеціальній формі та позначивши причину її видалення. Функція видалення сторінок доступна в розділі "Індекс Google". Обробка запиту може зайняти деякий час.

Видалення URL-адрес з індексу в Search Console

Як перевірити, скільки сторінок закрито від індексації

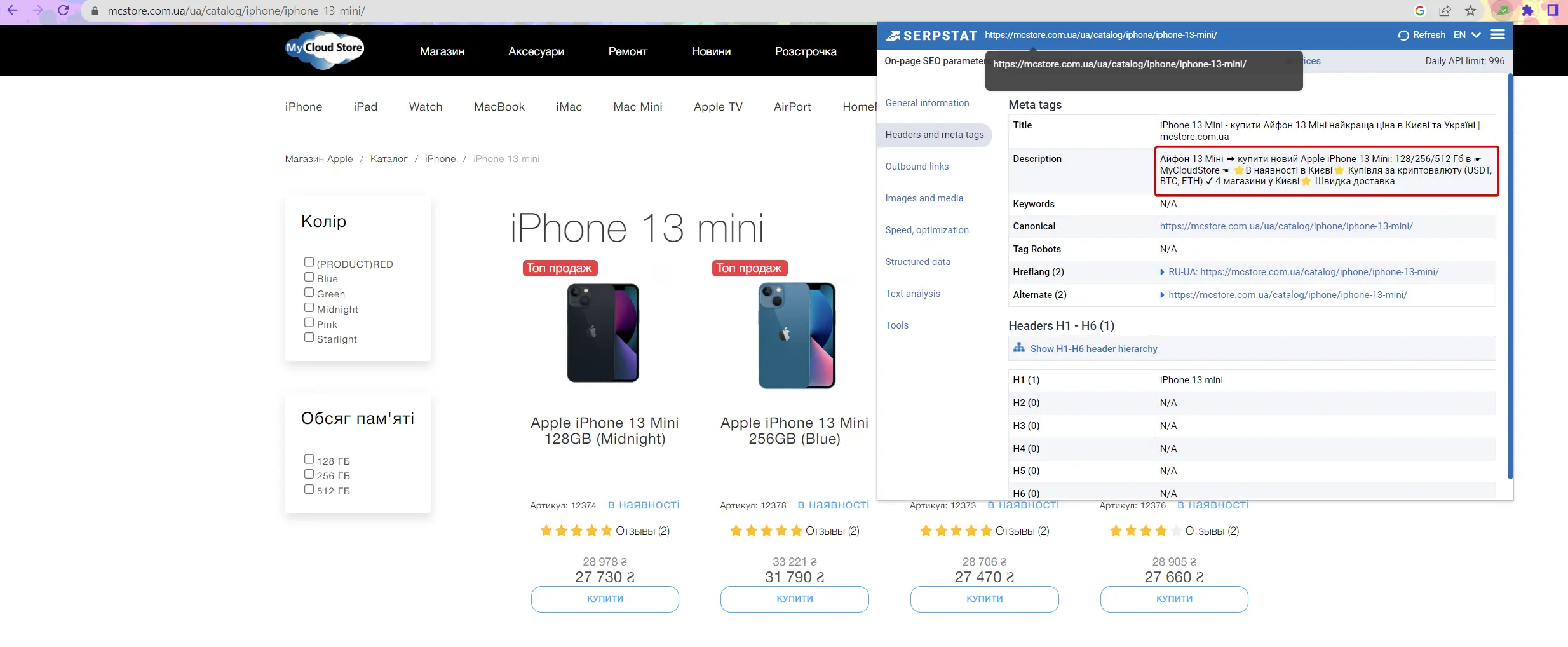

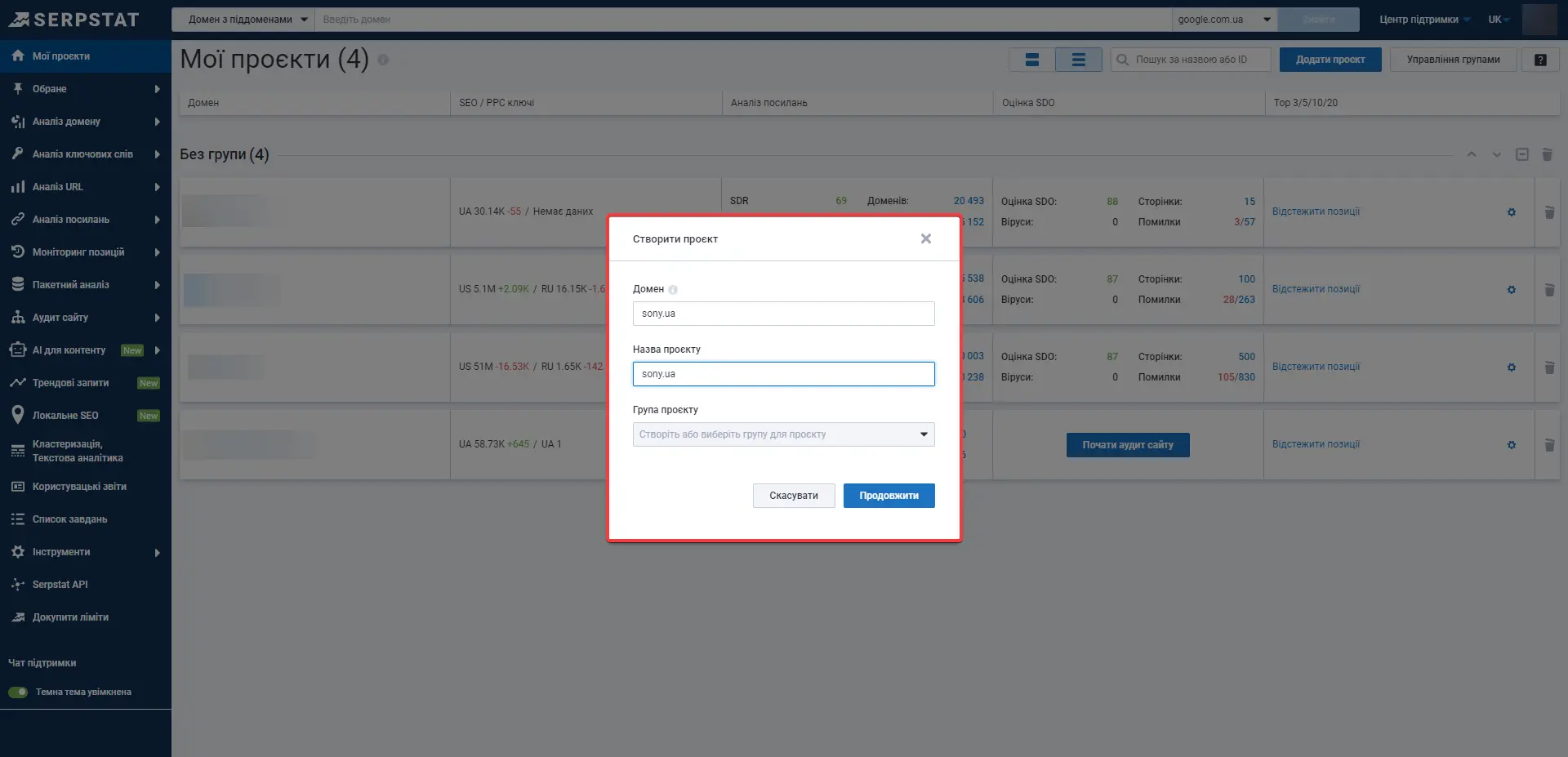

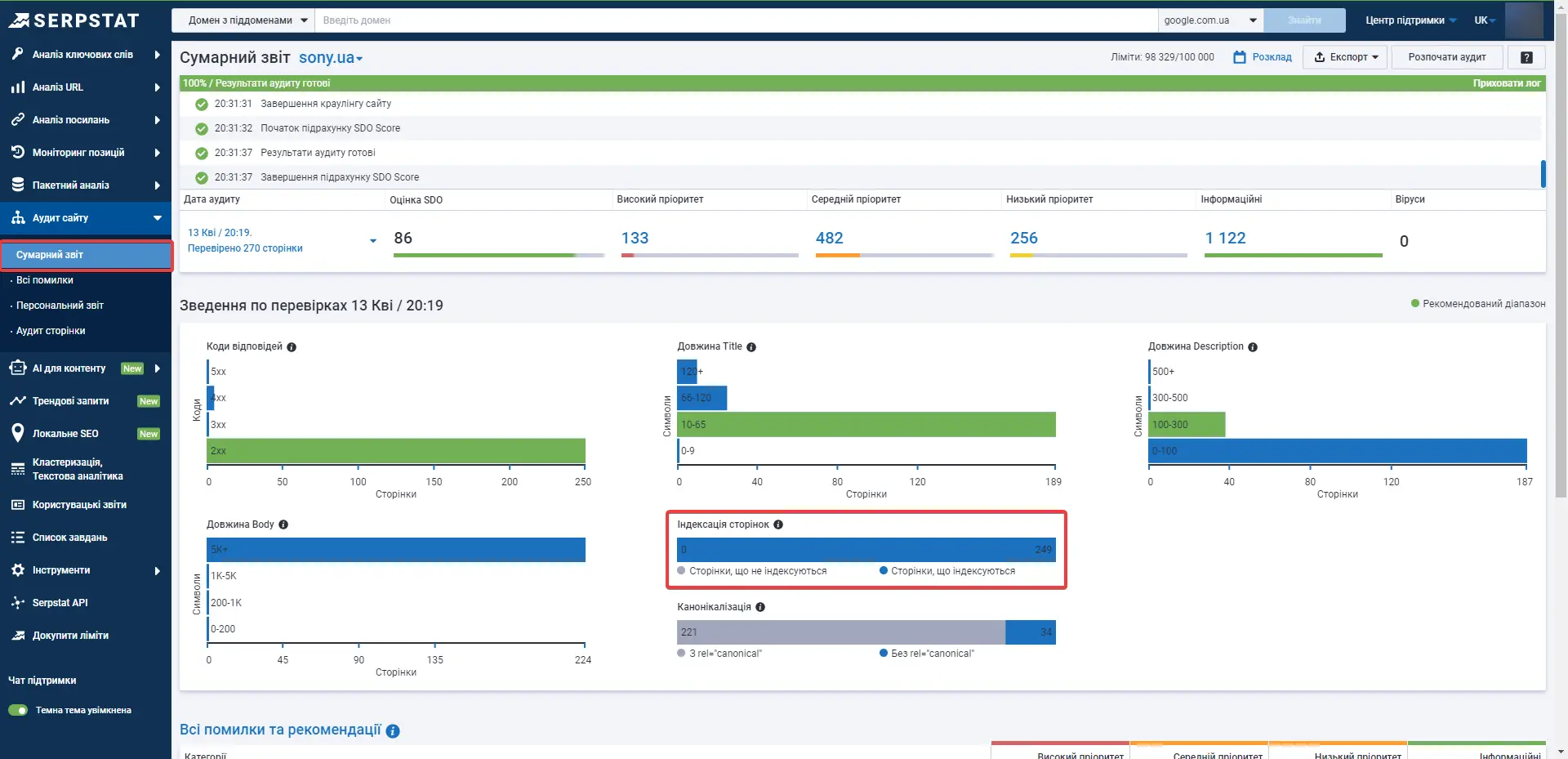

За допомогою Аудиту сайту Serpstat можна швидко перевірити сайт на наявність технічних помилок і дізнатися, скільки сторінок не проіндексовано.

Для того, щоб це зробити, потрібно всього лише натиснути на кнопку нижче, і ви матимете можливість створити проєкт для сайту ↓

Перевірити свій сайт

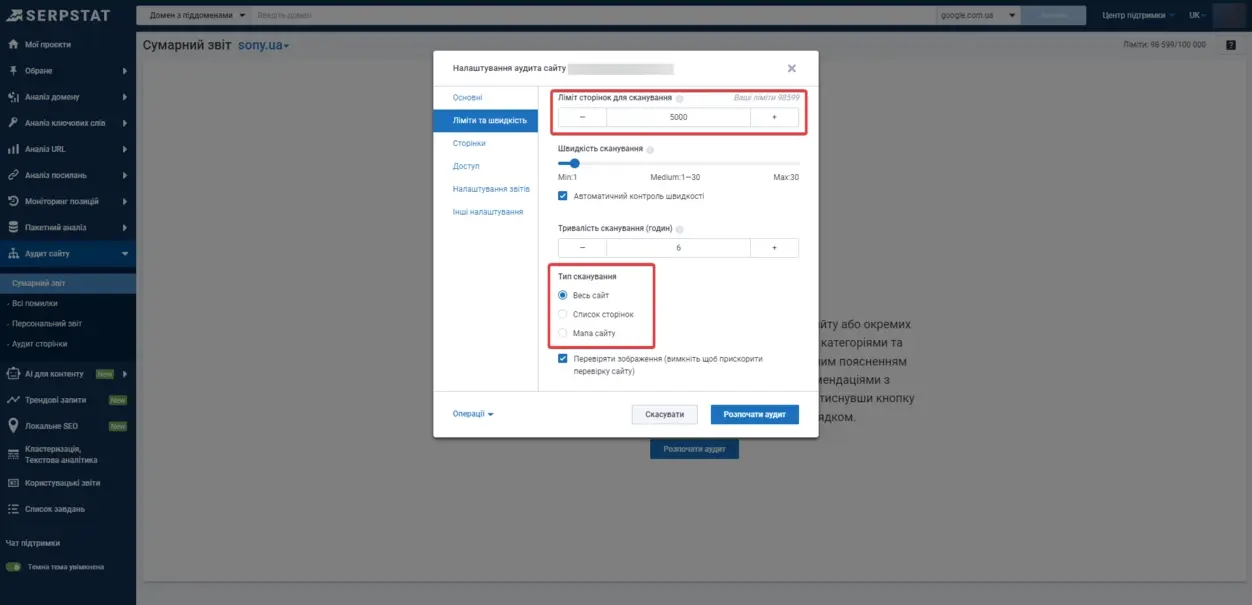

У налаштуваннях, що з'явилися, можна вказати ім'я домену і кількість сторінок, які потрібно просканувати краулеру:

Запуск аудиту в Serpstat

Вибір типу сканування та зазначення ліміту сторінок

Коли сканування буде завершено, на графіку в Сумарному звіті можна перевірити, яку кількість сторінок із зазначених в robots.txt або просканованих при типі сканування за сайтом (внутрішніми посиланнями) не проіндексовано:

Перевірка індексації сторінок в Аудиті Serpstat

Висновок

Управління індексацією — важливий етап SEO. Слід не тільки оптимізувати перспективні для трафіку сторінки, а й приховувати від індексації контент, просування якого не несе ніякої користі.

Обмеження доступу до низки сторінок і документів заощадить ресурси пошукової системи та прискорить індексацію сайту загалом.

FAQ

Заборонити доступ роботів пошукових систем до сайту можна за допомогою кількох способів:

• додавання метатегу robots зі значенням noindex у html-код;

• вказівки-директиви Disallow у файлі robots.txt;

• встановлення пароля для доступу до сайту в конфігураційному файлі .htaccess.

Також можна блокувати доступ до окремих каталогів та документів.

Щоб закрити сайт від індексації, додайте метатег name="robots" content="noindex, nofollow" до розділу всіх сторінок або додайте директиву User-agent: * Disallow: / у файл robots.txt.

Щоб закрити сайт на WordPress від індексації, зайдіть в адмінку CMS, оберіть розділ «Параметри» → «Відтворення». Знайдіть підрозділ «Видимість для пошукових систем» та позначте галочкою «Попросити пошукові системи не індексувати сайт». Після цього WordPress автоматично внесе корективи у файл robots.txt для заборони індексації.

Використовуйте кращі SEO інструменти

Підбір ключових запитів

Пошук ключових слів – розкрийте невикористаний потенціал вашого сайту

Можливості Serpstat

Можливості Serpstat – потужне комплексне рішення для ефективного просування сайтів

Кластеризація ключових запитів

Кластеризація ключових слів автоматично обробляє до 50 000 запитів у кілька кліків

SEO аудит сторінки

Проаналізуйте рівень оптимізації використовуючи SЕО аудит сторінки

Рекомендовані статті

Кейси, лайфхаки, дослідження та корисні статті

У вас немає часу стежити за новинами? Не турбуйтеся! Наш редактор підбере статті, які неодмінно допоможуть вам у роботі. Приєднуйтесь до нашої затишної спільноти :)

Натискаючи кнопку, ви погоджуєтеся з нашою Політикою конфіденційності